Apple a récemment réalisé une avancée majeure dans la vitesse de génération de grands modèles de langage (LLM). Elle a coopéré avec NVIDIA pour utiliser la technologie open source Recurrent Drafter (ReDrafter) pour presque tripler la vitesse de génération. ReDrafter utilise une méthode de décodage spéculatif pour améliorer considérablement l'efficacité de la formation des modèles et est intégré au cadre d'accélération d'inférence TensorRT-LLM de NVIDIA pour réduire davantage les coûts d'utilisation et la latence. Cette coopération améliore non seulement l'efficacité du développement, mais offre également aux utilisateurs une expérience de service plus rapide, marquant la détermination et la force d'Apple à continuer d'innover dans le domaine de l'IA. Cet article détaillera les détails de la coopération entre Apple et NVIDIA et les avantages de la technologie ReDrafter.

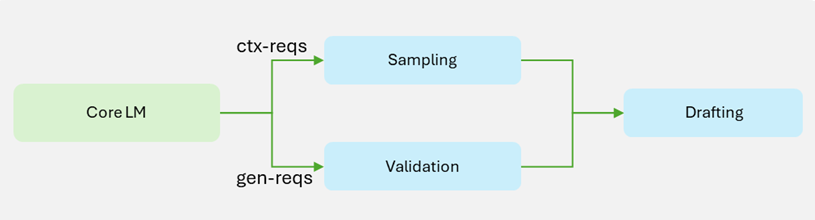

Récemment, les dernières recherches d'Apple dans le domaine de l'apprentissage automatique montrent que grâce à la coopération avec NVIDIA, ils ont réussi à multiplier par près de trois la vitesse de génération des grands modèles de langage (LLM). La clé de ces progrès réside dans la technologie open source d’Apple « Recurrent Drafter » (ReDrafter), qui utilise une méthode de décodage spéculatif qui peut améliorer considérablement l’efficacité de la formation des modèles.

Dans le passé, le processus de création de grands modèles de langage prenait généralement beaucoup de temps et de ressources, et les entreprises devaient souvent acheter un grand nombre de périphériques matériels, augmentant ainsi les coûts d'exploitation. Plus tôt en 2024, Apple a lancé ReDrafter, une technologie qui combine des réseaux neuronaux récursifs et des méthodes dynamiques d'attention aux arbres pour générer et vérifier rapidement des balises, augmentant ainsi la vitesse de génération de balises de 3,5 fois par rapport aux méthodes de régression automatique traditionnelles.

Cette semaine, Apple a en outre annoncé que sa coopération avec NVIDIA intégrerait ReDrafter dans le cadre d'accélération d'inférence TensorRT-LLM de NVIDIA. Cette décision permettra aux développeurs de machine learning utilisant des GPU NVIDIA de profiter des capacités d'accélération de ReDrafter dans les environnements de production. Il convient de mentionner que même si les serveurs multi-GPU hautes performances sont généralement coûteux, cette coopération peut réduire la latence tout en réduisant la quantité de matériel requis, ce qui donne lieu à une solution plus économique.

Lors des tests de référence avec NVIDIA, l'efficacité de la génération à l'aide de ReDrafter a été considérablement améliorée, avec une augmentation de 2,7 fois de la génération de jetons par seconde en mode d'encodage gourmand. Cela signifie que les développeurs peuvent obtenir plus de résultats en moins de temps et offrir aux utilisateurs une expérience de service plus rapide.

Après avoir confirmé sa coopération avec NVIDIA, Apple a également déclaré qu'elle envisageait d'utiliser la puce Trainium2 d'Amazon pour améliorer l'efficacité de la formation des modèles. On s'attend à ce que l'efficacité de la pré-formation utilisant Trainium2 soit améliorée de 50 % par rapport au matériel existant.

Blog officiel : https://developer.nvidia.com/blog/nvidia-tensorrt-llm-now-supports-recurrent-drafting-for-optimizing-llm-inference/

Souligner:

Apple s'associe à NVIDIA pour presque tripler la vitesse de génération de modèles de langage à grande échelle.

La technologie open source ReDrafter se combine avec les réseaux de neurones récurrents pour améliorer considérablement l'efficacité de la formation des modèles.

Cette collaboration permet de réduire les coûts et de fournir des solutions plus efficaces aux développeurs de machine learning.

Dans l'ensemble, la coopération entre Apple et NVIDIA et l'application de la technologie ReDrafter ont apporté des améliorations significatives en termes d'efficacité et des réductions de coûts dans le développement et l'application de grands modèles de langage. Cela favorise non seulement le progrès technologique dans le domaine de l'intelligence artificielle, mais apporte également des solutions plus pratiques et plus économiques aux développeurs et aux utilisateurs, ce qui indique le développement vigoureux des applications d'IA à l'avenir.