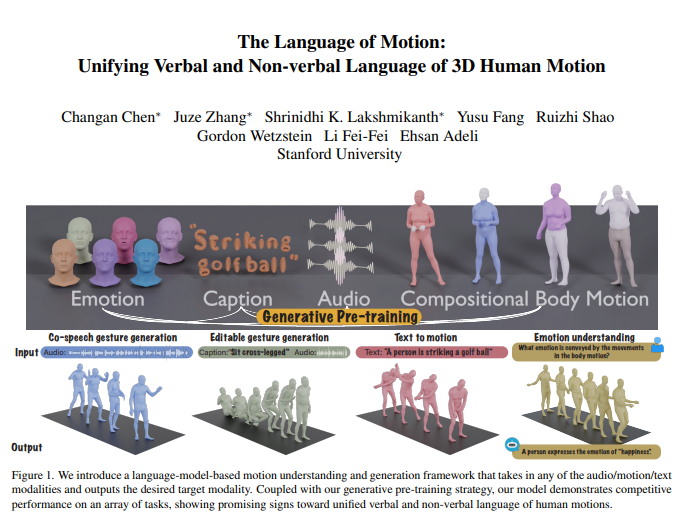

L'équipe de Li Feifei a récemment publié un résultat de recherche révolutionnaire : un nouveau modèle multimodal capable de comprendre et de générer des actions humaines, et de combiner intelligemment des modèles de langage pour obtenir un traitement unifié du langage verbal et non verbal. Cette innovation permet non seulement aux machines de comprendre les instructions humaines, mais également d’interpréter les émotions derrière les actions, permettant ainsi une interaction homme-machine plus naturelle et plus fluide. Le cœur du modèle réside dans son cadre de modèle de langage multimodal, qui peut intégrer plusieurs entrées telles que l'audio, le mouvement et le texte, et générer les données modales correspondantes. Il fonctionne bien sur des tâches telles que la génération collaborative de gestes vocaux, réduit considérablement la quantité de données requises pour la formation du modèle et étend de nouveaux scénarios d'application tels que la génération de gestes modifiables et la prédiction d'émotions via des actions.

L'équipe de Li Feifei a lancé un nouveau modèle multimodal capable de comprendre et de générer des actions humaines, et en combinant des modèles de langage, elle parvient à un traitement unifié du langage verbal et non verbal. Cette recherche révolutionnaire permet aux machines non seulement de comprendre les instructions humaines, mais également de lire les émotions contenues dans les actions, permettant ainsi une interaction homme-machine plus naturelle.

Le cœur du modèle réside dans son cadre de modèle de langage multimodal, qui peut recevoir plusieurs formes d'entrée telles que l'audio, le mouvement et le texte, et générer les données modales requises. Combiné à une stratégie de pré-formation générative, le modèle présente d'excellentes performances sur plusieurs tâches. Par exemple, dans la génération collaborative de gestes vocaux, le modèle dépasse non seulement l’état de l’art, mais réduit également considérablement la quantité de données requises pour la formation. En outre, le modèle débloque également de nouveaux scénarios d'application, tels que la génération de gestes modifiables et la prédiction d'émotions via des actions.

La communication humaine est de nature multimodale et comprend des signaux verbaux et non verbaux tels que la parole, les expressions faciales et la posture du corps. La capacité de ce modèle à comprendre ces comportements multimodaux est essentielle pour créer des personnages virtuels qui communiquent naturellement dans des applications telles que les jeux, les films et la réalité virtuelle. Cependant, les modèles de génération d’actions existants sont souvent limités à des modalités d’entrée spécifiques (parole, texte ou données d’action) et ne parviennent pas à exploiter pleinement la diversité des données disponibles.

Ce modèle utilise des modèles de langage pour unifier le langage verbal et non verbal pour trois raisons principales :

Les modèles linguistiques connectent naturellement différentes modalités.

La parole est hautement sémantique et des tâches telles que la modélisation de réponses à des blagues nécessitent de solides capacités de raisonnement sémantique.

Le modèle de langage acquiert de fortes capacités de compréhension sémantique grâce à une pré-formation approfondie.

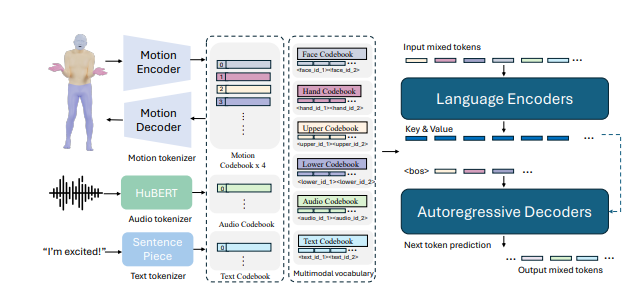

Pour y parvenir, l’équipe de recherche a d’abord divisé le corps en différentes parties (visage, mains, haut du corps, bas du corps) et a étiqueté chaque partie individuellement en fonction du mouvement. En combinant des tokeniseurs de texte et de parole, la saisie dans n'importe quelle modalité peut être représentée comme une série de jetons destinés à être utilisés par les modèles de langage. Le modèle adopte un processus de formation en deux étapes : une première pré-formation pour obtenir l'alignement de diverses modalités avec des mouvements corporels combinés, ainsi que l'alignement de l'audio et du texte. Ensuite, les tâches en aval sont converties en instructions et le modèle est formé sur ces instructions afin de pouvoir suivre diverses instructions de tâches.

Le modèle a bien fonctionné sur le benchmark de génération collaborative de gestes vocaux BEATv2, dépassant de loin les modèles existants. L'effet de la stratégie de pré-formation a également été vérifié, notamment lorsque les données sont rares, démontrant une forte capacité de généralisation. Grâce à une post-formation sur les tâches de parole-action et de texte-action, le modèle peut non seulement suivre des invites audio et textuelles, mais également réaliser de nouvelles fonctions telles que la prédiction des émotions à partir des données d'action.

Dans les détails techniques, le modèle utilise des tokenizers spécifiques aux modalités pour gérer diverses modalités d'entrée. Plus précisément, le modèle entraîne un mouvement corporel combiné VQ-VAE qui convertit les mouvements du visage, des mains, du haut et du bas du corps en marqueurs discrets. Ces vocabulaires spécifiques aux modalités (audio et texte) sont combinés en un vocabulaire multimodal unifié. Pendant la formation, des jetons mixtes de différentes modalités sont utilisés comme entrée et la sortie est générée par un modèle de langage codeur-décodeur.

Le modèle utilise également un vocabulaire multimodal pour convertir différentes données modales en un format unifié pour le traitement. Au cours de la phase de pré-formation, le modèle apprend la correspondance entre les différentes modalités en effectuant des tâches de conversion entre les modalités. Par exemple, un modèle peut apprendre à traduire les mouvements du haut du corps en mouvements du bas du corps, ou à convertir l'audio en texte. De plus, le modèle apprend l'évolution temporelle des actions en masquant aléatoirement certaines images d'action.

Dans la phase post-formation, le modèle est affiné à l'aide de données appariées pour effectuer des tâches en aval telles que la génération collaborative de gestes vocaux ou la génération de texte en action. Pour permettre au modèle de suivre les instructions humaines naturelles, les chercheurs ont construit un modèle de suivi d'instructions multitâches qui convertit des tâches telles que l'audio en action, le texte en action et l'émotion en action en instructions. Le modèle a également la capacité de modifier les gestes pour générer des mouvements coordonnés de tout le corps basés sur des signaux textuels et audio.

Enfin, le modèle ouvre également de nouvelles capacités pour prédire les émotions liées aux actions. Cela a des implications importantes dans des domaines tels que la santé mentale ou la psychiatrie. Ce modèle est capable de prédire avec plus de précision les émotions exprimées dans les actions que les autres modèles, démontrant de fortes capacités de compréhension du langage corporel.

La recherche montre que l’unification du langage verbal et non verbal des actions humaines est essentielle pour les applications pratiques, et les modèles linguistiques fournissent un cadre puissant pour cela.

Adresse papier : https://arxiv.org/pdf/2412.10523v1

Dans l’ensemble, ces recherches ont apporté des progrès significatifs dans le domaine de l’intelligence artificielle multimodale. Son potentiel d’application dans l’interaction homme-machine, la création de personnages virtuels et la reconnaissance des émotions est énorme et mérite une attention et des recherches plus approfondies. À l’avenir, ce modèle devrait jouer un rôle dans davantage de domaines et promouvoir le développement de la technologie de l’intelligence artificielle.