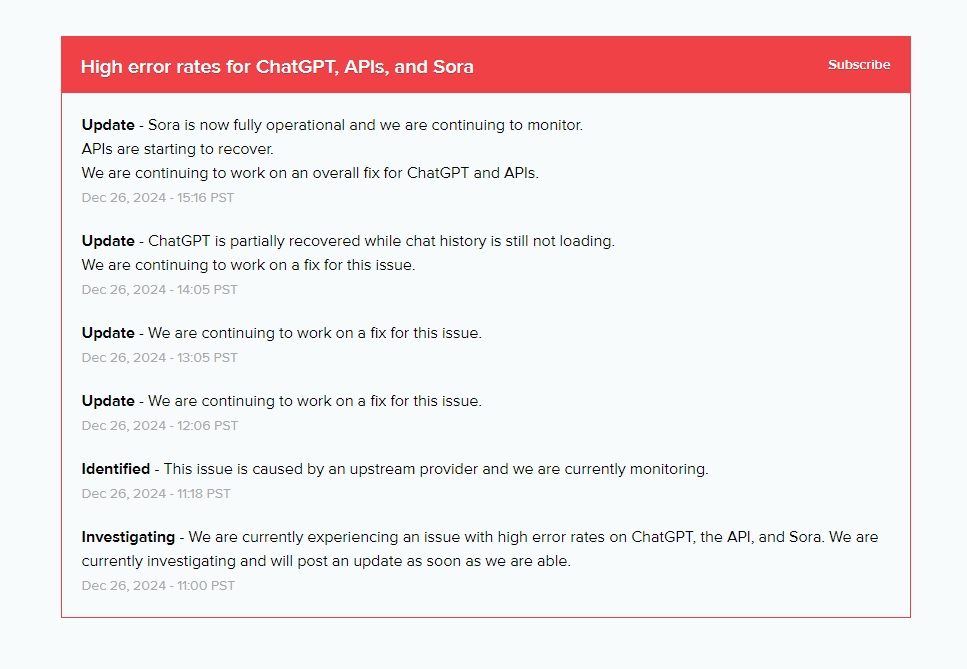

Tôt le matin du 27 décembre, heure de Pékin, le service d'IA d'OpenAI a subi une interruption à grande échelle, affectant ChatGPT, Sora et certains appels API. La panne a suscité une inquiétude généralisée car les utilisateurs n'ont pas pu utiliser ces services. Bien qu'OpenAI ait annoncé à 6h05 que ChatGPT avait partiellement repris son service, la fonction de chargement de l'historique des discussions est toujours limitée et le temps de récupération complet n'a pas encore été déterminé. OpenAI n'a pas précisé la cause spécifique de la panne, la qualifiant simplement de "problème causé par le fournisseur en amont". Microsoft Azure a également signalé des problèmes d'alimentation dans ses centres de données, suggérant une possible connexion entre les deux.

À 6 h 05, OpenAI a annoncé que ChatGPT avait partiellement repris son service, mais la fonction de chargement de l'historique des discussions était toujours limitée et le délai de récupération complète n'a pas encore été déterminé.

Concernant la cause spécifique de l'interruption de service, OpenAI a seulement déclaré qu'elle était « causée par le fournisseur en amont ». Microsoft Azure, le fournisseur de services cloud exclusif d'OpenAI, a également signalé un problème « d'alimentation électrique » dans son centre de données le même jour.

Ce n'est pas la première fois que le service ChatGPT subit des interruptions. Des interruptions de service similaires se sont produites à plusieurs reprises au cours des derniers mois.

La panne du service OpenAI a une fois de plus mis en évidence les problèmes de stabilité des services de modèles de langage à grande échelle et nous a rappelé de rester vigilants quant aux risques liés à la dépendance à de tels services. À l’avenir, les entreprises d’IA devront se concentrer sur l’amélioration de la stabilité des services et des plans d’urgence pour garantir l’expérience utilisateur et la sécurité des données.