NVIDIA a rapidement lancé les GPU GB300 et B300, obtenant des améliorations significatives des performances six mois seulement après la sortie des GB200 et B200, en particulier dans les modèles d'inférence. Il ne s'agit pas seulement d'une simple mise à niveau matérielle, mais représente également un ajustement stratégique de NVIDIA dans le domaine de l'accélération de l'IA, qui aura un impact profond sur l'industrie. Le cœur de cette mise à niveau réside dans un énorme bond en avant dans les performances d'inférence, ainsi que dans l'optimisation de la mémoire et de l'architecture, qui affecteront directement l'efficacité et le coût des grands modèles de langage.

Seulement 6 mois après la sortie des GB200 et B200, Nvidia a de nouveau lancé de nouveaux GPU-GB300 et B300. Cela peut sembler une petite mise à niveau, mais en réalité, cela contient d'énormes changements, notamment l'amélioration significative des performances du modèle d'inférence, qui aura un impact profond sur l'ensemble du secteur.

B300/GB300 : un énorme bond en avant dans les performances d'inférence

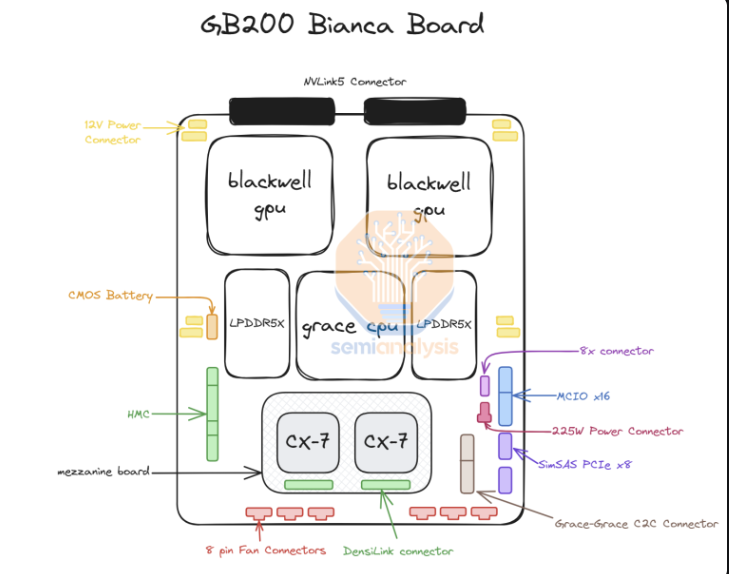

Le B300GPU utilise le nœud de processus 4NP de TSMC et est optimisé pour les puces informatiques. Cela rend les performances FLOPS du B300 50 % supérieures à celles du B200. Une partie de l'amélioration des performances provient de l'augmentation du TDP. Le TDP du GB300 et du B300HGX atteint respectivement 1,4 kW et 1,2 kW (le GB200 et le B200 sont respectivement de 1,2 kW et 1 kW). Les gains de performances restants proviennent d'améliorations architecturales et d'optimisations au niveau du système, telles que l'allocation dynamique de puissance entre le CPU et le GPU.

En plus de l'augmentation des FLOPS, la mémoire a également été mise à niveau vers 12-Hi HBM3E et la capacité HBM de chaque GPU a été augmentée à 288 Go. Cependant, la vitesse des broches reste inchangée, donc la bande passante mémoire par GPU est toujours de 8 To/s. Il convient de noter que Samsung n'a pas réussi à entrer dans la chaîne d'approvisionnement du GB200 ou du GB300.

De plus, Nvidia a également procédé à des ajustements de prix. Cela affectera dans une certaine mesure la marge bénéficiaire des produits Blackwell, mais plus important encore, l'amélioration des performances du B300/GB300 se reflétera principalement dans le modèle d'inférence.

Adapté aux modèles d'inférence

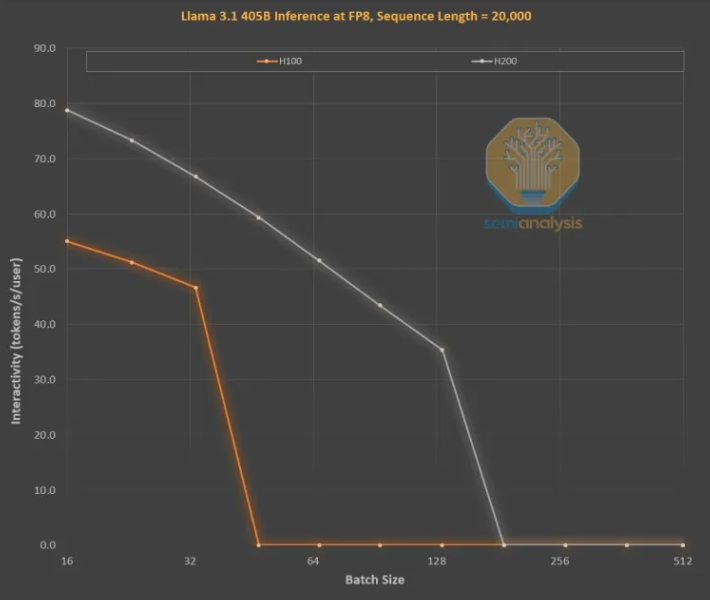

Les améliorations de la mémoire sont essentielles pour la formation à l'inférence LLM de style OpenAI O3, car les longues séquences augmentent KVCache, limitant la taille et la latence critiques des lots. La mise à niveau du H100 vers le H200 (principalement l'augmentation de la mémoire) a apporté des améliorations sur les deux aspects suivants :

Une bande passante mémoire plus élevée (4,8 To/s sur le H200 et 3,35 To/s sur le H100) a entraîné une amélioration générale de 43 % de l'interactivité sur toutes les tailles de lots comparables.

Étant donné que le H200 exécute une taille de lot plus grande que le H100, le nombre de jetons générés par seconde augmente de 3 fois et le coût est réduit d'environ 3 fois. Cette différence est principalement due au fait que KVCache limite la taille totale du lot.

L’amélioration des performances d’une plus grande capacité de mémoire est énorme. Les différences de performances et économiques entre les deux GPU sont bien plus importantes que ne le suggèrent leurs spécifications :

L'expérience utilisateur avec les modèles d'inférence peut être médiocre en raison d'une latence importante entre les requêtes et les réponses. Si le temps d'inférence peut être considérablement accéléré, la volonté des utilisateurs d'utiliser et de payer augmentera.

L'amélioration 3x des performances matérielles grâce aux mises à niveau de mémoire de mi-génération est stupéfiante et bien plus rapide que la loi de Moore, la loi de Huang ou toute autre amélioration matérielle que nous avons vue.

Dans l'ensemble, le lancement de NVIDIA B300/GB300 n'est pas seulement un autre bond en avant dans la technologie GPU, mais aussi une forte promotion de l'application des modèles d'inférence d'IA. Il améliorera considérablement l'expérience utilisateur et réduira les coûts, conduisant l'industrie de l'IA à. entrer dans une nouvelle étape de développement.