La formation de grands modèles d’IA est coûteuse et ses énormes besoins en ressources limitent leur application généralisée et soulèvent des inquiétudes quant à l’efficacité énergétique et à l’impact environnemental. Les méthodes de formation traditionnelles sont inefficaces, reposent sur des matrices denses et nécessitent de grandes quantités de mémoire et de puissance de calcul. Bien que certaines méthodes existantes tentent d’atténuer ces problèmes, elles présentent encore des limites dans leurs applications pratiques. Il est donc crucial de développer une approche capable de réduire simultanément l’utilisation de la mémoire, les coûts de calcul et le temps de formation sans compromettre les performances.

La formation de modèles d'IA à grande échelle (tels que les Transformers et les modèles de langage) est devenue un maillon clé indispensable dans le domaine de l'IA, mais elle est également confrontée à des coûts de calcul, une consommation de mémoire et des besoins énergétiques élevés. Par exemple, le GPT-3 d'OpenAI possède 175 milliards de paramètres et nécessite des semaines de formation GPU. Cet énorme besoin en ressources limite l'application de cette technologie aux organisations à grande échelle disposant de ressources informatiques abondantes, tout en exacerbant également les préoccupations concernant l'efficacité énergétique et l'impact environnemental. Il est essentiel de relever ces défis pour garantir une plus grande accessibilité et une plus grande durabilité au développement de l’IA.

Les méthodes de formation traditionnelles sont inefficaces et des solutions innovantes sont nécessaires de toute urgence

Framework CoMERA : formation efficace grâce à l'optimisation adaptative du tenseur

La base de CoMERA est une représentation tensorielle adaptative, qui permet aux couches de modèles d'ajuster dynamiquement leurs classements en fonction des contraintes de ressources. En modifiant le rang du tenseur, le cadre permet la compression sans compromettre l'intégrité opérationnelle du réseau neuronal. Cette optimisation dynamique est réalisée grâce à un processus de formation en deux étapes :

Premières étapes : se concentrer sur une convergence stable.

Étapes ultérieures : affiner le classement pour atteindre des objectifs de compression spécifiques.

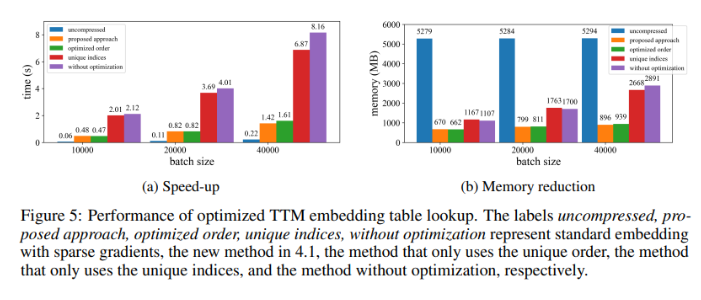

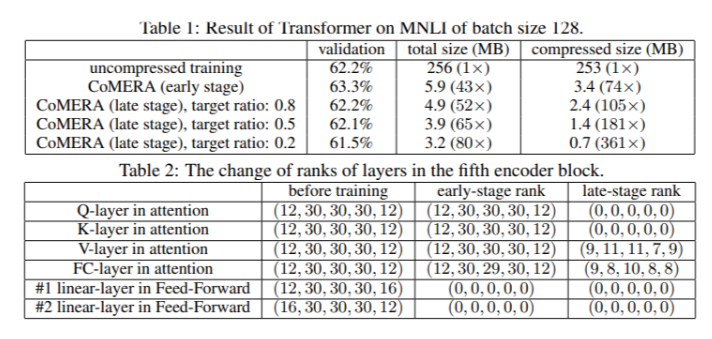

Dans un modèle Transformer à six encodeurs, CoMERA a atteint un taux de compression allant jusqu'à 43x dans ses premières étapes, et un taux de compression encore plus élevé de 361x dans ses étapes d'optimisation ultérieures. De plus, il réduit la consommation de mémoire de 9 fois et accélère l'entraînement de 2 à 3 fois par tour par rapport à GaLore.

Les résultats de plusieurs tests montrent que CoMERA a d'excellentes performances

Lorsqu'il est appliqué à un modèle Transformer formé sur l'ensemble de données MNLI, CoMERA réduit la taille du modèle de 256 Mo à 3,2 Mo tout en conservant la précision. Dans les systèmes de recommandation à grande échelle tels que DLRM, CoMERA compresse les modèles par 99 et réduit l'utilisation maximale de la mémoire par 7. Le framework a également bien fonctionné lors de la pré-formation de CodeBERT, un modèle de langage à grande échelle spécifique à un domaine, atteignant un taux de compression global de 4,23x et une accélération de 2x dans certaines étapes de formation. Ces résultats mettent en évidence sa capacité à gérer une variété de tâches et d'architectures, étendant ainsi son applicabilité dans divers domaines.

Résumé des principaux avantages du cadre CoMERA

Les principales conclusions de cette étude sont les suivantes :

CoMERA atteint des taux de compression allant jusqu'à 361x pour des couches spécifiques et 99x pour l'ensemble du modèle, réduisant considérablement les besoins en stockage et en mémoire.

Ce cadre réduit de 2 à 3 fois le temps de formation de chaque cycle de Transformer et de systèmes de recommandation, économisant ainsi du temps et des ressources informatiques.

En utilisant des représentations tensorisées et des graphiques CUDA, CoMERA réduit de 7 fois la consommation maximale de mémoire, ce qui rend possible l'entraînement sur des GPU plus petits.

L'approche de CoMERA prend en charge plusieurs architectures, notamment les Transformers et les grands modèles de langage, tout en maintenant ou en améliorant la précision.

En réduisant l'énergie et les ressources nécessaires à la formation, CoMERA contribue à permettre des pratiques d'IA plus durables et met des modèles de pointe à la disposition d'un public plus large.

Dans l’ensemble, le framework CoMERA fournit une solution révolutionnaire pour entraîner efficacement de grands modèles d’IA, ce qui réduit considérablement les coûts de calcul et les besoins en mémoire grâce à l’optimisation adaptative du tenseur tout en maintenant la précision du modèle. Cette recherche apporte une contribution importante au développement continu et à une plus grande accessibilité du domaine de l’IA.