L'équipe Qwen a rendu open source son dernier modèle de raisonnement multimodal QVQ, qui repose sur Qwen2-VL-72B et améliore considérablement la compréhension visuelle et les capacités de raisonnement de l'IA. QVQ a obtenu un score élevé de 70,3 lors de l'examen MMMU et a surpassé son modèle prédécesseur dans plusieurs tests mathématiques. Cet article présentera en détail les caractéristiques, les avantages, les limites et l'utilisation du modèle QVQ, et fournira des liens pertinents pour permettre aux lecteurs de mieux le comprendre et de l'utiliser.

L'équipe Qwen a récemment annoncé l'open source de son dernier modèle de raisonnement multimodal QVQ, marquant une étape importante dans la compréhension visuelle et les capacités de résolution de problèmes complexes de l'intelligence artificielle. Ce modèle est construit sur Qwen2-VL-72B et vise à améliorer les capacités de raisonnement de l'IA en combinant le langage et les informations visuelles. Lors de l'évaluation MMMU, QVQ a obtenu un score élevé de 70,3 et a montré des améliorations significatives de ses performances par rapport à Qwen2-VL-72B-Instruct dans plusieurs tests de référence liés aux mathématiques.

Le modèle QVQ a montré des avantages particuliers dans les tâches de raisonnement visuel, en particulier dans les domaines nécessitant une pensée analytique complexe. Malgré les excellentes performances de QVQ-72B-Preview, l'équipe a également souligné certaines limites du modèle, notamment des problèmes de mélange de langues et de changement de code, la possibilité de tomber dans des modèles logiques circulaires, des considérations de sécurité et d'éthique, ainsi que des limitations de performances et de référence. L'équipe a souligné que même si le modèle s'est amélioré en termes de raisonnement visuel, il ne peut pas remplacer complètement la capacité du Qwen2-VL-72B. Au cours du processus de raisonnement visuel en plusieurs étapes, le modèle peut progressivement perdre sa concentration sur le contenu de l'image, conduisant à des hallucinations.

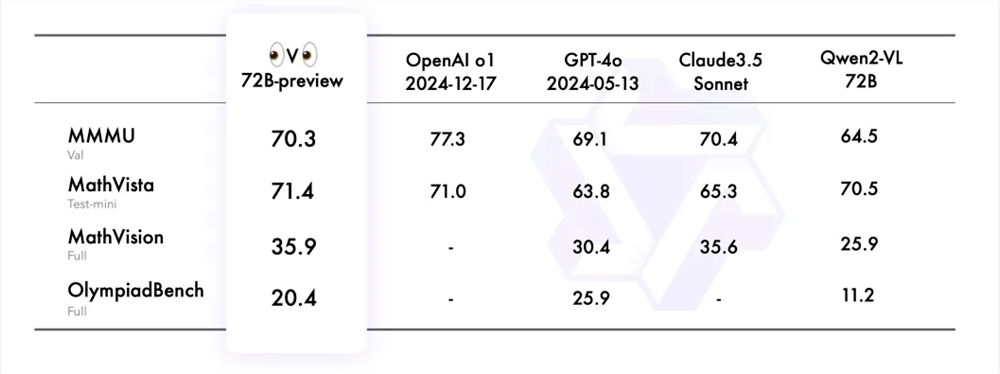

L'équipe Qwen a évalué QVQ-72B-Preview sur quatre ensembles de données, dont MMMU, MathVista, MathVision et OlympiadBench. Ces ensembles de données sont conçus pour examiner la compréhension globale du modèle et ses capacités de raisonnement liées à la vision. Le QVQ-72B-Preview a obtenu de bons résultats dans ces tests, réduisant ainsi l'écart avec le modèle leader.

Pour démontrer davantage l'application du modèle QVQ dans les tâches de raisonnement visuel, l'équipe Qwen a fourni plusieurs exemples et partagé un lien vers le blog technique. En outre, l'équipe a également fourni des exemples de code pour l'inférence de modèle et comment utiliser Magic API-Inference pour appeler directement le modèle QVQ-72B-Preview. L'inférence API de Magic Platform prend en charge le modèle QVQ-72B-Preview et les utilisateurs peuvent utiliser directement le modèle via des appels API.

Lien du modèle :

https://modelscope.cn/models/Qwen/QVQ-72B-Preview

Lien d'expérience :

https://modelscope.cn/studios/Qwen/QVQ-72B-preview

Blog chinois :

https://qwenlm.github.io/zh/blog/qvq-72b-preview

L'open source du modèle QVQ fournit des ressources précieuses pour la recherche sur l'intelligence artificielle multimodale et annonce également le développement futur de l'IA dans le domaine du raisonnement visuel. Bien qu'il existe certaines limites, ses excellentes performances dans de nombreux tests de référence restent impressionnantes. Nous attendons avec impatience de poursuivre l’optimisation et l’amélioration du modèle QVQ à l’avenir.