Magic Square Quantitative a récemment publié une nouvelle génération de grand modèle DeepSeek-V3. Son échelle de paramètres de 671 milliards et son architecture MoE rendent ses performances comparables à celles des meilleurs modèles à source fermée. Il présente également les caractéristiques d'un faible coût et d'une efficacité élevée, ce qui a séduit un large public. attention dans l'industrie. DeepSeek-V3 a obtenu de bons résultats dans de nombreux tests, surpassant notamment tous les modèles existants dans le test de capacité mathématique, et fournit des services API à un prix nettement inférieur à celui des modèles tels que GPT-4, offrant ainsi aux développeurs et aux entreprises une solution d'IA rentable. Cet article analysera en détail les performances, les coûts et la stratégie de commercialisation de DeepSeek-V3, et discutera de son impact sur l'industrie de l'IA.

Magic Square Quantitative a lancé dans la soirée du 26 décembre une nouvelle génération de grand modèle DeepSeek-V3, démontrant une avancée technologique étonnante. Ce modèle utilisant l'architecture MoE (Mixed Experts) est non seulement comparable en termes de performances aux meilleurs modèles à source fermée, mais ses fonctionnalités à faible coût et à haute efficacité ont attiré l'attention de l'industrie.

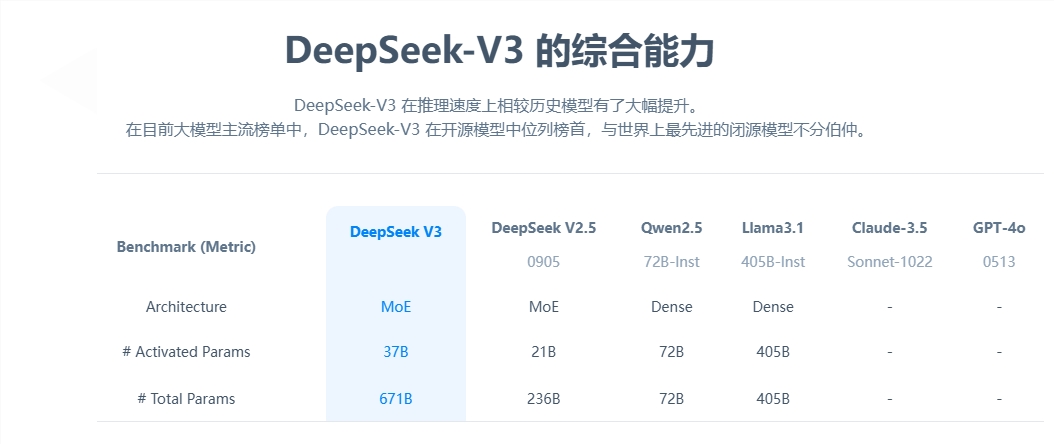

Du point de vue des paramètres de base, DeepSeek-V3 compte 671 milliards de paramètres, dont 37 milliards de paramètres d'activation, et a terminé la pré-formation sur une échelle de données de 14,8 billions de jetons. Par rapport au produit de la génération précédente, la vitesse de génération du nouveau modèle a été multipliée par 3 et il peut traiter 60 jetons par seconde, améliorant considérablement l'efficacité des applications pratiques.

En termes d'évaluation des performances, DeepSeek-V3 montre une excellente solidité. Il surpasse non seulement les modèles open source bien connus tels que Qwen2.5-72B et Llama-3.1-405B, mais est également à égalité avec GPT-4 et Claude-3.5-Sonnet dans plusieurs tests. En particulier lors du test de capacité mathématique, le modèle a surpassé tous les modèles open source et fermé existants avec d'excellents résultats.

La chose la plus frappante est l’avantage de DeepSeek-V3 en termes de faible coût. Selon des documents open source, calculés à 2 dollars par heure GPU, le coût total de formation du modèle n'est que de 5,576 millions de dollars. Ce résultat révolutionnaire est dû à l’optimisation collaborative des algorithmes, des frameworks et du matériel. Karpathy, co-fondateur d'OpenAI, en a fait l'éloge, soulignant que DeepSeek-V3 a atteint des performances dépassant Llama3 en seulement 2,8 millions d'heures GPU et que l'efficacité informatique a été multipliée par environ 11.

En termes de commercialisation, bien que le prix du service API de DeepSeek-V3 ait été augmenté par rapport à la génération précédente, il conserve toujours un coût élevé. La nouvelle version coûte entre 0,5 et 2 yuans par million de jetons d'entrée et 8 yuans par million de jetons de sortie, pour un coût total d'environ 10 yuans. En comparaison, le prix du service équivalent du GPT-4 est d'environ 140 yuans, et l'écart de prix est important.

En tant que grand modèle open source complet, la sortie de DeepSeek-V3 démontre non seulement les progrès de la technologie chinoise d'IA, mais offre également aux développeurs et aux entreprises une solution d'IA hautes performances et à faible coût.

L'émergence de DeepSeek-V3 marque une avancée majeure dans la technologie chinoise de l'IA dans le domaine des modèles linguistiques à grande échelle. Ses avantages en termes de faible coût et de hautes performances la rendent hautement compétitive dans les applications commerciales, et son développement futur mérite d'être attendu. . L'open source de ce modèle apporte également des ressources précieuses à la communauté mondiale de l'IA et favorise le partage et le développement de la technologie de l'IA.