La plateforme ouverte Kimi est sur le point de lancer les tests internes très attendus de la fonction Context Caching. Cette technologie innovante améliorera considérablement l'expérience utilisateur des grands modèles de texte long. En mettant en cache le contenu des jetons en double, la mise en cache contextuelle peut réduire considérablement le coût des utilisateurs demandant le même contenu et améliorer considérablement la vitesse de réponse de l'interface API. Ceci est particulièrement important pour les scénarios d'application qui nécessitent des requêtes fréquentes et des références répétées à un grand nombre de contextes initiaux, tels que les scénarios d'invites à grande échelle et très répétitifs.

Nouvelles de ChinaZ.com du 20 juin : Kimi Open Platform a récemment annoncé que la très attendue fonction de mise en cache de contexte lancerait bientôt des tests internes. Cette fonctionnalité innovante prendra en charge de grands modèles de texte long et offrira aux utilisateurs une expérience sans précédent grâce à un mécanisme de mise en cache contextuelle efficace.

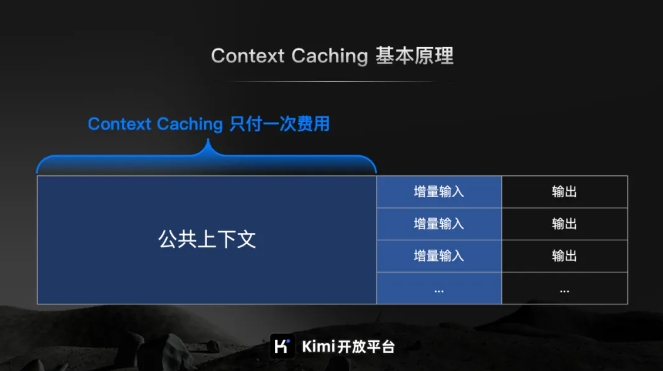

Selon l'introduction officielle de Kimi Open Platform, Context Caching est une technologie de pointe conçue pour réduire considérablement le coût des utilisateurs demandant le même contenu en mettant en cache le contenu des jetons en double. Son principe de fonctionnement est d'identifier et de stocker intelligemment les fragments de texte traités. Lorsque l'utilisateur le demande à nouveau, le système peut les récupérer rapidement du cache, améliorant ainsi considérablement la vitesse de réponse de l'interface API.

Pour les scénarios d’invites à grande échelle et très répétitifs, les avantages de la fonction Context Caching sont particulièrement significatifs. Il peut répondre rapidement à un grand nombre de requêtes fréquentes et améliorer considérablement l’efficacité du traitement tout en réduisant les coûts grâce à la réutilisation du contenu mis en cache.

Il convient particulièrement de mentionner que la fonction Context Caching est particulièrement adaptée aux scénarios d'application qui nécessitent des requêtes fréquentes et des références répétées à un grand nombre de contextes initiaux. Grâce à cette fonctionnalité, les utilisateurs peuvent facilement mettre en œuvre une mise en cache contextuelle efficace, améliorant ainsi l'efficacité du travail et réduisant les coûts d'exploitation.

Les tests internes de la fonction Context Caching sont sur le point de commencer, ce qui marque une étape importante franchie par la plateforme ouverte Kimi pour améliorer l'efficacité des grands modèles et réduire les coûts d'utilisation.