L'Université de Pékin a collaboré avec l'équipe Kuaishou AI pour développer un nouveau cadre de génération vidéo appelé VideoTetris, qui a résolu avec succès le problème de la génération vidéo complexe et ses performances ont dépassé les modèles commerciaux tels que Pika et Gen-2. Ce cadre définit de manière innovante des tâches de génération vidéo combinées, peut générer avec précision des vidéos selon des instructions complexes et prend en charge la génération de vidéos longues et les instructions multi-objets progressives, résolvant efficacement les lacunes des modèles existants dans le traitement d'instructions et de détails complexes, tels que la localisation précise de plusieurs. objets et en conservant leurs détails caractéristiques.

Nouvelles de ChinaZ.com du 17 juin : L'Université de Pékin et l'équipe Kuaishou AI ont collaboré pour surmonter avec succès le problème de la génération vidéo complexe. Ils ont proposé un nouveau framework appelé VideoTetris, qui peut facilement combiner divers détails comme un puzzle pour générer des vidéos très difficiles et avec des instructions complexes. Ce framework surpasse les modèles commerciaux tels que Pika et Gen-2 dans les tâches complexes de génération vidéo.

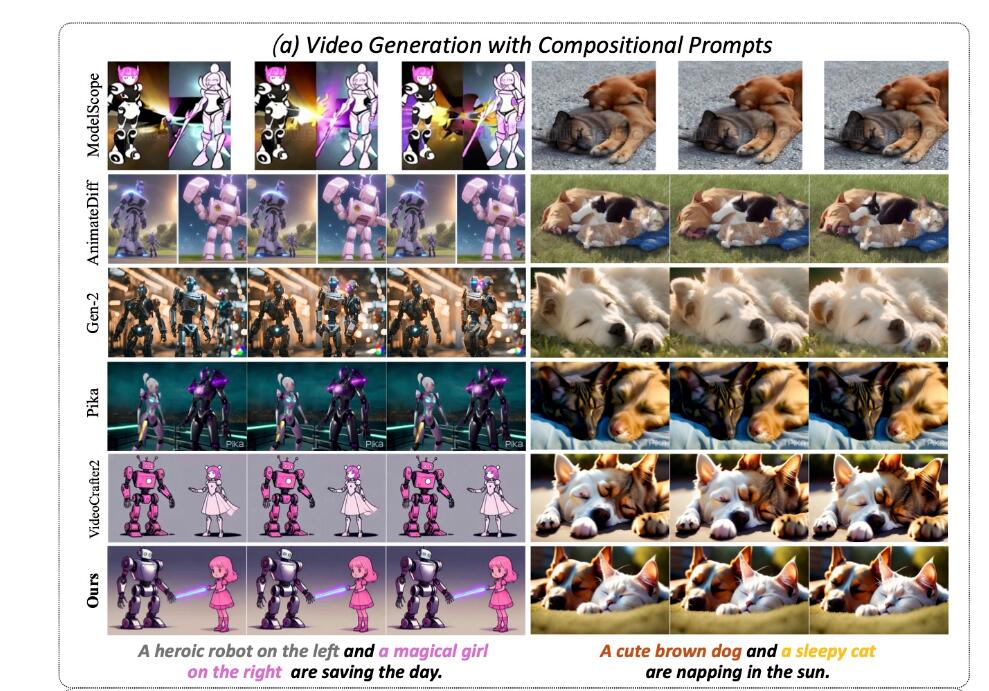

Le framework VideoTetris définit pour la première fois la tâche de génération vidéo combinée, comprenant deux sous-tâches : 1) génération vidéo suivant des instructions de combinaison complexes ; 2) génération vidéo longue suivant des instructions multi-objets combinées progressives. L’équipe a constaté que presque tous les modèles open source et commerciaux existants ne parvenaient pas à générer des vidéos correctes. Par exemple, si vous saisissez « un joli chien brun à gauche et un chat qui fait une sieste au soleil à droite », la vidéo résultante fusionne souvent des informations sur les deux objets, ce qui semble étrange.

En revanche, VideoTetris conserve avec succès toutes les informations de localisation et les fonctionnalités détaillées. Dans la génération de vidéos longues, il prend en charge des instructions plus complexes, telles que « Transition d'un joli écureuil brun sur un tas de noisettes à un joli écureuil brun et un joli écureuil blanc sur un tas de noisettes ». La séquence des vidéos générées est cohérente avec les instructions de saisie, et les deux écureuils peuvent naturellement échanger de la nourriture.

Le framework VideoTetris adopte la méthode de diffusion combinée spatio-temporelle. Il déconstruit d'abord les invites textuelles en fonction du temps et attribue différentes informations d'invite à différentes images vidéo. Ensuite, la dimension spatiale est déconstruite sur chaque image pour mapper différents objets sur différentes zones vidéo. Enfin, une génération efficace d’instructions combinées est obtenue grâce à une attention croisée spatio-temporelle.

Afin de générer de longues vidéos de meilleure qualité, l’équipe a également proposé une méthode améliorée de prétraitement des données d’entraînement pour rendre la génération de vidéos longues plus dynamique et stable. De plus, un mécanisme d'attention au cadre de référence est introduit et le VAE natif est utilisé pour coder les informations de la trame précédente, ce qui est différent des autres modèles utilisant le codage CLIP, obtenant ainsi une meilleure cohérence du contenu.

Le résultat de l'optimisation est que les longues vidéos n'ont plus de dominantes de couleurs sur une grande surface, peuvent mieux s'adapter aux instructions complexes et les vidéos générées sont plus dynamiques et plus naturelles. L’équipe a également introduit de nouveaux indicateurs d’évaluation VBLIP-VQA et VUnidet, étendant pour la première fois la méthode d’évaluation de génération combinée à la dimension vidéo.

Les tests expérimentaux montrent qu'en termes de capacités de génération vidéo combinées, le modèle VideoTetris surpasse tous les modèles open source, même les modèles commerciaux tels que Gen-2 et Pika. Il est rapporté que le code sera entièrement open source.

Adresse du projet : https://top.aibase.com/tool/videotetris

Dans l’ensemble, le cadre VideoTetris a réalisé des avancées significatives dans le domaine de la génération vidéo complexe, et sa méthode efficace de diffusion combinée spatio-temporelle et ses indicateurs d’évaluation innovants offrent une nouvelle direction pour le développement de la future technologie de génération vidéo. L'open source de ce projet fournit également des ressources précieuses à davantage de chercheurs et favorise le développement ultérieur dans ce domaine. Nous espérons que VideoTetris pourra jouer un rôle dans davantage de scénarios d'application à l'avenir.