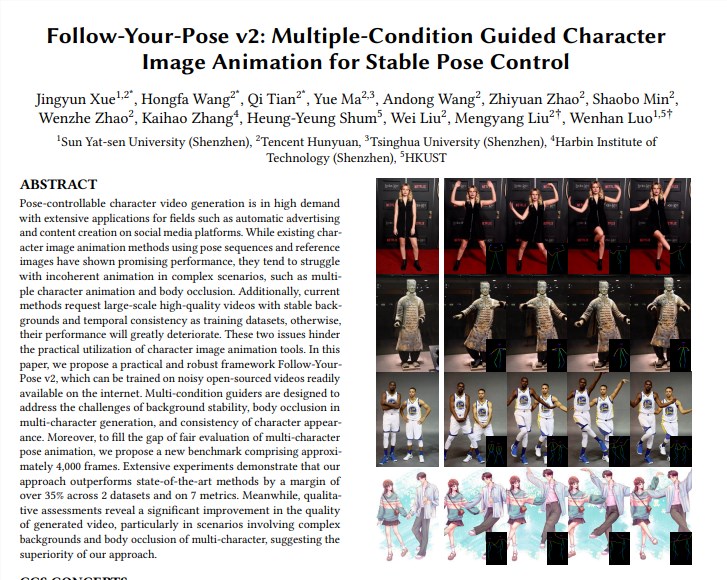

L'équipe de Tencent Hunyuan s'est associée à l'Université Sun Yat-sen et à l'Université des sciences et technologies de Hong Kong pour lancer un nouveau modèle vidéo Tusheng « Follow-Your-Pose-v2 », réalisant une percée dans la technologie de génération vidéo d'une personne à une personne multiple. Ce modèle peut gérer des photos de groupe de plusieurs personnes et faire bouger les personnes sur les photos en même temps dans la vidéo générée, améliorant considérablement l'efficacité et la qualité de la génération vidéo. Le point fort de sa technologie est qu'elle prend en charge la génération d'actions vidéo multi-personnes, possède de fortes capacités de généralisation, peut être formée et générée à l'aide de photos/vidéos de la vie quotidienne et peut gérer correctement des problèmes tels que l'occlusion de personnages. Le modèle surpasse les techniques existantes sur plusieurs ensembles de données, démontrant ainsi ses performances puissantes et ses vastes perspectives d'application.

Prise en charge de la génération d'actions vidéo à plusieurs personnes : réalisez la génération d'actions vidéo à plusieurs personnes avec un raisonnement moins long.

Forte capacité de généralisation : des vidéos de haute qualité peuvent être générées quels que soient l'âge, les vêtements, la race, l'encombrement de l'arrière-plan ou la complexité de l'action.

Photos/vidéos de la vie quotidienne disponibles : la formation et la génération de modèles peuvent utiliser des photos/vidéos de la vie quotidienne (y compris des instantanés) ou des vidéos, sans rechercher des images/vidéos de haute qualité.

Gérer correctement l'occlusion des personnages : face au problème des corps de plusieurs personnages se bloquant dans une seule image, il peut générer une image d'occlusion avec la relation correcte d'avant en arrière.

Mise en œuvre technique :

Le modèle utilise le « guide de flux optique » pour introduire des informations sur le flux optique d'arrière-plan, qui peuvent générer une animation d'arrière-plan stable même lorsque la caméra tremble ou que l'arrière-plan est instable.

Grâce au « Guide de carte d'inférence » et au « Guide de carte de profondeur », le modèle peut mieux comprendre les informations spatiales des personnages dans l'image et les relations de position spatiale de plusieurs personnages, et résoudre efficacement les problèmes d'animation multi-personnages et d'occlusion corporelle. .

Évaluer et comparer :

L'équipe a proposé un nouveau benchmark Multi-Character, qui contient environ 4 000 images de vidéos multi-caractères pour évaluer l'effet de la génération multi-caractères.

Les résultats expérimentaux montrent que « Follow-Your-Pose-v2 » surpasse l'état de l'art de plus de 35 % sur deux ensembles de données publiques (discours TikTok et TED) et 7 indicateurs.

Perspectives d'application :

La technologie de génération d'image en vidéo a de larges perspectives d'application dans de nombreux secteurs tels que la production de contenu cinématographique, la réalité augmentée, la production de jeux et la publicité. C'est l'une des technologies d'IA qui attirera beaucoup d'attention en 2024.

Informations Complémentaires:

L'équipe Hunyuan de Tencent a également annoncé une bibliothèque d'accélération pour le grand modèle open source de graphiques vincentiens (Hunyuan DiT), qui améliore considérablement l'efficacité du raisonnement et réduit le temps de génération des graphiques de 75 %.

Le seuil d'utilisation du modèle Hunyuan DiT a été abaissé. Les utilisateurs peuvent appeler le modèle dans la bibliothèque de modèles officielle de Hugging Face avec trois lignes de code.

Adresse papier : https://arxiv.org/pdf/2406.03035

Page du projet : https://top.aibase.com/tool/follow-your-pose

L'émergence du modèle « Follow-Your-Pose-v2 » marque une avancée majeure dans la technologie vidéo de Tusheng, et ses perspectives d'application dans de nombreux domaines méritent d'être attendues. À l'avenir, avec le développement et l'amélioration continus de la technologie, on pense que ce modèle jouera un rôle important dans davantage de scénarios et offrira aux gens une expérience de génération vidéo plus pratique et plus intelligente.