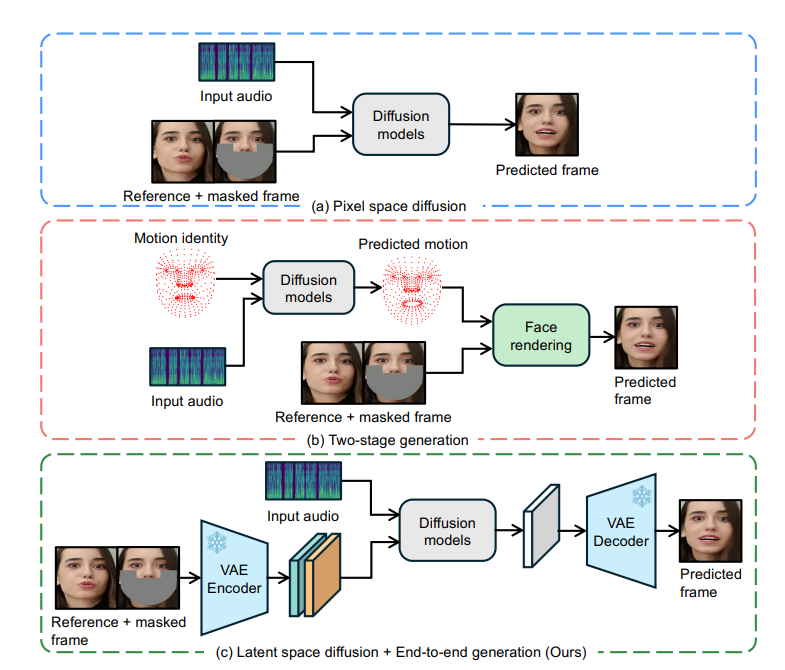

ByteDance a open source une technologie innovante de synchronisation labiale appelée LatentSync, qui est basée sur le modèle de diffusion latente des conditions audio et permet une synchronisation précise des mouvements des lèvres du personnage dans la vidéo avec l'audio. Il utilise directement la puissance de la diffusion stable sans avoir recours à une représentation de mouvement intermédiaire, modélise efficacement des associations audiovisuelles complexes et améliore la cohérence temporelle grâce à la technologie TREPA (Temporal Representation Alignment). LatentSync optimise également le problème de convergence de SyncNet et améliore considérablement la précision de la synchronisation labiale. Cette technologie présente des avantages significatifs en termes de cadre de bout en bout, de génération de haute qualité, de cohérence temporelle et d'optimisation SyncNet, offrant ainsi une nouvelle solution pour l'animation de portraits audio.

Il a été constaté que les méthodes de synchronisation labiale basées sur la diffusion fonctionnent mal en termes de cohérence temporelle en raison d'incohérences dans le processus de diffusion entre les différentes images. Pour résoudre ce problème, LatentSync introduit la technologie TREPA (Time Representation Alignment). TREPA exploite les représentations temporelles extraites de grands modèles vidéo auto-supervisés pour aligner les images générées avec les images réelles, améliorant ainsi la cohérence temporelle tout en maintenant la précision de la synchronisation labiale.

En outre, l'équipe de recherche a également mené une étude approfondie du problème de convergence de SyncNet et, grâce à un grand nombre d'études empiriques, a identifié les facteurs clés affectant la convergence de SyncNet, notamment l'architecture du modèle, les hyperparamètres de formation et les méthodes de prétraitement des données. En optimisant ces facteurs, la précision de SyncNet sur l'ensemble de test HDTF est considérablement améliorée, passant de 91 % à 94 %. Étant donné que le cadre de formation global de SyncNet n'est pas modifié, cette expérience peut également être appliquée à d'autres méthodes de synchronisation labiale et d'animation de portraits audio utilisant SyncNet.

Avantages de la synchronisation latente

Cadre de bout en bout : générez des mouvements de lèvres synchronisés directement à partir de l'audio sans représentation de mouvement intermédiaire.

Génération de haute qualité : utilisez les puissantes capacités de Stable Diffusion pour générer des vidéos parlantes dynamiques et réalistes.

Cohérence temporelle : améliorez la cohérence temporelle entre les images vidéo grâce à la technologie TREPA.

Optimisation SyncNet : résolvez le problème de convergence de SyncNet et améliorez considérablement la précision de la synchronisation labiale.

Principe de fonctionnement

Le cœur de LatentSync est basé sur la technologie de réparation image à image, qui nécessite la saisie d'une image masquée comme référence. Afin d'intégrer les caractéristiques visuelles du visage de la vidéo originale, le modèle saisit également des images de référence. Après l'épissage des canaux, ces informations d'entrée sont entrées dans le réseau U-Net pour traitement.

Le modèle utilise l'extracteur de fonctionnalités audio pré-entraîné Whisper pour extraire les intégrations audio. Les mouvements des lèvres peuvent être affectés par l'audio des images environnantes, de sorte que le modèle regroupe l'audio de plusieurs images environnantes en entrée pour fournir davantage d'informations temporelles. Les intégrations audio sont intégrées dans U-Net via des couches d'attention croisée.

Pour résoudre le problème selon lequel SyncNet nécessite une entrée d'espace image, le modèle prédit d'abord dans l'espace bruyant, puis obtient l'espace latent propre estimé via une méthode en une seule étape. L'étude a révélé que l'entraînement de SyncNet dans l'espace des pixels est meilleur que l'entraînement dans l'espace latent, ce qui peut être dû au fait que les informations de la région des lèvres sont perdues lors du codage VAE.

Le processus de formation est divisé en deux étapes : dans la première étape, U-Net apprend les caractéristiques visuelles sans décodage de l'espace des pixels et ajoute la perte SyncNet. La deuxième étape ajoute la perte SyncNet en utilisant la méthode de supervision de l'espace de pixels décodé et utilise la perte LPIPS pour améliorer la qualité visuelle de l'image. Afin de garantir que le modèle apprend correctement les informations temporelles, le bruit d'entrée doit également être temporellement cohérent et le modèle utilise un modèle de bruit mixte. De plus, lors de la phase de prétraitement des données, la transformation affine est également utilisée pour réaliser une frontalisation des visages.

Technologie TREPA

TREPA améliore la cohérence temporelle en alignant les représentations temporelles des séquences d'images générées et réelles. Cette méthode utilise le modèle vidéo auto-supervisé à grande échelle VideoMAE-v2 pour extraire des représentations temporelles. Contrairement aux méthodes qui utilisent uniquement la perte de distance entre les images, la représentation temporelle peut capturer les corrélations temporelles dans les séquences d'images, améliorant ainsi la cohérence temporelle globale. Des études ont montré que TREPA non seulement ne nuit pas à la précision de la synchronisation labiale, mais peut en fait l'améliorer.

Problèmes de convergence SyncNet

La recherche a montré que la perte de formation de SyncNet a tendance à rester proche de 0,69 et ne peut pas être réduite davantage. Grâce à une analyse expérimentale approfondie, l'équipe de recherche a découvert que la taille du lot, le numéro de trame d'entrée et la méthode de prétraitement des données ont un impact significatif sur la convergence de SyncNet. L'architecture du modèle affecte également la convergence, mais dans une moindre mesure.

Les résultats expérimentaux montrent que LatentSync surpasse les autres méthodes de synchronisation labiale de pointe sur plusieurs mesures. Surtout en termes de précision de synchronisation labiale, grâce à son SyncNet optimisé et sa couche d'attention croisée audio, qui peuvent mieux capturer la relation entre l'audio et les mouvements des lèvres. De plus, la cohérence temporelle de LatentSync a été considérablement améliorée grâce à la technologie TREPA.

Adresse du projet : https://github.com/bytedance/LatentSync

L'open source de LatentSync a apporté de nouvelles avancées dans le développement de la technologie de synchronisation labiale. Ses performances efficaces et précises et ses méthodes d'entraînement optimisées méritent d'être recherchées et appliquées. À l’avenir, cette technologie devrait jouer un rôle plus important dans la production vidéo, la réalité virtuelle et d’autres domaines.