L'effet d'application pratique des modèles de langage génératifs est souvent limité par la stratégie de décodage au stade de l'inférence. Les méthodes existantes telles que RLHF se concentrent principalement sur le taux de réussite du modèle et ignorent l'impact des stratégies de décodage sur les performances du modèle, ce qui entraîne une faible efficacité et une difficulté à garantir la qualité des résultats. Afin de résoudre ce problème, Google DeepMind et l'équipe de recherche de Google ont proposé le framework InfAlign, qui vise à combiner la stratégie d'inférence avec le processus d'alignement du modèle pour améliorer les performances d'inférence et la fiabilité du modèle.

Les modèles de langage génératifs sont confrontés à de nombreux défis dans le processus, de la formation aux applications pratiques. L’un des principaux problèmes est de savoir comment obtenir des performances optimales du modèle pendant la phase d’inférence.

Les contre-mesures actuelles, telles que l'apprentissage par renforcement par rétroaction humaine (RLHF), se concentrent principalement sur l'amélioration du taux de réussite du modèle, mais ignorent souvent les stratégies de décodage lors de l'inférence, telles que l'échantillonnage Best-of-N et le décodage contrôlé. Cet écart entre les objectifs de formation et l’utilisation réelle peut entraîner des inefficacités et affecter la qualité et la fiabilité des résultats.

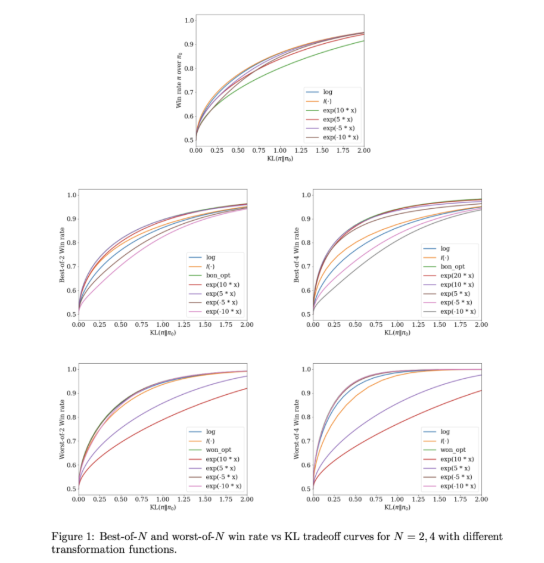

Pour résoudre ces problèmes, Google DeepMind et l'équipe de recherche Google ont développé InfAlign, un cadre d'apprentissage automatique conçu pour être combiné avec des stratégies d'inférence. InfAlign intègre des méthodes de temps d'inférence dans le processus d'alignement et s'efforce de combler le fossé entre la formation et l'application. Il adopte une méthode d'apprentissage par renforcement calibrée pour ajuster la fonction de récompense en fonction d'une stratégie d'inférence spécifique. InfAlign est particulièrement efficace avec des techniques telles que l'échantillonnage Best-of-N (générant plusieurs réponses et sélection de la meilleure) et Worst-of-N (couramment utilisé dans les évaluations de sécurité), garantissant que le modèle aligné fonctionne à la fois dans des environnements contrôlés et en conditions réelles. -les scénarios du monde sont bons.

Le cœur d'InfAlign est l'algorithme CTRL (Calibration and Transformation Reinforcement Learning), qui suit trois étapes : calibrer les scores de récompense, transformer ces scores selon la stratégie d'inférence et résoudre un problème d'optimisation régularisé KL. InfAlign aligne les objectifs de formation avec les exigences d'inférence en adaptant les transformations de récompense à des scénarios spécifiques. Cette méthode améliore non seulement le taux de victoire lors de l'inférence, mais maintient également l'efficacité des calculs. De plus, InfAlign améliore la robustesse du modèle, lui permettant de gérer efficacement diverses stratégies de décodage et de produire une sortie cohérente de haute qualité.

L'efficacité d'InfAlign est vérifiée dans des expériences utilisant les ensembles de données d'utilité et d'innocuité d'Anthropic. Par rapport aux méthodes existantes, InfAlign améliore le taux de réussite de l'inférence de 8 à 12 % dans l'échantillonnage du meilleur des N et de 4 à 9 % dans l'évaluation de sécurité du pire des N. Ces améliorations sont dues à sa transformation calibrée de récompense, qui résout efficacement le problème de mauvais calibrage du modèle de récompense et garantit des performances cohérentes dans différents scénarios d'inférence.

InfAlign représente une avancée importante dans l'alignement des modèles de langage génératifs. En intégrant des stratégies basées sur l'inférence, InfAlign aborde la différence critique entre la formation et le déploiement. Sa base théorique solide et ses résultats empiriques mettent en évidence son potentiel pour améliorer de manière globale l’alignement du système d’IA.

Lien : https://arxiv.org/abs/2412.19792

Points forts:

InfAlign est un nouveau framework développé par Google DeepMind, visant à améliorer les performances des modèles de langage lors de la phase d'inférence.

Ce cadre ajuste la fonction de récompense de la stratégie d'inférence grâce à des méthodes d'apprentissage par renforcement calibrées pour parvenir à un alignement entre les objectifs de formation et les exigences d'inférence.

Les résultats expérimentaux montrent qu'InfAlign améliore considérablement le taux de réussite des inférences du modèle dans plusieurs tâches, démontrant ainsi une bonne adaptabilité et fiabilité.

L'émergence du framework InfAlign fournit de nouvelles idées pour résoudre les problèmes d'efficacité et de qualité des modèles de langage génératifs dans la phase d'inférence. Sa contribution à l'amélioration de la robustesse et de la fiabilité des modèles mérite l'attention. Les recherches futures pourront explorer davantage l’application d’InfAlign sur différents modèles et tâches afin de promouvoir le développement continu de la technologie d’IA générative.