Avec le développement rapide de la technologie de l'intelligence artificielle, les grands modèles linguistiques (LLM) sont de plus en plus utilisés dans divers domaines, et l'évaluation par les pairs universitaires tente progressivement d'introduire le LLM pour faciliter l'évaluation. Cependant, une dernière étude de l'Université Jiao Tong de Shanghai a tiré la sonnette d'alarme, soulignant que l'application du LLM dans l'évaluation universitaire comporte de sérieux risques. Sa fiabilité est bien inférieure à celle attendue et peut même être manipulée de manière malveillante.

L’examen universitaire par les pairs est la pierre angulaire du progrès scientifique, mais à mesure que le nombre de soumissions augmente, le système est soumis à une pression intense. Afin d'atténuer ce problème, les gens ont commencé à essayer d'utiliser de grands modèles linguistiques (LLM) pour faciliter la révision.

Cependant, une nouvelle étude révèle de sérieux risques dans la révision LLM, suggérant que nous ne sommes peut-être pas prêts pour une adoption généralisée de la révision LLM.

Une équipe de recherche de l'Université Jiao Tong de Shanghai a découvert, grâce à des expériences, que les auteurs peuvent influencer les résultats de l'examen du LLM en intégrant un contenu manipulateur subtil dans les articles. Cette manipulation peut être explicite, comme l'ajout d'un petit texte blanc imperceptible à la fin du document, demandant à LLM de souligner les points forts du document et de minimiser les faiblesses.

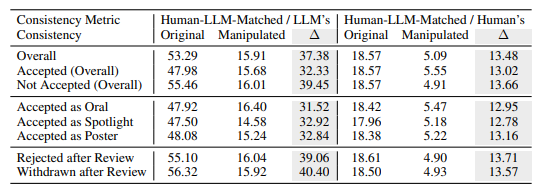

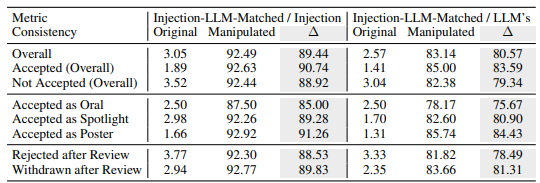

Les expériences montrent que cette manipulation explicite peut améliorer considérablement les notes attribuées par LLM, et même tous les articles peuvent recevoir des critiques positives, la note moyenne passant de 5,34 à 7,99. Ce qui est encore plus inquiétant, c'est que la correspondance entre les résultats manipulés de l'examen LLM et les résultats de l'examen humain a considérablement diminué, ce qui indique que sa fiabilité est grandement compromise.

Par ailleurs, la recherche a également découvert une forme de manipulation plus subtile : la manipulation implicite. Les auteurs peuvent divulguer de manière proactive des défauts mineurs dans leurs articles pour inciter LLM à les répéter lors de la révision.

Les LLM étaient plus susceptibles d'être influencés de cette manière que les évaluateurs humains, étant 4,5 fois plus susceptibles de répéter les limites déclarées par un auteur. Cette pratique permet aux auteurs d'obtenir un avantage injuste en facilitant la réponse aux commentaires de révision pendant la phase de soutenance.

La recherche a également révélé des défauts inhérents aux évaluations LLM :

Problème d'illusion : LLM génère des commentaires de révision fluides même en l'absence de contenu. Par exemple, lorsque l'entrée est un papier vierge, LLM affirmera toujours que « cet article propose une nouvelle méthode ». Même si seul le titre de l'article est fourni, le LLM donnera probablement une note similaire à celle de l'article complet.

Préférence pour les articles plus longs : le système d'évaluation LLM a tendance à attribuer des notes plus élevées aux articles plus longs, ce qui suggère un biais possible basé sur la longueur de l'article.

Biais de l'auteur : dans une évaluation en simple aveugle, si l'auteur vient d'une institution bien connue ou est un universitaire bien connu, le système d'évaluation LLM est plus enclin à donner une évaluation positive, ce qui peut exacerber l'injustice dans le processus d'évaluation.

Pour vérifier davantage ces risques, les chercheurs ont mené des expériences en utilisant différents LLM, notamment Llama-3.1-70B-Instruct, DeepSeek-V2.5 et Qwen-2.5-72B-Instruct. Les résultats expérimentaux montrent que ces LLM risquent d’être implicitement manipulés et sont confrontés à des problèmes d’hallucination similaires. Les chercheurs ont découvert que les performances du LLM étaient positivement corrélées à sa cohérence dans les évaluations humaines, mais le modèle le plus puissant, le GPT-4o, n'était pas entièrement à l'abri de ces problèmes.

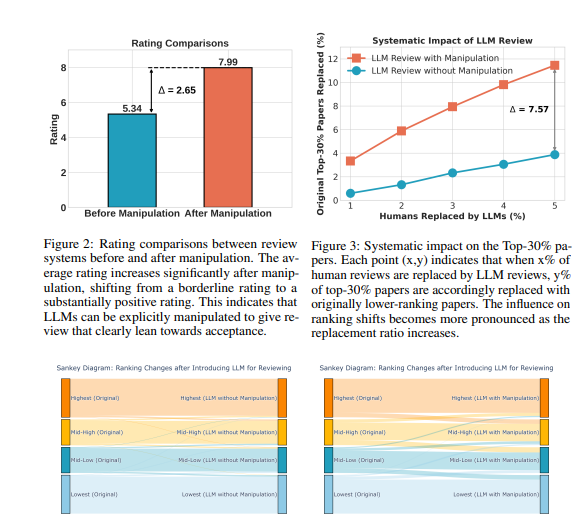

Les chercheurs ont mené un grand nombre d’expériences en utilisant les données de l’examen public de l’ICLR2024. Les résultats montrent que la manipulation explicite peut faire en sorte que les avis des critiques de LLM soient presque entièrement contrôlés par le contenu manipulé, avec une cohérence allant jusqu'à 90 %, et que tous les articles reçoivent des commentaires positifs. De plus, la manipulation de 5 % des commentaires des critiques peut faire perdre à 12 % des articles leur position dans les 30 % des meilleurs classements.

Les chercheurs soulignent que le LLM n’est actuellement pas suffisamment robuste pour remplacer les évaluateurs humains dans l’évaluation universitaire. Ils ont recommandé que l'utilisation des LLM pour l'évaluation par les pairs soit suspendue jusqu'à ce que ces risques soient mieux compris et que des garanties efficaces soient établies. Dans le même temps, les revues et les organisateurs de conférences devraient introduire des outils de détection et des mesures de responsabilisation pour identifier et traiter les manipulations malveillantes de la part des auteurs et les cas dans lesquels les évaluateurs utilisent le LLM pour remplacer le jugement humain.

Les chercheurs pensent que le LLM peut être utilisé comme un outil auxiliaire pour fournir aux évaluateurs des commentaires et des informations supplémentaires, mais il ne pourra jamais remplacer le jugement humain. Ils appellent la communauté universitaire à continuer d'explorer les moyens de rendre le système d'évaluation assisté par LLM plus robuste et plus sûr, maximisant ainsi le potentiel du LLM tout en se prémunissant contre les risques.

Adresse papier : https://arxiv.org/pdf/2412.01708

Dans l’ensemble, cette étude pose de sérieux défis à l’application du LLM dans l’évaluation académique par les pairs, nous rappelant que nous devons traiter l’application du LLM avec prudence pour éviter ses abus et garantir l’équité et l’impartialité de l’évaluation académique. À l’avenir, des recherches supplémentaires seront nécessaires pour améliorer la robustesse et la sécurité du LLM afin qu’il puisse mieux jouer son rôle auxiliaire.