MiniMax a publié une nouvelle série de modèles open source MiniMax-01 le 15 janvier 2025, comprenant le grand modèle textuel MiniMax-Text-01 et le grand modèle visuel multimodal MiniMax-VL-01. Cette série de paramètres de modèle atteint 456 milliards, avec une seule activation de 45,9 milliards. Elle innove audacieusement en matière d'architecture et applique pour la première fois le mécanisme d'attention linéaire à grande échelle, dépassant les limites du Transformer traditionnel et capable de le faire. de traiter efficacement des contextes allant jusqu'à 4 millions de jetons, nettement en avance sur les modèles existants. La série MiniMax-01 est comparable aux meilleurs modèles étrangers en termes de performances et présente des avantages significatifs dans le traitement de textes longs. Ses capacités de traitement efficaces et son prix bas la rendent extrêmement compétitive dans les applications commerciales.

MiniMax a annoncé l'open source de sa nouvelle série de modèles MiniMax-01 le 15 janvier 2025. La série comprend le grand modèle de langage de base MiniMax-Text-01 et le grand modèle visuel multimodal MiniMax-VL-01. La série MiniMax-01 a apporté des innovations architecturales audacieuses, implémentant pour la première fois un mécanisme d'attention linéaire à grande échelle, brisant ainsi les limites de l'architecture Transformer traditionnelle. Son volume de paramètres atteint 456 milliards et une seule activation s'élève à 45,9 milliards. Ses performances globales sont comparables à celles des meilleurs modèles étrangers et il peut gérer efficacement des contextes allant jusqu'à 4 millions de jetons. Cette longueur est 32 fois supérieure à celle du GPT-4o. et Claude-3,5-Sonnet 20 fois.

MiniMax estime que 2025 sera une année critique pour le développement rapide des agents. Qu'il s'agisse d'un système mono-agent ou d'un système multi-agent, un contexte plus long est nécessaire pour prendre en charge une mémoire continue et de grandes quantités de communication. Le lancement de la série de modèles MiniMax-01 vise précisément à répondre à cette demande et à franchir la première étape dans l'établissement des capacités de base des agents complexes.

Grâce à l'innovation architecturale, à l'optimisation de l'efficacité, à la formation intégrée en cluster et à la conception push, MiniMax peut fournir des services API de compréhension de texte et multimodaux à la fourchette de prix la plus basse du secteur. Le prix standard est de 1 yuan/million de jetons d'entrée et de 8 jetons de sortie. yuans/cent. La plate-forme ouverte MiniMax et la version étrangère ont été lancées pour que les développeurs puissent en faire l'expérience.

Les modèles de la série MiniMax-01 sont open source sur GitHub et seront continuellement mis à jour. Dans les évaluations de textes grand public et de compréhension multimodale de l'industrie, la série MiniMax-01 a égalé les modèles avancés internationalement reconnus GPT-4o-1120 et Claude-3.5-Sonnet-1022 dans la plupart des tâches. En particulier pour les tâches de texte longues, par rapport au modèle Gemini de Google, MiniMax-Text-01 présente la dégradation des performances la plus lente à mesure que la longueur d'entrée augmente, ce qui est nettement meilleur que Gemini.

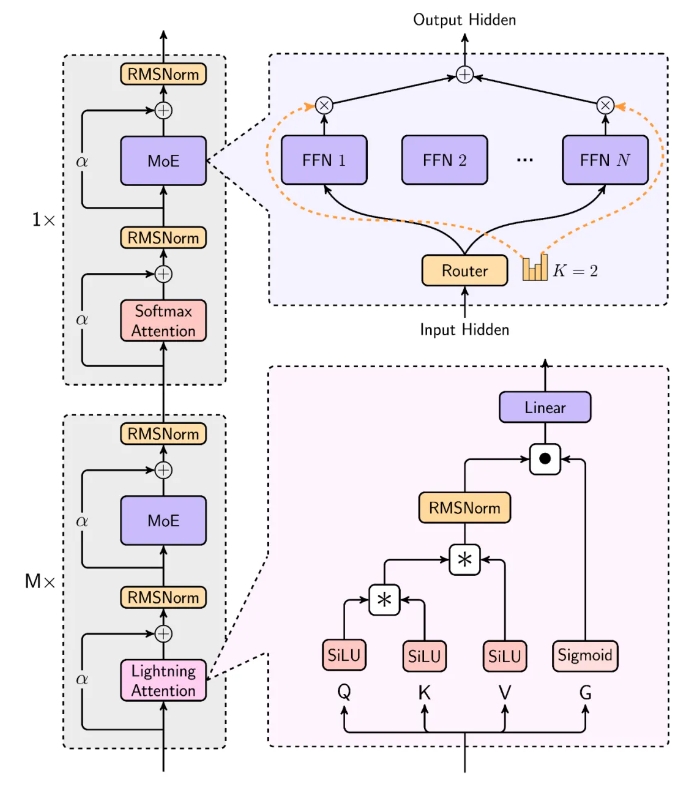

Le modèle de MiniMax est extrêmement efficace lors du traitement d'entrées longues, approchant la complexité linéaire. Dans sa conception structurelle, 7 couches sur 8 utilisent une attention linéaire basée sur Lightning Attention, et 1 couche utilise l'attention SoftMax traditionnelle. C'est la première fois dans l'industrie que le mécanisme d'attention linéaire est étendu au niveau du modèle commercial. MiniMax a pris en compte de manière approfondie la loi de mise à l'échelle, la combinaison avec MoE, la conception structurelle, l'optimisation de la formation et l'optimisation de l'inférence, et a reconstruit le système de formation et d'inférence. y compris une optimisation plus efficace de la communication MoE tout-à-tout, une optimisation de séquences plus longues et une mise en œuvre efficace du noyau de l'attention linéaire au niveau de l'inférence.

Dans la plupart des tests académiques, la série MiniMax-01 a obtenu des résultats comparables à ceux du premier niveau à l'étranger. Il est nettement en avance dans l'ensemble d'évaluation de contexte à long terme, comme par exemple ses excellentes performances sur la tâche de récupération de 4 millions d'aiguilles dans une botte de foin. En plus des ensembles de données académiques, MiniMax a également créé un ensemble de tests de scénarios assistants basés sur des données réelles, et MiniMax-Text-01 a réalisé des performances exceptionnelles dans ce scénario. Dans l'ensemble de tests de compréhension multimodale, MiniMax-VL-01 est également en avance.

Adresse open source : https://github.com/MiniMax-AI

L'open source des modèles de la série MiniMax-01 a insufflé une nouvelle vitalité au développement du domaine de l'IA. Ses avancées dans le traitement de textes longs et la compréhension multimodale favoriseront le développement rapide de la technologie Agent et des applications associées. Nous attendons avec impatience d’autres innovations et percées de MiniMax à l’avenir.