Alibaba Damo Academy a publié Valley2, un modèle de langage multimodal à grande échelle basé sur des scénarios de commerce électronique. Ce modèle combine Qwen2.5, l'encodeur visuel SigLIP-384 et des modules Eagle innovants et des adaptateurs de convolution pour améliorer les performances du commerce électronique et des applications. dans le domaine de la vidéo courte. L'ensemble de données de Valley2 couvre les données de style OneVision, les données de commerce électronique et de champs vidéo courts, ainsi que les données de réflexion en chaîne, et après une formation en plusieurs étapes, il a obtenu d'excellents résultats dans plusieurs tests de référence publics, en particulier dans les évaluations liées au commerce électronique. L'optimisation de sa conception architecturale et de sa stratégie de formation fournit de nouvelles idées pour améliorer les performances des grands modèles multimodaux.

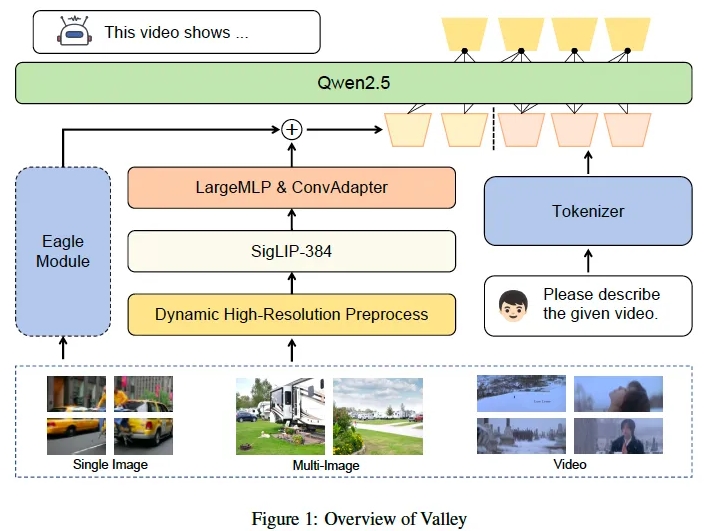

Alibaba Damo Academy a récemment lancé un modèle de langage multimodal à grande échelle appelé Valley2. Ce modèle est conçu sur la base de scénarios de commerce électronique et vise à améliorer les performances dans divers domaines et à développer le commerce électronique et l'utilisation à court terme grâce à un visuel évolutif. architecture du langage. Limites d’application des scènes vidéo. Valley2 utilise Qwen2.5 comme épine dorsale LLM, associé à l'encodeur visuel SigLIP-384, et combine des couches MLP et des convolutions pour une conversion efficace des fonctionnalités. Son innovation réside dans l'introduction d'un large vocabulaire visuel, d'un adaptateur de convolution (ConvAdapter) et d'un module Eagle, qui améliorent la flexibilité de traitement de diverses entrées du monde réel et l'efficacité de l'inférence de formation.

Les données de Valley2 se composent de données de style OneVision, de données pour le commerce électronique et les champs vidéo courts, ainsi que de données Chain of Thinking (CoT) pour la résolution de problèmes complexes. Le processus de formation est divisé en quatre étapes : alignement texte-visuel, apprentissage de connaissances de haute qualité, mise au point de l'instruction et réflexion en chaîne après la formation. Lors des expériences, Valley2 a obtenu de bons résultats dans plusieurs tests de référence publics, en obtenant notamment des résultats élevés sur MMBench, MMStar, MathVista et d'autres tests de référence, et a également surpassé d'autres modèles de même taille dans le test de référence Ecom-VQA.

À l'avenir, l'Alibaba DAMO Academy prévoit de publier un modèle complet comprenant des modalités de texte, d'image, vidéo et audio, et d'introduire une méthode de formation à l'intégration multimodale basée sur Valley pour prendre en charge les applications de récupération et de détection en aval.

Le lancement de Valley2 marque une avancée importante dans le domaine des modèles de langage multimodaux à grande échelle, démontrant la possibilité d'améliorer les performances du modèle grâce à l'amélioration structurelle, à la construction d'ensembles de données et à l'optimisation de la stratégie de formation.

Lien du modèle :

https://www.modelscope.cn/models/bytedance-research/Valley-Eagle-7B

Lien des codes :

https://github.com/bytedance/Valley

Lien papier :

https://arxiv.org/abs/2501.05901

La sortie de Valley2 démontre non seulement la technologie avancée de l'Alibaba Damo Academy dans le domaine des grands modèles multimodaux, mais indique également que les domaines du commerce électronique et de la vidéo courte ouvriront la voie à des applications plus innovantes basées sur l'IA à l'avenir. Nous espérons que Valley2 sera en mesure d'améliorer et d'étendre davantage ses scénarios d'application à l'avenir, offrant ainsi des services plus pratiques et plus intelligents aux utilisateurs.