Avec la croissance explosive du volume de données vidéo, la manière d'utiliser efficacement les informations vidéo pour la récupération de connaissances et la réponse aux questions est devenue un point chaud de la recherche. Les systèmes traditionnels de génération augmentée de récupération (RAG) reposent principalement sur des informations textuelles et sont difficiles à exploiter pleinement la richesse des informations multimodales contenues dans les vidéos. Cet article présente un nouveau framework appelé VideoRAG, capable de récupérer dynamiquement des vidéos pertinentes pour une requête et d'intégrer efficacement des informations visuelles et textuelles pour générer des réponses plus précises et informatives. Le cadre utilise de grands modèles de langage vidéo (LVLM) pour réaliser une intégration transparente de données multimodales et traite des vidéos sans sous-titres grâce à une technologie de reconnaissance vocale automatique, améliorant considérablement l'efficacité de la récupération et de la génération.

Avec le développement rapide de la technologie vidéo, la vidéo est devenue un outil important pour la recherche d’informations et la compréhension de concepts complexes. La vidéo combine des données visuelles, temporelles et contextuelles pour fournir une représentation multimodale au-delà des images et du texte statiques. Aujourd'hui, avec la prolifération des plateformes de partage de vidéos et la prolifération de vidéos éducatives et informatives, l'exploitation de la vidéo comme source de connaissances offre des opportunités sans précédent pour résoudre des requêtes qui nécessitent un contexte détaillé, une compréhension spatiale et une démonstration de processus.

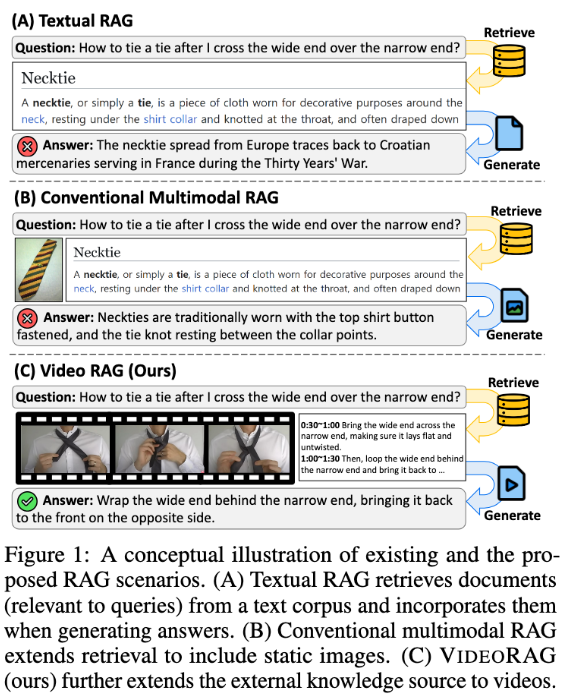

Cependant, les systèmes de génération augmentée de récupération (RAG) existants négligent souvent tout le potentiel des données vidéo. Ces systèmes s'appuient souvent sur des informations textuelles et utilisent occasionnellement des images statiques pour prendre en charge les réponses aux requêtes, mais ne parviennent pas à capturer la dynamique visuelle et les signaux multimodaux contenus dans la vidéo, qui sont essentiels pour les tâches complexes. Les approches traditionnelles prédéfinissent des vidéos liées aux requêtes sans récupération ou convertissent les vidéos au format texte, perdant ainsi un contexte visuel et une dynamique temporelle importants, limitant la capacité à fournir des réponses précises et informatives.

Afin de résoudre ces problèmes, l'équipe de recherche de l'Institut supérieur coréen des sciences et technologies (KaIST) et DeepAuto.ai ont proposé un nouveau framework : VideoRAG. Le framework est capable de récupérer dynamiquement des vidéos pertinentes pour une requête et d'intégrer des informations visuelles et textuelles dans le processus de génération. VideoRAG exploite des modèles de langage vidéo à grande échelle (LVLM) avancés pour réaliser une intégration transparente des données multimodales, garantissant que les vidéos récupérées sont contextuellement cohérentes avec les requêtes des utilisateurs et conservant la richesse temporelle du contenu vidéo.

Le flux de travail de VideoRAG est divisé en deux étapes principales : la récupération et la génération. Pendant la phase de récupération, le framework identifie les vidéos similaires à ses caractéristiques visuelles et textuelles via la requête.

Au cours de la phase de génération, la technologie de reconnaissance vocale automatique est utilisée pour générer des données textuelles auxiliaires pour les vidéos sans sous-titres, garantissant ainsi que la génération de réponses pour toutes les vidéos peut apporter efficacement des informations. Les vidéos récupérées pertinentes sont ensuite saisies dans le module de génération, qui intègre des données multimodales telles que des images vidéo, des sous-titres et du texte de requête, et les traite à l'aide de LVLM pour générer des réponses longues, riches, précises et contextuellement appropriées.

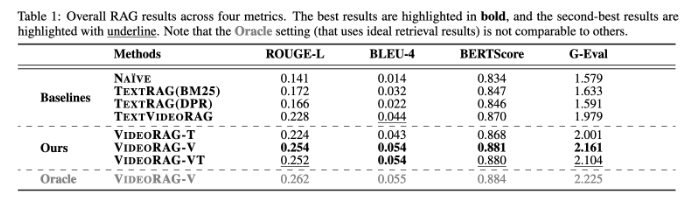

VideoRAG mène des expériences approfondies sur des ensembles de données tels que WikiHowQA et HowTo100M, et les résultats montrent que la qualité de sa réponse est nettement meilleure que les méthodes traditionnelles. Ce nouveau cadre améliore non seulement les capacités des systèmes de génération d'améliorations de récupération, mais établit également de nouvelles normes pour les futurs systèmes de récupération multimodaux.

Article : https://arxiv.org/abs/2501.05874

Souligner:

**Nouveau framework** : VideoRAG récupère dynamiquement les vidéos pertinentes et fusionne les informations visuelles et textuelles pour améliorer l'effet de génération.

**Vérification expérimentale** : testé sur plusieurs ensembles de données, montrant une qualité de réponse nettement meilleure que la méthode RAG traditionnelle.

**Innovation technique** : grâce à des modèles de langage vidéo à grande échelle, VideoRAG ouvre un nouveau chapitre dans l'intégration de données multimodales.

Dans l'ensemble, le framework VideoRAG fournit une nouvelle solution pour les tâches d'amélioration de la récupération vidéo. Ses avancées en matière d'intégration de données multimodales et de récupération d'informations fournissent des informations importantes pour les futurs systèmes de récupération d'informations plus intelligents et plus précis. Les résultats de la recherche devraient être largement utilisés dans les domaines de l’éducation, de la médecine et dans d’autres domaines.