Améliorer l’efficacité du raisonnement sur grands modèles constitue un enjeu majeur dans le domaine de l’intelligence artificielle. Une charge d'inférence élevée, un coût élevé et un temps de réponse long limitent considérablement l'application de grands modèles. Afin de résoudre ces problèmes, la société Kimi a coopéré avec le laboratoire MADSys de l'Université Tsinghua pour développer conjointement le système d'inférence Mooncake basé sur KVCache et qui sera officiellement lancé en juin 2024. Le système adopte une architecture innovante de séparation PD et un concept centré sur la conversion du stockage pour améliorer considérablement le débit de raisonnement. Afin de promouvoir l'application et la vulgarisation de la technologie, le projet Mooncake est officiellement open source.

La société Kimi, en collaboration avec le laboratoire MADSys de l'Université Tsinghua, a lancé le plan de conception du système d'inférence Mooncake basé sur KVCache, qui sera officiellement publié en juin 2024.

Le système d'inférence Mooncake a considérablement amélioré le débit d'inférence grâce à son architecture innovante de séparation des PD et à son concept centré sur la conversion du stockage, attirant ainsi l'attention d'un large éventail d'industries. Afin de promouvoir davantage l'application et la vulgarisation de ce cadre technique, le laboratoire MADSys de Kimi et de l'université Tsinghua s'est associé à un certain nombre d'entreprises, telles que 9#AISoft, Alibaba Cloud, Huawei Storage, etc., pour lancer le projet open source Mooncake. . Le 28 novembre, le framework technique de Mooncake a été officiellement lancé sur la plateforme GitHub.

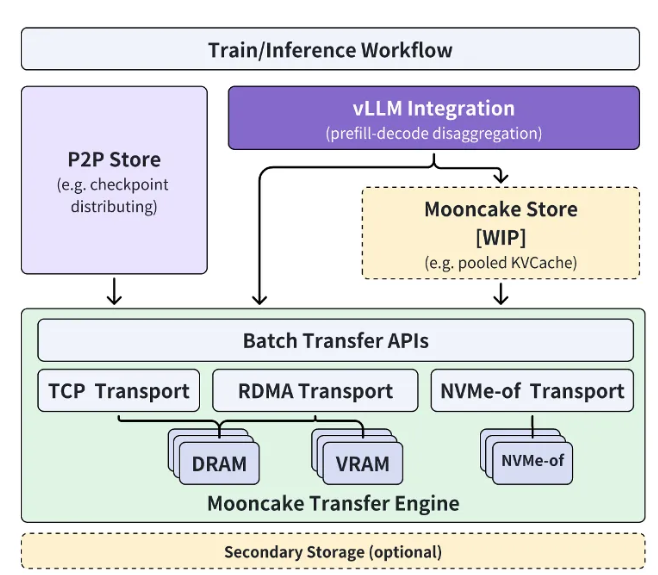

Le projet open source Mooncake s'articule autour du pool de cache KVCache à très grande échelle et s'engage à ouvrir progressivement le cache multiniveau KVCache hautes performances Mooncake Store de manière progressive. Dans le même temps, le projet sera compatible avec une variété de moteurs d’inférence et de ressources de stockage et de transmission sous-jacentes.

Actuellement, la partie Transfer Engine est open source dans le monde entier sur GitHub. L'objectif ultime du projet Mooncake est de créer une nouvelle interface standard pour le stockage sémantique en mémoire hautes performances pour l'ère des grands modèles et de fournir des solutions d'implémentation de référence associées.

Xu Xinran, vice-président de l'ingénierie chez Kimi Company, a déclaré : « Grâce à une coopération étroite avec le laboratoire MADSys de l'Université Tsinghua, nous avons créé conjointement Mooncake, une architecture d'inférence à grand modèle séparée, permettant l'optimisation ultime des ressources d'inférence.

Mooncake améliore non seulement l'expérience utilisateur, mais réduit également les coûts, offrant une solution efficace pour le traitement de textes longs et les exigences de concurrence élevées. " Il espère que davantage d'entreprises et d'institutions de recherche rejoindront le projet Mooncake pour explorer conjointement une architecture de système de raisonnement modèle plus efficace, afin que les produits basés sur une technologie de grands modèles tels que les assistants IA puissent bénéficier à un plus large éventail de personnes.

Entrée du projet : https://github.com/kvcache-ai/Mooncake

Souligner:

Kimi et l'Université Tsinghua ont publié conjointement le système de raisonnement Mooncake pour améliorer l'efficacité du raisonnement de l'IA.

Le projet Mooncake est open source sur GitHub et vise à créer une interface standard de stockage sémantique en mémoire hautes performances.

Nous attendons avec impatience la participation d'un plus grand nombre d'entreprises et d'institutions de recherche pour promouvoir conjointement les progrès de la technologie de l'IA.

Le lancement du projet open source Mooncake marque une nouvelle étape dans l'architecture des systèmes d'inférence de grands modèles. Ses performances efficaces et son modèle de coopération ouvert favoriseront efficacement le progrès et l’application de la technologie de l’intelligence artificielle et contribueront à la construction d’un monde plus intelligent.