Meta AI a récemment ouvert un modèle de langage multimodal appelé SPIRIT LM. Il s'agit d'un outil puissant qui peut librement mélanger le texte et la parole. Il est basé sur un modèle de langage textuel pré-entraîné avec 7 milliards de paramètres et est étendu à la modalité vocale. formation continue. SPIRIT LM peut non seulement comprendre et générer du texte et de la parole, mais plus important encore, il peut mélanger les deux pour réaliser de multiples fonctions telles que la reconnaissance vocale, la synthèse vocale, la classification de la parole, etc. Il est particulièrement efficace pour l'expression émotionnelle et peut générer des émotions plus naturelles. et émotionnelle, grâce au design de ses deux versions : "Basic Edition" et "Expression Edition".

Meta AI a récemment mis en open source un modèle de langage multimodal de base appelé SPIRIT LM, qui peut librement mélanger du texte et de la parole, ouvrant ainsi de nouvelles possibilités pour les tâches multimodales d'audio et de texte.

SPIRIT LM est basé sur un modèle de langage textuel pré-entraîné de 7 milliards de paramètres et s'étend aux modalités de parole à travers une formation continue sur les unités de texte et de parole. Il peut comprendre et générer du texte comme un grand modèle de texte, et il peut également comprendre et générer de la parole. Il peut même mélanger du texte et de la parole pour créer divers effets magiques. Par exemple, vous pouvez l'utiliser pour la reconnaissance vocale et convertir la parole en ! texte ; vous pouvez également l'utiliser pour la synthèse vocale afin de convertir du texte en parole ; vous pouvez également l'utiliser pour la classification de la parole afin de déterminer l'émotion qu'exprime un morceau de discours.

Ce qui est encore plus puissant, c'est que SPIRIT LM est également particulièrement doué pour « l'expression émotionnelle » ! Il peut reconnaître et générer une variété d'intonations et de styles de voix différents, rendant la voix de l'IA plus naturelle et plus émotionnelle. Vous pouvez imaginer que la voix générée par SPIRIT LM n'est plus la voix froide de la machine, mais comme une vraie personne parlant, pleine de joie, de colère, de chagrin et de joie !

Afin de rendre l'IA plus « émotionnelle », les chercheurs de Meta ont également spécialement développé deux versions de SPIRIT LM :

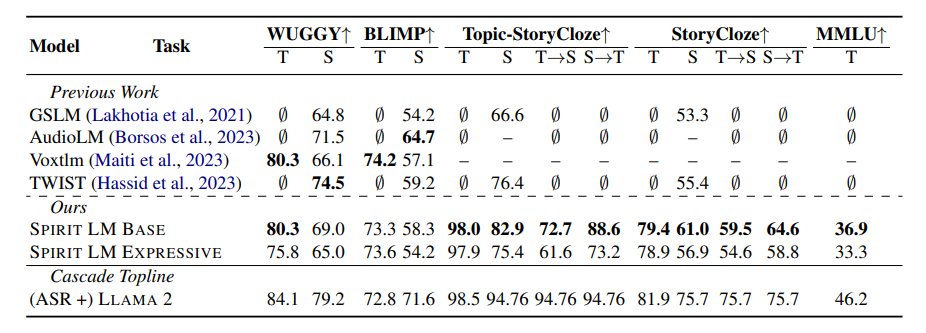

« Basic Edition » (BASE) : Cette version se concentre principalement sur les informations phonémiques de la parole, qui constituent la « composition de base » de la parole.

« Version expressive » (EXPRESSIVE) : en plus des informations sur le phonème, cette version ajoute également des informations sur le ton et le style, ce qui peut rendre la voix de l'IA plus vive et plus expressive.

Alors, comment SPIRIT LM fait-il tout cela ?

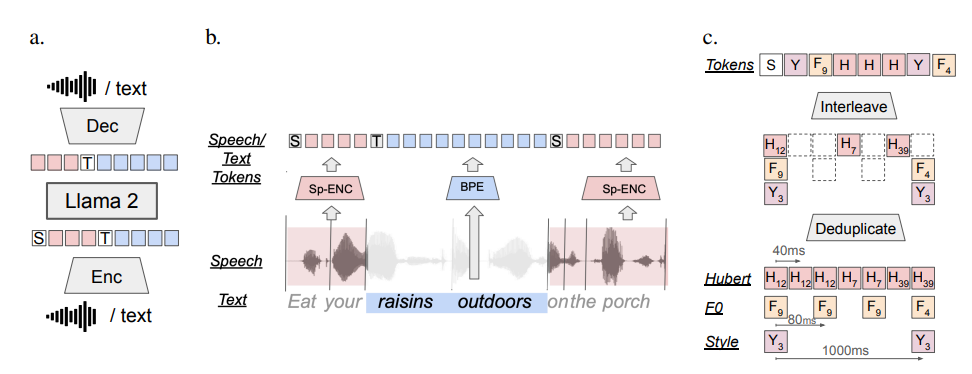

En termes simples, SPIRIT LM est formé sur la base de LLAMA2, un grand modèle de texte super puissant précédemment publié par Meta. Les chercheurs ont « transmis » une grande quantité de données textuelles et vocales à LAMA2 et ont adopté une méthode spéciale de « formation entrelacée » afin que LAMA2 puisse apprendre les règles du texte et de la parole en même temps.

Afin de tester la capacité « d'expression émotionnelle » de SPIRIT LM, les chercheurs de Meta ont également conçu un nouveau test de référence : le « Speech-Text Sentiment Preservation Benchmark » (STSP). Ce test de référence contient une variété d'invites vocales et textuelles exprimant différentes émotions pour tester si le modèle d'IA peut reconnaître et générer avec précision de la parole et du texte avec les émotions correspondantes. Les résultats montrent que la « version expression » de SPIRIT LM fonctionne bien en matière de rétention des émotions et est actuellement le premier modèle d'IA capable de conserver des informations émotionnelles à travers les modalités !

Bien entendu, les chercheurs de Meta ont également admis que SPIRIT LM avait encore de nombreux points à améliorer. Par exemple, SPIRIT LM ne prend actuellement en charge que l'anglais et doit être étendu à d'autres langues à l'avenir ; l'échelle du modèle de SPIRIT LM n'est pas assez grande et il est nécessaire de continuer à étendre l'échelle du modèle et à améliorer les performances du modèle dans l'avenir.

SPIRIT LM est l’avancée majeure de Meta dans le domaine de l’IA. Il nous ouvre la porte au monde « sonore et émotionnel » de l’IA. Je pense que dans un avenir proche, nous verrons des applications plus intéressantes développées sur la base de SPIRIT LM, afin que l'IA puisse non seulement parler avec éloquence, mais aussi exprimer des émotions comme de vraies personnes et communiquer avec nous de manière plus naturelle et cordiale !

Adresse du projet : https://speechbot.github.io/spiritlm/

Adresse papier : https://arxiv.org/pdf/2402.05755

Dans l’ensemble, l’open source de SPIRIT LM offre de nouvelles opportunités pour le développement de l’IA multimodale. Ses puissantes capacités d’expression émotionnelle et ses capacités de traitement de l’information multimodale annoncent de futures innovations dans la manière dont l’IA interagit avec les humains. Nous attendons avec impatience que SPIRIT LM soit implémenté dans davantage de langages et de scénarios d'application à l'avenir.