L'équipe de recherche de l'Université de Washington a lancé un nouveau modèle de suivi visuel SAMURAI, basé sur SAM2 et visant à surmonter les défis du suivi visuel dans des scènes complexes, en particulier le suivi d'objets en mouvement rapide et auto-occlusifs. SAMURAI améliore considérablement les capacités de prédiction du mouvement des objets et la précision de la sélection des masques en introduisant des signaux de mouvement temporels et des mécanismes de sélection de mémoire sensibles au mouvement, permettant ainsi un suivi robuste et précis sans recyclage et fonctionnant correctement sur plusieurs ensembles de données de référence.

Récemment, une équipe de recherche de l'Université de Washington a publié un nouveau modèle de suivi visuel appelé SAMURAI. Ce modèle est basé sur le Segment Anything Model2 (SAM2) et est conçu pour résoudre les défis rencontrés dans le suivi visuel d'objets dans des scènes complexes, en particulier lorsqu'il s'agit d'objets se déplaçant rapidement et auto-occlusifs.

SAM2 fonctionne bien dans les tâches de segmentation d'objets, mais présente certaines limites en matière de suivi visuel. Par exemple, dans des scènes encombrées, la mémorisation à fenêtre fixe ne prend pas en compte la qualité de la mémoire sélectionnée, ce qui peut entraîner la propagation d'erreurs tout au long de la séquence vidéo.

Afin de résoudre ce problème, l'équipe de recherche a proposé SAMURAI, qui améliore considérablement la capacité de prédiction du mouvement des objets et la précision de la sélection du masque en introduisant des signaux de mouvement temporels et un mécanisme de sélection de mémoire de perception du mouvement. Cette innovation permet à SAMURAI d’obtenir un suivi robuste et précis sans avoir besoin de recyclage ou de réglage fin.

En termes de fonctionnement en temps réel, SAMURAI a démontré de solides performances sans tir, ce qui signifie que le modèle peut toujours fonctionner correctement sans être entraîné sur un ensemble de données spécifique.

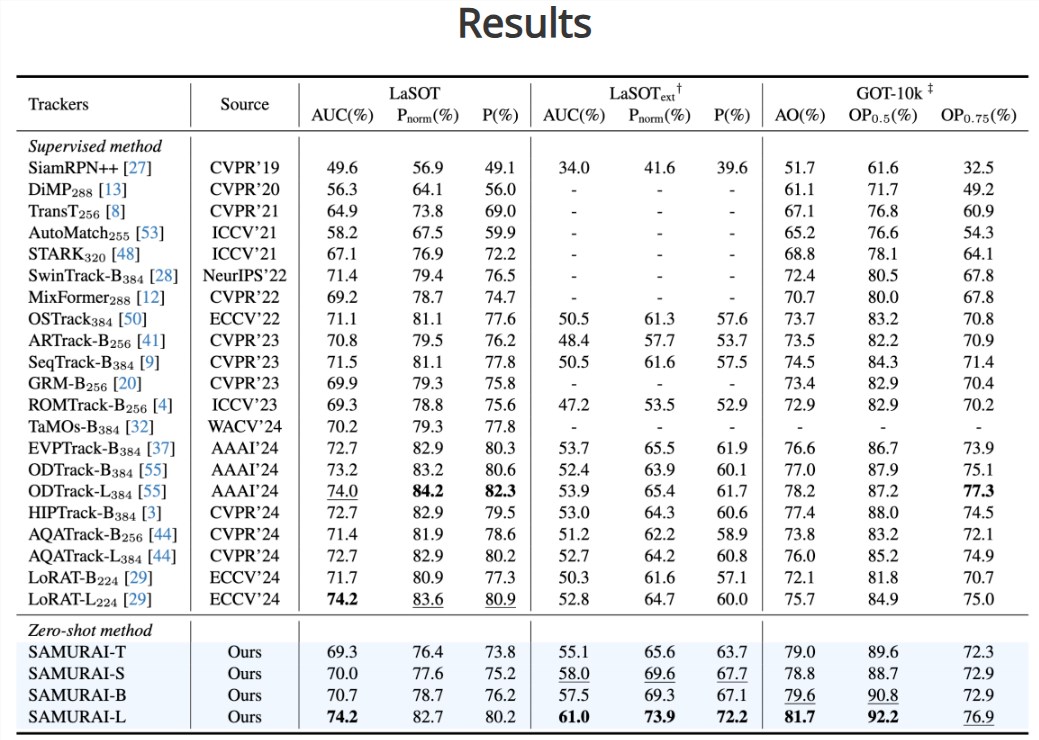

Grâce à l'évaluation, l'équipe de recherche a constaté que le taux de réussite et la précision de SAMURAI sur plusieurs ensembles de données de référence ont été considérablement améliorés. Sur l'ensemble de données LaSOT-ext, SAMURAI a obtenu une augmentation de l'AUC de 7,1 %, tandis que sur l'ensemble de données GOT-10k, il a obtenu une augmentation de l'AO de 3,5 %. De plus, par rapport aux méthodes entièrement supervisées, SAMURAI fonctionne de manière tout aussi compétitive sur l'ensemble de données LaSOT, démontrant sa robustesse et son large potentiel d'application dans des scénarios de suivi complexes.

L'équipe de recherche a déclaré que le succès de SAMURAI jette les bases de l'application future de la technologie de suivi visuel dans des environnements plus complexes et dynamiques. Ils espèrent que cette innovation pourra promouvoir le développement du domaine du suivi visuel, répondre aux besoins des applications en temps réel et fournir des capacités de reconnaissance visuelle plus fortes pour divers appareils intelligents.

Entrée du projet : https://yangchris11.github.io/samurai/

Souligner:

SAMURAI est une amélioration innovante du modèle SAM2, visant à améliorer les capacités de suivi visuel d'objets dans des scènes complexes.

En introduisant un mécanisme de mémoire sensible au mouvement, SAMURAI est capable de prédire avec précision le mouvement de l'objet et d'optimiser la sélection du masque, évitant ainsi la propagation des erreurs.

Sur plusieurs ensembles de données de référence, SAMURAI affiche de solides performances de tir nul, améliorant considérablement le taux de réussite et la précision du suivi.

L'émergence du modèle SAMURAI marque un progrès significatif dans la technologie de suivi visuel. Sa grande précision et sa robustesse dans des scènes complexes apportent un soutien solide à l'amélioration des capacités de reconnaissance visuelle des futurs appareils intelligents. Il vaut la peine d'espérer son utilisation dans davantage de domaines. .