Alibaba Cloud a publié le modèle de grande langue récemment mis à niveau Qwen2.5-turbo. Cela représente un énorme saut pour les longues capacités de traitement du texte. Ce modèle est excellent dans plusieurs tests de référence, en particulier en termes de compréhension du texte long, et dépasse le GPT-4, et tout en maintenant la précision du traitement de texte court, il a atteint une vitesse de raisonnement élevée et un coût extrêmement faible.

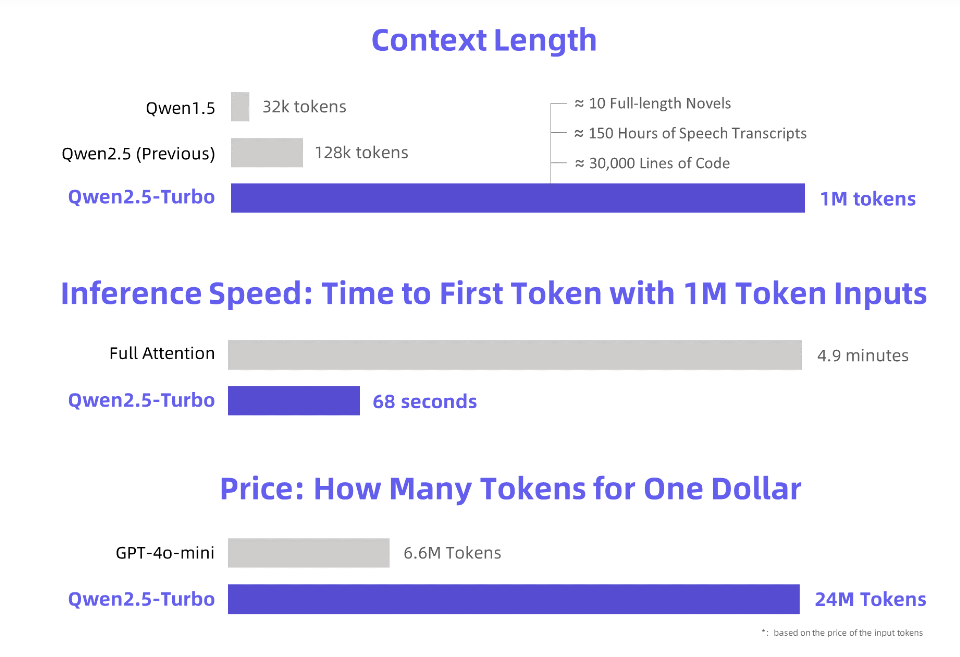

Alibaba Cloud a lancé le nouveau modèle de langue QWEN2.5-turbo nouvellement mis à niveau, et sa longueur contextuelle dépasse le jeton incroyable de 1 million. Qu'est-ce qui équivaut à ce concept?

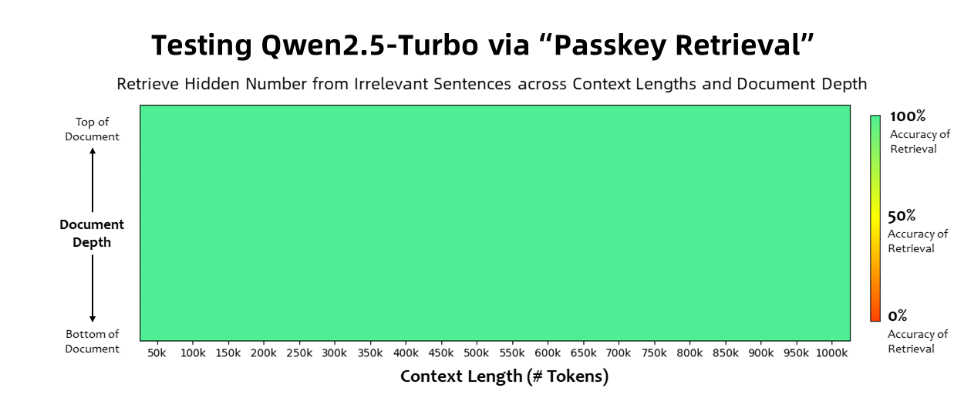

Le modèle QWEN2.5-turbo a atteint une précision de 100% dans la tâche de récupération de lakeke et dépasse les modèles égaux GPT-4 en termes de capacités de compréhension de texte longs. Ce modèle a marqué 93,1 dans le test de référence en texte long de la règle, tandis que le score GPT-4 n'est que de 91,6, et le score de GLM4-9B-1M est de 89,9.

En plus des longues capacités de traitement du texte, Qwen2.5-turbo a également la précision du traitement de texte court.

En adoptant un mécanisme d'attention clairsemé, le modèle QWEN2.5-turbo traitera un premier temps de jeton de 1 million de jetons de 4,9 minutes à 68 secondes, atteignant une amélioration de la vitesse de 4,3 fois.

Dans le même temps, le coût du traitement de 1 million de jetons n'est que de 0,3 yuan.

Alibaba Cloud a préparé une série de démonstrations pour le modèle QWEN2.5-turbo, montrant ses applications telles que la compréhension approfondie des romans longs, de l'aide au code et de plusieurs articles. Par exemple, après que l'utilisateur a téléchargé un roman chinois à trois corps contenant 690 000 jetons, le modèle a résumé avec succès l'intrigue de chaque roman en anglais.

Les utilisateurs peuvent découvrir les fonctionnalités puissantes du modèle QWEN2.5-turbo via le service API d'Alibaba Cloud Model Studio, HuggingFace Demo ou Modelcope Demo.

Alibaba Cloud a déclaré qu'à l'avenir, il continuera d'optimiser le modèle, d'améliorer ses préférences humaines dans les tâches de séquence longue, d'optimiser davantage l'efficacité du raisonnement, de réduire le temps de calcul et d'essayer de lancer un modèle de console à long terme de plus en plus fort et plus fort .

Introduction officielle: https://qwenlm.github.io/blog/qwen2.5-turbo/

Démonstration en ligne: https://huggingface.co/spaces/qwen/qwen2.5-turbo-1m-demo

Document API: https://help.aliyun.com/zh/model-studio/getting-started/first-dicall-qwen

Qwen2.5-Turbo a ouvert de nouvelles possibilités pour l'application de modèles de langue importants avec sa forte capacité de traitement du texte long et son faible coût, et il vaut la peine d'attendre à l'avenir. Pour plus d'informations, veuillez visiter le lien fourni.