La réduction du coût de la formation des grands modèles est un point chaud de la recherche actuelle dans le domaine de l’intelligence artificielle. La recherche récente publiée par l'équipe de Tencent Hunyuan aborde en profondeur les règles d'échelle de la formation à la quantification en virgule flottante de faible taille, fournissant de nouvelles idées pour une formation efficace de grands modèles. Grâce à un grand nombre d'expériences, cette étude a analysé l'impact de facteurs tels que la taille du modèle, le volume des données d'entraînement et la précision de la quantification sur l'effet de l'entraînement, et a finalement abouti à des règles sur la façon d'allouer efficacement les ressources de formation avec différentes précisions pour obtenir l'effet d'entraînement. meilleurs résultats. Cette recherche a non seulement une importance théorique importante, mais fournit également des conseils précieux pour l'application pratique de grands modèles.

Aujourd'hui, avec le développement rapide du Large Language Model (LLM), le coût de la formation et de l'inférence des modèles est de plus en plus au centre de la recherche et des applications. Récemment, l'équipe de Tencent Hunyuan a publié une étude importante, qui a exploré en profondeur les « lois de mise à l'échelle » de la formation à la quantification à virgule flottante de faible taille, c'est-à-dire la loi de mise à l'échelle de la formation à la quantification à virgule flottante. Le cœur de cette recherche est d’explorer comment réduire considérablement les coûts de calcul et de stockage sans perdre en performances en réduisant la précision du modèle.

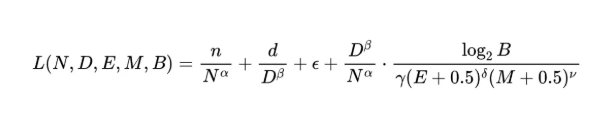

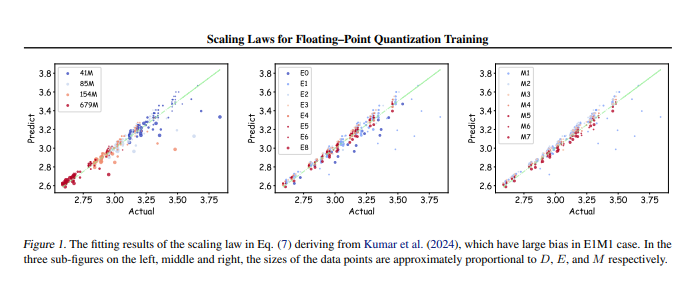

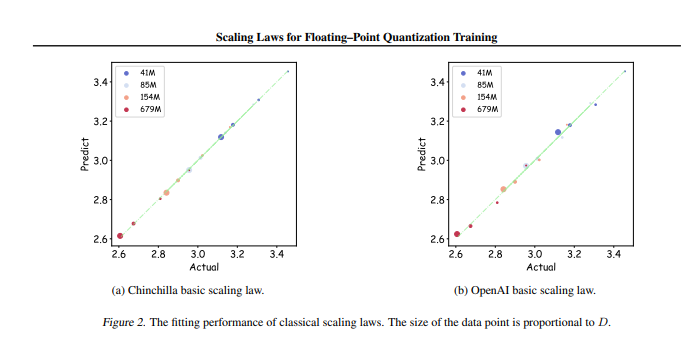

L'équipe de recherche a mené jusqu'à 366 ensembles de formation de quantification en virgule flottante avec différentes tailles et précisions de paramètres, et a systématiquement analysé divers facteurs qui affectent l'effet de formation, notamment la taille du modèle (N), la quantité de données de formation (D), le bit exponentiel ( E), bits de mantisse (M) et granularité de quantification (B). Grâce à ces expériences, les chercheurs ont dérivé un ensemble unifié de lois de mise à l'échelle, qui ont révélé comment configurer efficacement les données d'entraînement et les paramètres du modèle avec différentes précisions pour obtenir le meilleur effet d'entraînement.

Le plus critique est que la recherche souligne que dans la formation arbitraire à la quantification à virgule flottante de faible précision, il existe un « effet limite », c'est-à-dire que sous une quantité spécifique de données, les performances du modèle atteindront leur niveau optimal et dépasseront cette quantité de données peut entraîner un déclin. En outre, l'étude a également révélé que la précision théoriquement la plus rentable de la formation à la quantification en virgule flottante devrait être comprise entre 4 et 8 bits, ce qui revêt une importance directrice importante pour le développement d'un LLM efficace.

Cette recherche comble non seulement le vide dans le domaine de la formation à la quantification en virgule flottante, mais fournit également une référence aux futurs fabricants de matériel pour les aider à optimiser les capacités de calcul en virgule flottante sous différentes précisions. En fin de compte, cette recherche fournit une orientation claire pour la pratique de la formation sur de grands modèles, garantissant que des effets de formation efficaces peuvent toujours être obtenus même avec des ressources limitées.

Adresse papier : https://arxiv.org/pdf/2501.02423

En bref, cette recherche menée par l'équipe de Tencent Hunyuan fournit une solution efficace pour réduire le coût de la formation de grands modèles. Les règles d'échelle et la plage de précision optimale découvertes auront un impact profond sur le développement et l'application de grands modèles à l'avenir. Ce travail indique la direction vers une formation de grands modèles hautes performances et à faible coût, qui mérite une attention et des recherches approfondies.