L'équipe Alibaba Cloud Tongyi lance un nouveau modèle de récompense du processus de raisonnement mathématique Qwen2.5-Math-PRM. Ce modèle est disponible en tailles 72B et 7B. Il surpasse considérablement les modèles open source similaires en termes de performances, en particulier pour l'identification des erreurs de raisonnement. Il convient de noter que la version 7B a même dépassé le populaire GPT-4o, démontrant les progrès révolutionnaires d'Alibaba Cloud dans le domaine de la recherche et du développement de modèles d'inférence. Afin d'évaluer les performances du modèle de manière plus complète, l'équipe a également ouvert la première norme d'évaluation de niveau ProcessBench, qui contient 3 400 questions mathématiques couvrant la difficulté de l'Olympiade mathématique, et est marquée par des processus de raisonnement détaillés par des experts pour garantir la scientificité. et la rigueur de l'évaluation.

Aujourd'hui, l'équipe Alibaba Cloud Tongyi a officiellement publié un nouveau modèle de récompense du processus de raisonnement mathématique Qwen2.5-Math-PRM. Le modèle est disponible dans les tailles 72B et 7B, et ses performances sont nettement meilleures que celles des modèles de récompense de processus open source similaires, en particulier pour identifier les erreurs d'inférence.

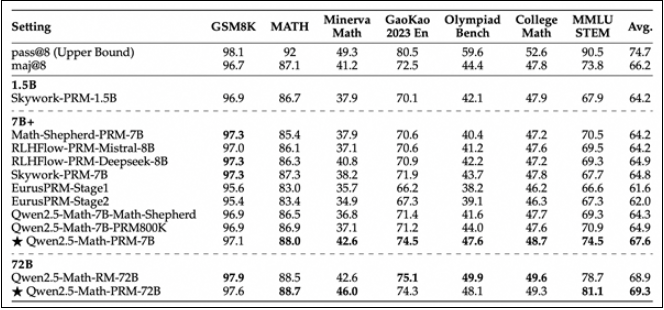

La version 7B de Qwen2.5-Math-PRM a étonnamment surpassé le populaire GPT-4o du secteur. Cette réalisation marque une étape importante pour Alibaba Cloud dans le développement de modèles d'inférence. Afin d'évaluer de manière exhaustive les performances du modèle en matière de raisonnement mathématique, l'équipe de Tongyi a également ouvert la première norme d'évaluation de niveau étape, ProcessBench. Cette norme d'évaluation couvre 3 400 cas de test de problèmes mathématiques, y compris des questions difficiles du Concours International de Mathématiques. Chaque cas est marqué par un processus de raisonnement détaillé par des experts humains pour garantir la scientificité et l'exhaustivité de l'évaluation.

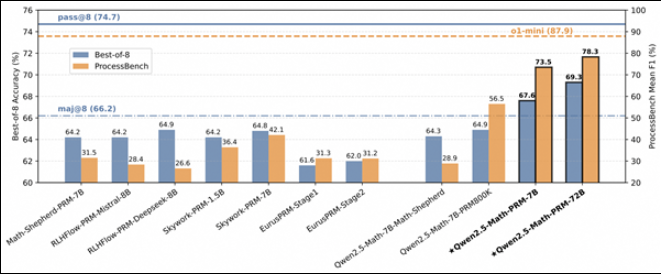

En évaluant les performances de Qwen2.5-Math-PRM sur ProcessBench, l'équipe de recherche a constaté que les modèles de taille 72B et 7B fonctionnaient bien. En particulier, la version 7B surpasse non seulement le modèle open source de la même taille, mais surpasse même le modèle fermé GPT-4o-0806 à certains égards. Cela prouve le grand potentiel du modèle de récompense de processus (PRM) pour améliorer la fiabilité du raisonnement et fournit de nouvelles idées pour le développement de futures technologies de supervision des processus de raisonnement.

Ce travail innovant de l'équipe d'Alibaba Cloud Tongyi favorise non seulement l'avancement de la technologie de raisonnement de l'intelligence artificielle, mais fournit également une référence précieuse aux autres développeurs du secteur. Grâce à l'open source, l'équipe de Tongyi espère partager son expérience avec davantage de chercheurs et promouvoir le progrès technologique dans l'ensemble de l'industrie.

La sortie de Qwen2.5-Math-PRM marque une nouvelle avancée pour les grands modèles dans le domaine du raisonnement mathématique. Sa fonctionnalité open source offre également une grande commodité pour la recherche et les applications dans le monde universitaire et industriel. Plus de possibilités dans le développement futur de l'intelligence artificielle.