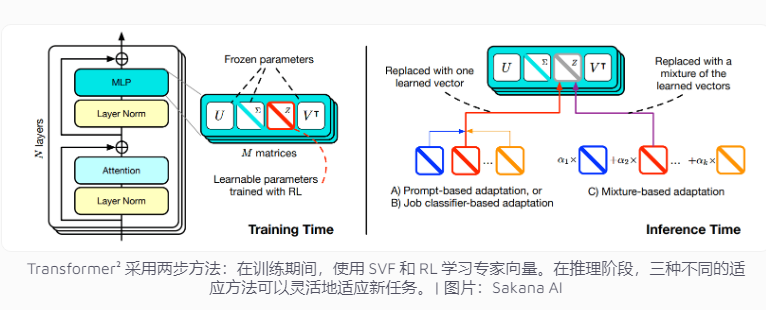

La société japonaise Sakana AI a récemment lancé Transformer², une technologie innovante conçue pour améliorer l'adaptabilité des tâches de modèle de langage. Contrairement aux systèmes d'IA traditionnels qui doivent traiter plusieurs tâches à la fois, Transformer² utilise un apprentissage en deux étapes, en utilisant des vecteurs experts et une technologie de réglage fin des valeurs singulières (SVF), afin de pouvoir s'adapter efficacement aux nouvelles tâches sans recycler l'ensemble du réseau, de manière significative. Cela réduit considérablement la consommation de ressources et améliore la flexibilité et la précision du modèle. Cette technologie se concentre sur des tâches spécifiques telles que les opérations mathématiques, la programmation et le raisonnement logique en apprenant des vecteurs experts qui contrôlent l'importance des connexions réseau, et combine l'apprentissage par renforcement pour optimiser davantage les performances du modèle.

Les systèmes d’intelligence artificielle actuels doivent généralement gérer plusieurs tâches au cours d’une seule formation. Cependant, ils sont susceptibles de rencontrer des défis inattendus lorsqu’ils sont confrontés à de nouvelles tâches, ce qui limite l’adaptabilité du modèle. Le concept de conception de Transformer² vise à résoudre ce problème, en utilisant une technologie de vecteur expert et de réglage fin des valeurs singulières (SVF) pour permettre au modèle de faire face de manière flexible aux nouvelles tâches sans recycler l'ensemble du réseau.

Les méthodes de formation traditionnelles nécessitent d'ajuster les poids de l'ensemble du réseau neuronal, ce qui est non seulement coûteux, mais peut également amener le modèle à « oublier » les connaissances acquises précédemment. En revanche, les techniques SVF évitent ces problèmes en apprenant des vecteurs experts qui contrôlent l'importance de chaque connexion réseau. Les vecteurs experts aident le modèle à se concentrer sur des tâches spécifiques, telles que les opérations mathématiques, la programmation et le raisonnement logique, en ajustant la matrice de pondération des connexions réseau.

Cette approche réduit considérablement le nombre de paramètres requis pour adapter le modèle à de nouvelles tâches. Par exemple, la méthode LoRA nécessite 6,82 millions de paramètres, tandis que SVF ne nécessite que 160 000 paramètres. Cela réduit non seulement la consommation de mémoire et de puissance de traitement, mais empêche également le modèle d'oublier d'autres connaissances tout en se concentrant sur une certaine tâche. Plus important encore, ces vecteurs experts peuvent travailler ensemble efficacement pour améliorer l’adaptabilité du modèle à diverses tâches.

Pour améliorer encore l'adaptabilité, Transformer² introduit l'apprentissage par renforcement. Pendant le processus de formation, le modèle optimise en permanence les vecteurs experts en proposant des solutions de tâches et en obtenant des commentaires, améliorant ainsi les performances sur les nouvelles tâches. L'équipe a développé trois stratégies pour tirer parti de ces connaissances expertes : les signaux adaptatifs, les classificateurs de tâches et l'adaptation en quelques coups. En particulier, la stratégie adaptative en quelques coups améliore encore la flexibilité et la précision du modèle en analysant des exemples de nouvelles tâches et en ajustant les vecteurs experts.

Transformer² surpasse la méthode traditionnelle LoRA sur plusieurs benchmarks. Sur les tâches mathématiques, ses performances ont augmenté de 16 % et les paramètres requis ont été considérablement réduits. Face à une nouvelle tâche, la précision de Transformer² était 4 % supérieure à celle du modèle d'origine, tandis que LoRA n'a pas réussi à atteindre les résultats escomptés.

Transformer² résout non seulement des problèmes mathématiques complexes, mais combine également des capacités de programmation et de raisonnement logique pour permettre le partage de connaissances entre domaines. Par exemple, l’équipe a découvert que des modèles plus petits peuvent également améliorer les performances en exploitant les connaissances de modèles plus grands en transférant des vecteurs experts, ce qui offre de nouvelles possibilités de partage de connaissances entre modèles.

Bien que Transformer² ait fait des progrès significatifs en termes d'adaptabilité des tâches, il se heurte encore à certaines limites. Actuellement, les vecteurs experts formés à l'aide de SVF ne peuvent s'appuyer que sur les capacités existantes du modèle pré-entraîné et ne peuvent pas ajouter de compétences complètement nouvelles. Un véritable apprentissage continu signifie que le modèle peut acquérir de nouvelles compétences de manière indépendante. Cet objectif prend encore du temps à atteindre. Comment étendre cette technique à de grands modèles comportant plus de 70 milliards de paramètres reste une question ouverte.

Dans l'ensemble, Transformer² présente un grand potentiel dans le domaine de l'apprentissage continu, et son utilisation efficace des ressources et son amélioration significative des performances ouvrent une nouvelle direction pour le développement des futurs modèles de langage. Cependant, la technologie doit encore être continuellement améliorée pour surmonter les limites existantes et atteindre de véritables objectifs d’apprentissage continu.