La compréhension de vidéos longues a toujours été un défi majeur dans le domaine de l'analyse vidéo. Les modèles traditionnels sont inefficaces lors du traitement de vidéos longues et sont difficiles à extraire efficacement les informations clés. Cet article présente une technologie de compression de balisage vidéo hiérarchique appelée HiCo, et le système « VideoChat-Flash » basé sur cette technologie, qui améliore considérablement la tâche « une aiguille dans la botte de foin » grâce à un apprentissage en plusieurs étapes et des capacités améliorées de compréhension des vidéos longues et considérablement réduites. exigences informatiques. L'équipe de recherche a construit un vaste ensemble de données contenant 300 000 heures de vidéo et 200 millions de mots d'annotations pour la formation et l'évaluation des modèles.

Plus précisément, HiCo réduit la complexité informatique en segmentant les longues vidéos en segments courts et en compressant les informations redondantes, tout en tirant parti des associations sémantiques avec les requêtes des utilisateurs pour réduire davantage le nombre de balises traitées. "VideoChat-Flash" adopte un schéma d'apprentissage en plusieurs étapes, utilisant d'abord de courtes vidéos pour un réglage fin supervisé, puis introduisant progressivement une formation vidéo longue, et enfin parvenant à une compréhension globale du corpus de longueurs mixtes. De plus, la tâche améliorée « une aiguille dans une botte de foin » améliore la compréhension du modèle du contexte et des configurations vidéo multi-sauts.

Dans la mise en œuvre spécifique du traitement vidéo long, « VideoChat-Flash » adopte un schéma d'apprentissage en plusieurs étapes allant des vidéos courtes aux vidéos longues. Les chercheurs ont d’abord utilisé de courtes vidéos et leurs annotations correspondantes pour un réglage fin supervisé, puis ont progressivement introduit de longues vidéos pour la formation, parvenant finalement à une compréhension globale du corpus de longueurs mixtes. Cette méthode améliore non seulement les capacités de perception visuelle du modèle, mais fournit également un support de données riche pour le traitement de vidéos longues. L'équipe de recherche a construit un énorme ensemble de données contenant 300 000 heures de vidéo et 200 millions de mots d'annotations.

De plus, une tâche améliorée « une aiguille dans une botte de foin » est proposée dans l'étude pour les configurations vidéo multi-sauts. Avec le nouveau benchmark, le modèle doit non seulement trouver une image cible unique dans la vidéo, mais également comprendre plusieurs séquences d'images interdépendantes, améliorant ainsi la capacité du modèle à comprendre le contexte.

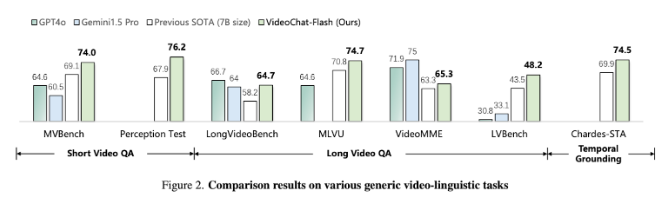

Les résultats expérimentaux montrent que la méthode proposée réduit le calcul de deux ordres de grandeur, et qu'elle fonctionne particulièrement bien dans les tests de référence de vidéos courtes et longues, devenant ainsi un leader dans le nouveau domaine de la compréhension des vidéos courtes. Dans le même temps, ce modèle surpasse également les modèles open source existants en termes de compréhension des vidéos longues, démontrant de fortes capacités de positionnement temporel.

Article : https://arxiv.org/abs/2501.00574

Souligner:

Les chercheurs ont proposé la technologie de compression hiérarchique des balises vidéo HiCo, qui réduit considérablement les exigences de calcul pour le traitement vidéo long.

Le système « VideoChat-Flash » adopte une méthode d'apprentissage en plusieurs étapes et combine des vidéos courtes et longues pour la formation, ce qui améliore la capacité de compréhension du modèle.

Les résultats expérimentaux montrent que cette méthode atteint de nouveaux standards de performance dans plusieurs tests de référence et devient un modèle avancé dans le domaine du traitement vidéo long.

Dans l’ensemble, cette recherche fournit une nouvelle solution pour une compréhension efficace des vidéos longues. La technologie HiCo et le système VideoChat-Flash ont réalisé des avancées significatives en termes d’efficacité informatique et de performances des modèles, jetant ainsi les bases des futures applications d’analyse de vidéos longues. Les résultats de la recherche ont une signification théorique importante et une valeur d’application pratique.