Le dernier modèle d'intelligence artificielle LlamaV-o1 publié par l'Université d'intelligence artificielle Mohammed bin Zayed (MBZUAI) aux Émirats arabes unis montre d'excellentes performances sur des tâches complexes de raisonnement de textes et d'images. Il combine des techniques avancées d’apprentissage des programmes et d’optimisation telles que la recherche de faisceaux pour établir une nouvelle référence dans le domaine de l’intelligence artificielle multimodale, notamment en termes de transparence et d’efficacité de l’inférence. LlamaV-o1 est non seulement capable de fournir des explications étape par étape du processus de raisonnement, mais surpasse également ses concurrents dans de multiples tests de référence, établissant ainsi une base solide pour ses applications dans des domaines tels que la finance, les soins médicaux et l'éducation.

L'Université d'intelligence artificielle Mohammed bin Zayed (MBZUAI) aux Émirats arabes unis a récemment publié un modèle d'intelligence artificielle avancé appelé LlamaV-o1, capable de résoudre efficacement des tâches complexes de raisonnement de textes et d'images.

Ce modèle établit une nouvelle référence dans les systèmes d'intelligence artificielle multimodaux en combinant un apprentissage pédagogique de pointe et des techniques d'optimisation avancées telles que Beam Search, notamment en termes de transparence et d'efficacité de l'inférence étape par étape.

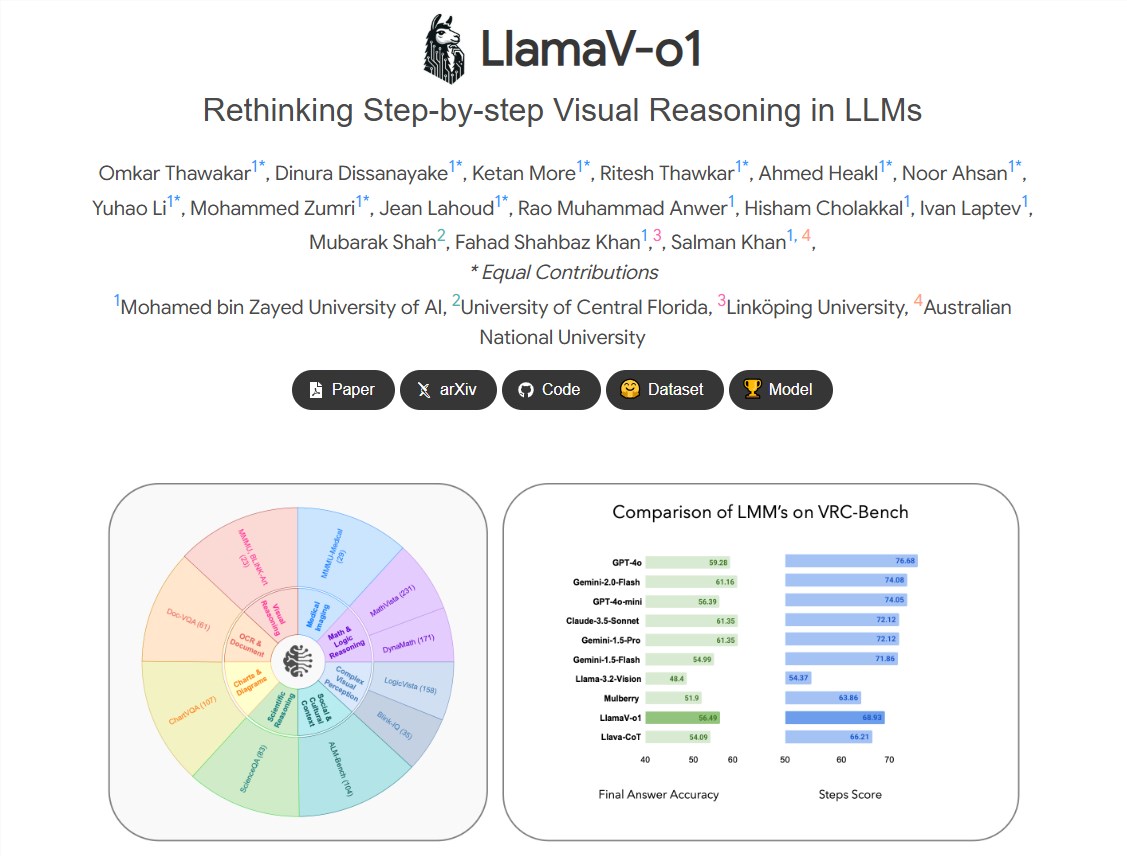

L'équipe de recherche de LlamaV-o1 a déclaré que le raisonnement est une capacité fondamentale pour résoudre des problèmes complexes en plusieurs étapes, en particulier dans des situations visuelles qui nécessitent une compréhension étape par étape. Spécialement optimisé, le modèle excelle dans de nombreux domaines, tels que l'analyse des graphiques financiers et de l'imagerie médicale. Parallèlement, l'équipe de recherche a également lancé VRC-Bench, un test de référence spécialement conçu pour évaluer les capacités de raisonnement étape par étape des modèles d'intelligence artificielle, comprenant plus de 1 000 échantillons et plus de 4 000 étapes de raisonnement, devenant ainsi un outil important. pour la recherche multimodale en intelligence artificielle.

En termes d'inférence, LlamaV-o1 a surpassé des concurrents tels que Claude3.5Sonnet et Gemini1.5Flash dans le benchmark VRC-Bench. Le modèle est non seulement capable de fournir des explications étape par étape, mais il est également performant dans des tâches visuelles complexes. Au cours du processus de formation, l'équipe de recherche a utilisé un ensemble de données LLaVA-CoT-100k optimisé pour les tâches d'inférence. Les résultats des tests ont montré que le score d'étape d'inférence de LlamaV-o1 atteignait 68,93, dépassant largement les autres modèles open source.

La transparence de LlamaV-o1 lui confère une valeur d'application importante dans des secteurs tels que la finance, la médecine et l'éducation. Par exemple, dans l’analyse d’images médicales, les radiologues doivent comprendre comment l’IA parvient aux résultats de diagnostic. Un processus de raisonnement aussi transparent peut accroître la confiance et garantir la conformité. De plus, LlamaV-o1 fonctionne également bien dans l'interprétation de données visuelles complexes, en particulier dans les applications d'analyse financière.

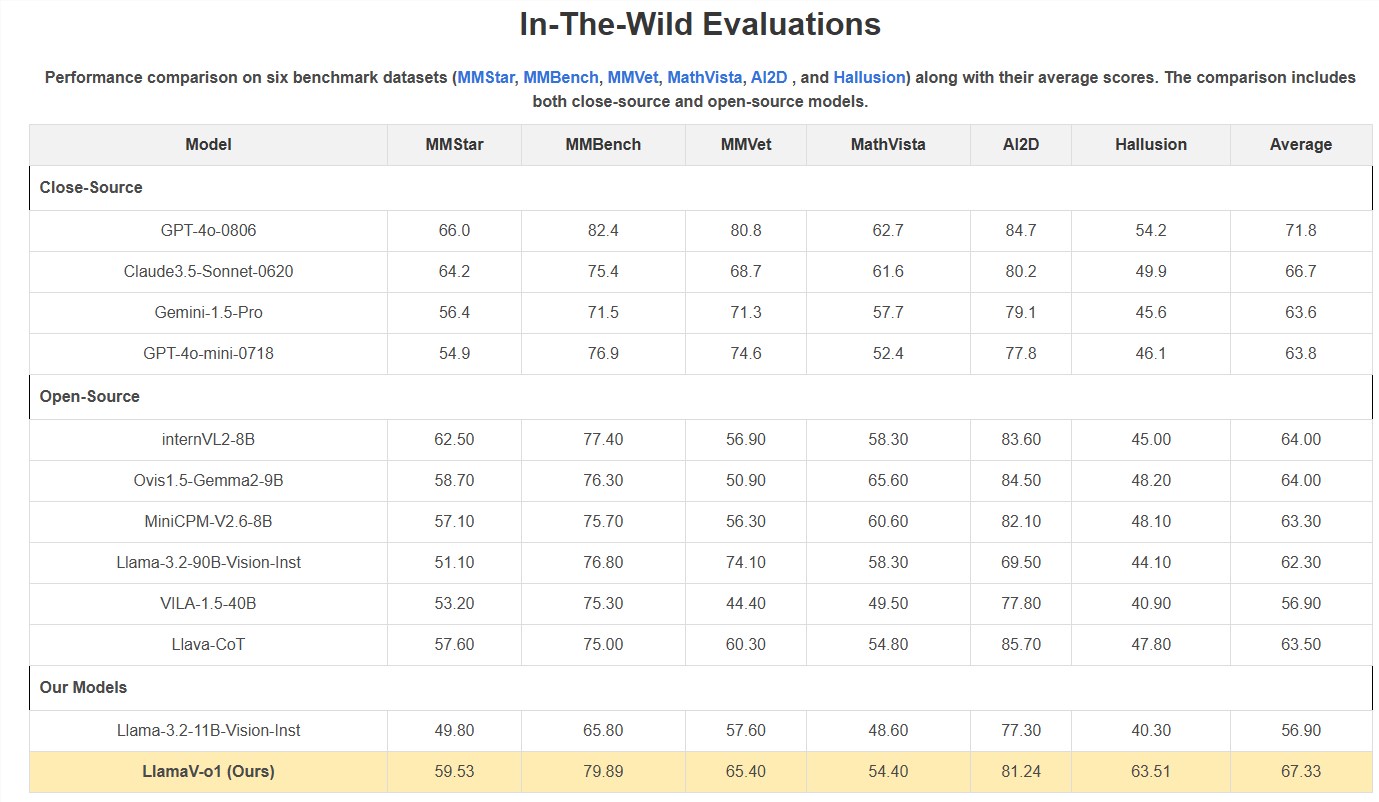

La sortie de VRC-Bench marque un changement majeur dans les normes d'évaluation de l'intelligence artificielle, mettant l'accent sur chaque étape du processus de raisonnement et favorisant le développement de la recherche scientifique et de l'enseignement. Les performances de LlamaV-o1 sur VRC-Bench prouvent son potentiel, avec son score moyen atteignant 67,33 % dans plusieurs benchmarks, ce qui le place en tête parmi les modèles open source.

Bien que LlamaV-o1 ait réalisé des progrès significatifs dans le raisonnement multimodal, les chercheurs préviennent également que les capacités du modèle sont limitées par la qualité des données d'entraînement et peuvent avoir de mauvais résultats face à des signaux hautement spécialisés ou contradictoires. Néanmoins, le succès de LlamaV-o1 démontre le potentiel des systèmes d’intelligence artificielle multimodaux, et le besoin de modèles interprétables va croître à l’avenir.

Projet : https://mbzuai-oryx.github.io/LlamaV-o1/

Souligner:

LlamaV-o1 est un modèle d'IA récemment publié qui est efficace pour résoudre des tâches complexes de raisonnement de texte et d'images.

Le modèle fonctionne de manière supérieure par rapport au benchmark VRC-Bench, fournissant un processus d'inférence transparent étape par étape.

LlamaV-o1 a une valeur d'application importante dans des secteurs tels que la médecine et la finance, et peut accroître la confiance et la conformité.

Dans l’ensemble, l’émergence du modèle LlamaV-o1 marque une avancée importante dans la technologie de l’intelligence artificielle multimodale, et sa transparence et ses capacités de raisonnement efficaces apporteront un énorme potentiel d’application à diverses industries. À l’avenir, avec les progrès continus de la technologie et l’accumulation de données, les modèles d’IA interprétables comme LlamaV-o1 joueront un rôle de plus en plus important.