Les modèles Deepseek-V3 et Deepseek-R1 de Deepseek ont provoqué une énorme réponse dans le domaine de l'intelligence artificielle. En particulier, les modèles open source Deepseek-R1 sont des poids et révèlent toutes les technologies de formation, ce qui a attiré une grande attention dans l'industrie et a également exprimé une grande pression à des entreprises telles que Meta. Meta Engineers a même déclaré publiquement que l'équipe était en panique et avait tenté de reproduire la technologie de Deepseek.

La série de modèles récemment lancée par Deepseek a provoqué un choc dans le cercle mondial de l'IA. Deepseek-V3 atteint des performances élevées à faible coût et est comparable au modèle de source fermée les plus élevés dans de nombreuses revues; Il est également open source.

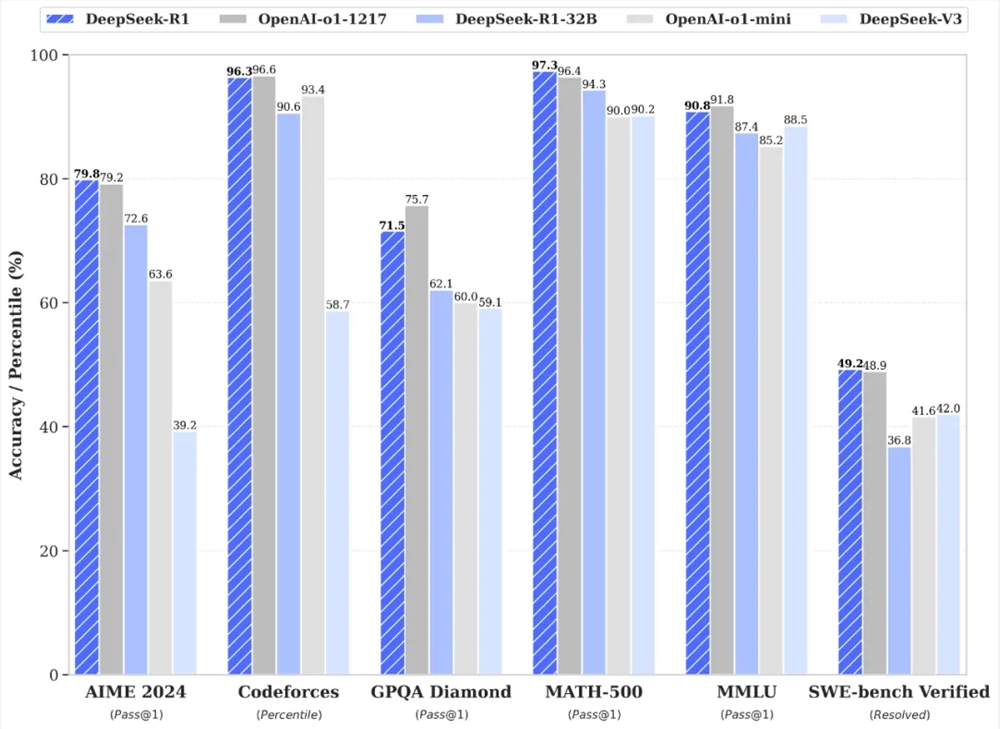

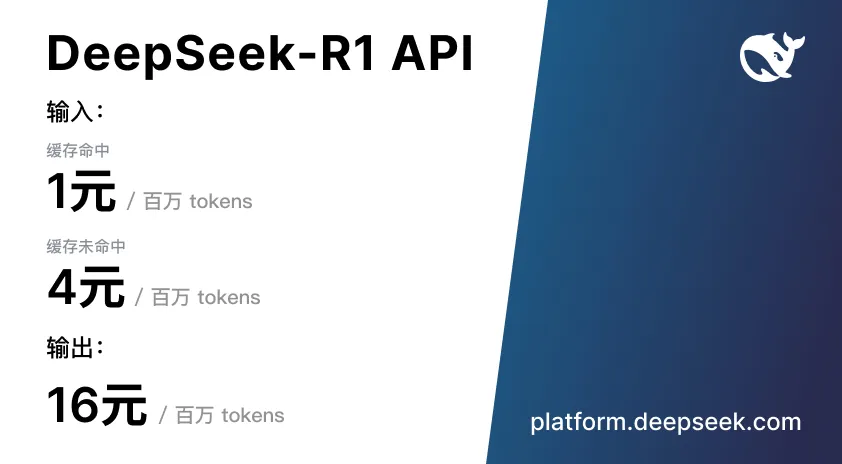

Deepseek révèle également toutes les techniques de formation. R1 est comparé au modèle O1 d'Openai, et la technologie d'apprentissage par renforcement est largement utilisée au stade post-entraînement. Deepseek a déclaré que R1 est comparable à l'O1 dans des tâches telles que les mathématiques, le code, le raisonnement en langue naturelle et le prix de l'API est inférieur à 4% de l'O1.

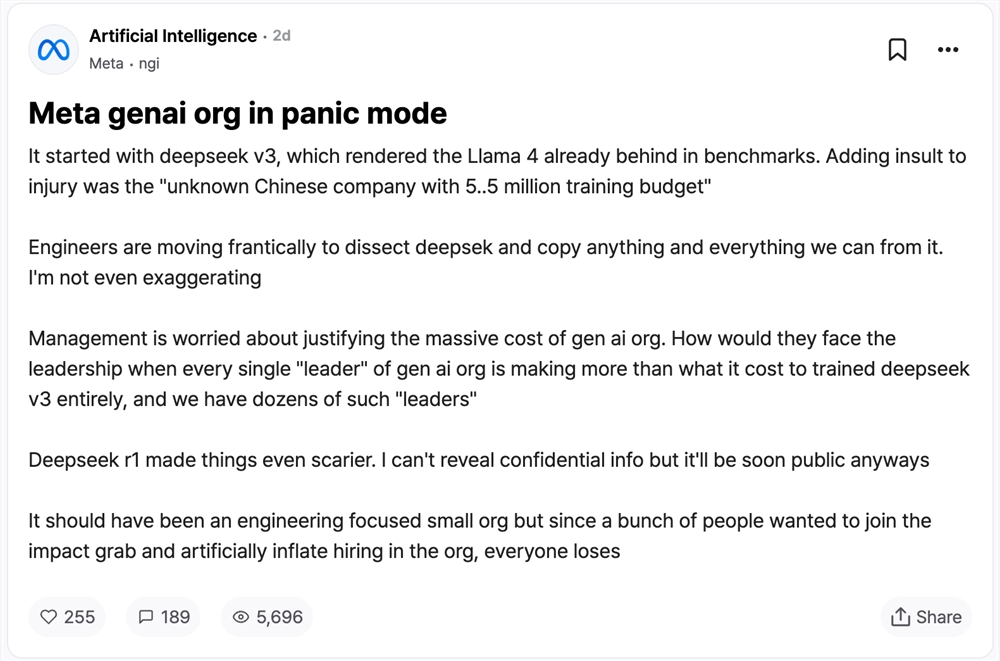

Récemment, le TeamBlind, un article anonyme d'un Meta Employé dans la communauté de travail anonyme à l'étranger, était particulièrement populaire. Le lancement de Deepseek V3 met Llama 4 en retard dans les références, et l'équipe Meta Generative IA est en panique. Une "entreprise chinoise inconnue" a un budget de 5,5 millions de dollars pour terminer la formation et gifler le grand modèle existant en face.

Les méta ingénieurs démantement Deepseek et essaient de copier, tandis que la direction est inquiet de la façon d'expliquer les coûts élevés à la haute direction. L'émergence de Deepseek R1 aggrave la situation, et bien que certaines informations ne puissent pas encore être divulguées, elles seront rendues publiques bientôt, et la situation peut être encore plus défavorable d'ici là.

La traduction du poste anonyme des méta-employés est la suivante (traduite par Deepseek R1):

Le département de l'IA méta-génératif entre dans l'état d'urgence

Tout a commencé avec le Deepseek V3 - cela a rendu instantanément le score de référence de Llama 4. Ce qui est encore plus embarrassant, c'est que "une entreprise chinoise inconnue a réalisé une telle percée avec seulement 5 millions de dollars de budget de formation".

L'équipe d'ingénieurs démantèle frénétiquement l'architecture Deepseek, essayant de reproduire tous ses détails techniques. Ce n'est en aucun cas une exagération, notre base de code subit une recherche de style tapis.

La direction meurt sur la rationalité des énormes dépenses du ministère. Lorsque le salaire annuel de chaque "leader" dans le département générateur de l'IA dépasse l'ensemble du coût de formation de Deepseek V3, et que nous avons des dizaines de ces "dirigeants", comment devraient-ils expliquer à la haute direction?

Deepseek R1 rend la situation encore plus grave. Bien que les informations confidentielles ne puissent pas être divulguées, les données pertinentes seront rendues publiques bientôt.

Ce devrait être une équipe qualifiée axée sur la technologie, mais la structure organisationnelle a été délibérément élargie en raison de l'afflux d'un grand nombre de personnes pour l'influence. Le résultat de ce jeu de Thrones? En fin de compte, tout le monde est devenu perdant.

Introduction aux modèles de la série DeepseekDeepseek-V3: est un modèle de langue expert hybride (MOE) avec une quantité de paramètre de 671b, et chaque jeton active 37B. Il adopte l'attention latente multi-tête (MLA) et l'architecture Deepseekmoe, pré-formée sur 14,8 billions de jetons de haute qualité, et après l'apprentissage de finition et de renforcement supervisé, il dépasse certains modèles open source dans plusieurs évaluations, et est associé à GPT-4O et Claude 3.5 Les modèles de source fermée comme Sonnet ont des performances comparables. Le coût de formation est faible, seulement 2,788 millions d'heures de GPU H800, environ 5,576 millions de dollars américains et le processus de formation est stable.

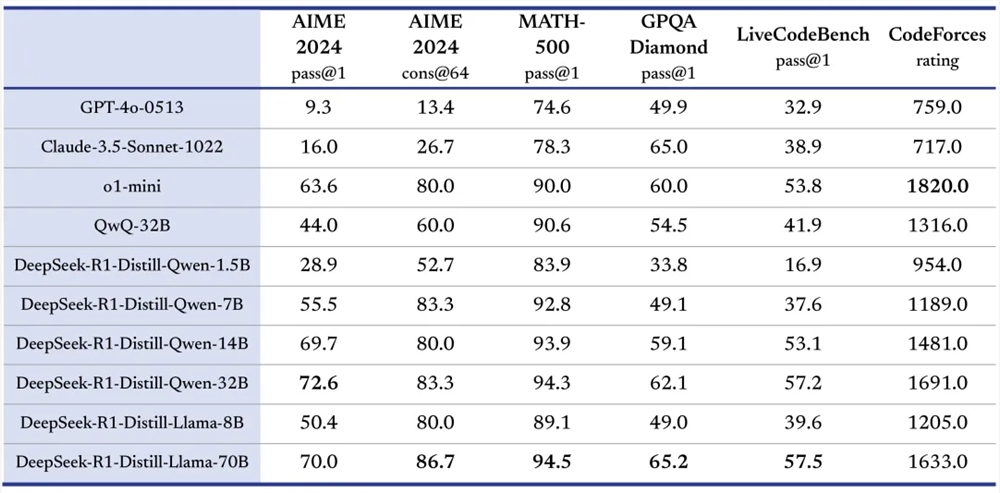

Deepseek-R1: Comprend Deepseek-R1-Zero et Deepseek-R1. Grâce à une formation d'apprentissage par renforcement à grande échelle, Deepseek-R1-Zero démontre l'auto-vérification, la réflexion et d'autres capacités grâce à une formation d'apprentissage par renforcement à grande échelle, et ne s'appuie pas sur un réglage fin supervisé (SFT), mais il y a des problèmes tels que les pauvres lisibilité et confusion linguistique. Basé sur Deepseek-R1, Deepseek-R1 présente des données de formation en plusieurs étapes et de démarrage à froid, ce qui résout certains problèmes. Dans le même temps, plusieurs modèles avec différentes échelles de paramètres ont été ouverts pour promouvoir le développement de la communauté open source.

Excellente performance: Deepseek-V3 et Deepseek-R1 ont bien fonctionné dans plusieurs repères. Par exemple, Deepseek-V3 a obtenu d'excellents résultats dans MMLU, DROP et d'autres évaluations; .

Innovation de formation:

Deepseek-V3 adopte des stratégies d'équilibrage de charges sans pertes auxiliaires et cibles de prédiction multi-tooken (MTP) pour réduire la dégradation des performances et améliorer les performances du modèle;

Deepseek-R1-Zero utilise une formation d'apprentissage en renforcement pure et s'appuyant uniquement sur des signaux de récompense et de punition simples pour optimiser le modèle, ce qui prouve que l'apprentissage du renforcement peut améliorer la capacité d'inférence du modèle; stabilité et lisibilité.

Partage open source: les modèles de la série Deepseek adhèrent au concept open source et aux poids des modèles open source, tels que Deepseek-V3 et Deepseek-R1 et leurs petits modèles distillés, permettant aux utilisateurs de former d'autres modèles par le biais de la technologie de distillation pour promouvoir la communication et l'innovation en Technologie AI.

Avantages multi-domaines: Deepseek-R1 démontre ses puissantes capacités dans plusieurs champs. et les tâches de génération.

Performances à coût élevé: l'API du modèle de la série Deepseek est abordable. Par exemple, le prix des entrées et de la production de l'API Deepseek-V3 est beaucoup plus bas que les modèles similaires;

Tâches de traitement du langage naturel: y compris la génération de texte, le système de questions et réponses, la traduction automatique, le résumé du texte, etc. Par exemple, dans un système de questions et réponses, Deepseek-R1 peut comprendre le problème et utiliser la capacité de raisonnement à donner des réponses précises;

Développement de code: aider les développeurs à écrire du code, à déboguer les programmes et à comprendre la logique du code. Par exemple, lorsque les développeurs rencontrent des problèmes de code, Deepseek-R1 peut analyser le code et fournir des solutions;

Résoudre des problèmes mathématiques: résoudre des problèmes mathématiques complexes en éducation mathématique, en recherche scientifique et autres scénarios. Comme Deepseek-R1, il fonctionne bien dans les questions liées à la compétition AIME et peut être utilisée pour aider les élèves à apprendre les mathématiques et les chercheurs dans les problèmes de mathématiques.

Recherche et développement du modèle: fournit des références et des outils pour que les chercheurs d'IA pour étudier la distillation du modèle, l'amélioration de la structure du modèle et des méthodes de formation. Les chercheurs peuvent mener des expériences basées sur le modèle open source Deepseek pour explorer de nouvelles directions technologiques.

Prise de décision auxiliaire: traiter les données et les informations et fournir des conseils décisionnels dans les domaines des affaires, des finances, etc. Par exemple, l'analyse des données du marché pour fournir des références aux entreprises pour formuler des stratégies de marketing;

Visitez la plate-forme: les utilisateurs peuvent se connecter sur le site officiel Deepseek (https://www.deepseek.com/) pour entrer sur la plate-forme.

Sélectionnez un modèle: dans le site Web officiel ou l'application, la boîte de dialogue par défaut est dictée par Deepseek-V3. Si vous êtes appelé via l'API, définissez les paramètres du modèle correspondants dans le code en fonction des exigences, tels que le réglage modèle = «Deepseek-reasoner» lors de l'utilisation de Deepseek-R1.

Tâches d'entrée: entrez des tâches décrites dans le langage naturel dans l'interface de dialogue, tel que "écrire un roman d'amour", "expliquant la fonction de ce code", "résolution d'équations mathématiques", etc. aux spécifications de l'API et ajouter les informations liées à la tâche transmises en tant que paramètres d'entrée.

Obtenez des résultats: une fois que le modèle traite la tâche, renvoie les résultats, affichez le texte généré, répondons aux questions, etc. sur l'interface;

ConclusionLes modèles de la série Deepseek ont obtenu des résultats remarquables dans le domaine de l'IA avec leurs performances exceptionnelles, leurs méthodes de formation innovantes, leur esprit de partage open source et leurs avantages rentables.

Si vous êtes intéressé par la technologie de l'IA, vous pourriez aussi bien aimer, commenter et partager vos opinions sur la série de modèles Deepseek. Dans le même temps, nous continuons à prêter attention au développement ultérieur de Deepseek, et nous attendons avec impatience pour apporter plus de surprises et de percées dans le domaine de l'IA, la promotion des progrès continus de la technologie de l'IA et apportant plus de changements et d'opportunités à diverses industries.

L'émergence de Deepseek a apporté une nouvelle vitalité et une nouvelle concurrence dans le domaine de l'intelligence artificielle, et son esprit open source est encore plus louable. À l'avenir, les modèles de la série Deepseek montreront leurs capacités puissantes dans plus de domaines, attendons et voyons!