Sakana AI lance le transformateur de modèle de langage adaptatif innovant, qui utilise un mécanisme d'ajustement de poids dynamique en deux étapes unique qui apprend et s'adapte dynamiquement aux nouvelles tâches pendant le processus d'inférence sans réglage fin coûteux. Cela marque une percée majeure dans la technologie du modèle de grande langue (LLM) et devrait changer la façon dont LLM est appliqué pour le rendre plus efficace, personnalisé et pratique. Comparé aux méthodes de réglage fin traditionnelles, le transformateur ajuste sélectivement les composants clés des poids du modèle par la décomposition de la valeur singulière (SVD) et les techniques de réglage fin de valeur singulière (SVF) pour optimiser les performances en temps réel, en évitant le retraitment de temps. Les résultats des tests montrent que Transformer² est supérieur au modèle LORA dans plusieurs tâches, avec moins de paramètres, et démontre également de solides capacités de transfert de connaissances.

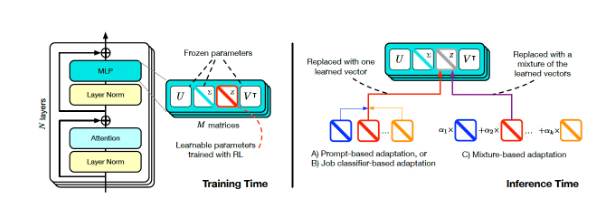

L'innovation principale de Transformer² réside dans son mécanisme de réglage du poids dynamique unique en deux étapes. Tout d'abord, il analyse les demandes des utilisateurs entrants et comprend les exigences de la tâche; ensuite, par le biais de techniques mathématiques, la décomposition de la valeur singulière (SVD) pour aligner les poids des modèles avec les exigences de la tâche. En ajustant sélectivement les composants clés des poids du modèle, Transformer² permet l'optimisation en temps réel des performances sans recyclage qui prend du temps. Ceci contraste fortement avec la méthode de réglage fin traditionnelle, qui nécessite de garder les paramètres statiques après l'entraînement, ou en utilisant des méthodes telles que l'adaptation de faible rang (LORA) pour modifier seulement un petit nombre de paramètres.

Formation et inférence du transformateur (Source: ArXIV)

Pour atteindre un ajustement dynamique, les chercheurs ont adopté la méthode de réglage de la valeur singulière (SVF). Pendant la formation, SVF apprend un ensemble de représentations de compétences appelées Vectors Z des composantes SVD du modèle. Lors du raisonnement, Transformer² détermine les compétences requises en analysant les invites, puis en configurant les vecteurs Z correspondants pour obtenir une réponse adaptée à chaque invite.

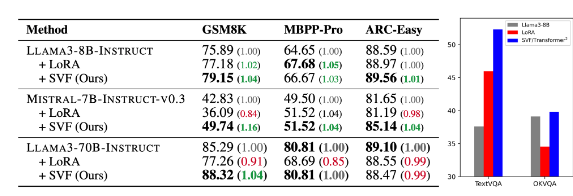

Les résultats des tests montrent que Transformer² est supérieur au modèle LORA dans diverses tâches telles que les mathématiques, le codage, le raisonnement et la question et la réponse visuelles, et a moins de paramètres. Plus remarquable est que le modèle a également la capacité de transfert de connaissances, c'est-à-dire que les vecteurs Z appris d'un modèle peuvent être appliqués à un autre, démontrant ainsi le potentiel d'application généralisée.

Comparaison du transformateur-carré (SVF dans le tableau) avec le modèle sous-jacent et LORA (source: arXIV)

Sakana AI a publié le code de formation pour le composant Transformer² sur sa page GitHub, ouvrant la porte à d'autres chercheurs et développeurs.

Alors que les entreprises continuent d'explorer l'application de LLM, la technologie de personnalisation d'inférence devient progressivement la tendance traditionnelle. Transformer², ainsi que d'autres technologies telles que les Titans de Google, modifie la façon dont LLM est utilisé, permettant aux utilisateurs d'ajuster dynamiquement les modèles à leurs besoins spécifiques sans recyclage. Cette progression technologique rendra LLM plus utile et pratique dans un plus large éventail de domaines.

Des chercheurs de Sakana AI ont déclaré que Transformer² représente un pont entre l'intelligence artificielle statique et l'intelligence de la vie, jetant les bases d'outils d'IA efficaces, personnalisés et entièrement intégrés.

La sortie open source de Transformer² favorisera considérablement le développement et l'application de la technologie LLM et fournira une nouvelle direction pour construire des systèmes d'intelligence artificielle plus efficaces et personnalisés. Sa capacité à apprendre dynamiquement et à s'adapter aux nouvelles tâches le fait avoir un énorme potentiel d'application dans divers domaines et vaut la peine d'être attendu au développement futur.