L'Allen Institute of Artificial Intelligence (AI2) a récemment publié un nouveau modèle de langue à grande échelle OLMOE, un modèle d'expert hybride clairsemé (MOE) avec 7 milliards de paramètres, mais chaque marque d'entrée utilise seulement 1 milliard de paramètres, ce qui réduit considérablement le nombre d'inférence Coûts et exigences de mémoire. Olmoe a deux versions: la version universelle OLMOE-1B-7B et la version de réglage fin de l'instruction OLMOE-1B-7B-INSTRUCT, qui ne fait pas moins que les autres grands modèles dans les références, et dépasse même certains modèles plus grands. AI2 met l'accent sur l'open source complète d'Olmoe, qui est particulièrement précieuse dans le domaine des modèles MOE et fournit des ressources précieuses pour la recherche académique.

Olmoe adopte une architecture d'experts hybrides clairsemée (MOE) avec 7 milliards de paramètres, mais seulement 1 milliard de paramètres sont utilisés par balise d'entrée. Il est disponible en deux versions, le plus général OLMOE-1B-7B et l'OLMOE-1B-7B-INSTRUCT étiqueté par l'instruction.

Contrairement à la plupart des autres modèles d'experts hybrides qui sont à source fermée, AI2 souligne que Olmoe est complètement open source. Ils ont mentionné dans le document que "la plupart des modèles MOE sont des sources fermées: bien que certains poids de modèle divulguent, il y a des informations extrêmement limitées sur leurs données de formation, leur code ou leurs recettes." Cela empêche de nombreux chercheurs universitaires d'accéder à ces modèles.

Le chercheur AI2, Nathan Lambert, a déclaré sur les réseaux sociaux qu'Olmoe aidera à l'élaboration des politiques, ce qui pourrait fournir un point de départ pour le lancement du cluster H100 dans le monde universitaire. Il a également mentionné que la sortie du modèle OLMOE fait partie de l'objectif d'AI2 de développer des modèles open source et de rendre ses performances comparables aux modèles fermés.

En termes de construction de modèles, AI2 a décidé d'utiliser 64 petits experts pour le routage fin et d'activer seulement huit d'entre eux lors de l'exécution. Les expériences montrent que Olmoe est comparable à d'autres modèles de performance, mais est considérablement réduit en matière de coût d'inférence et de stockage de la mémoire. Olmoe s'appuie également sur le modèle open source OLMO1.7-7B avant AI2, prenant en charge 4096 Tagged Context Windows. Les données de formation OLMOE proviennent de plusieurs sources, notamment la rampe commune, le Dolma CC, le Wikipedia, etc.

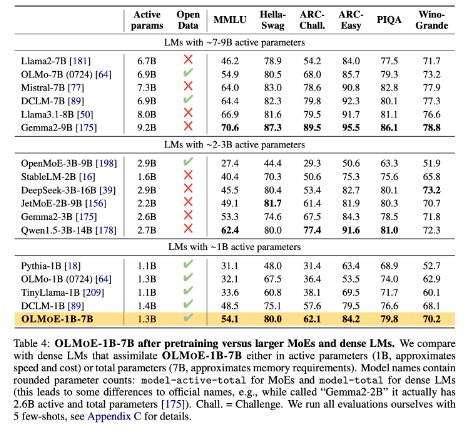

Dans l'indice de référence, OLMOE-1B-7B surpasse de nombreux modèles existants par rapport à des modèles à paramètres similaires, et dépasse même les modèles plus grands tels que LLAMA2-13B-CHAT et Deepseekmoe-16b.

L'un des objectifs de l'AI2 est de fournir aux chercheurs des modèles d'IA plus open source, y compris des architectures d'experts hybrides. Bien que de nombreux développeurs utilisent l'architecture MOE, AI2 estime que la plupart des autres modèles d'IA sont loin d'être suffisamment ouverts.

Huggingface: https://huggingface.co/collections/allenai/olmoe-66cf678c047657a30c8cd3da

Entrée du papier: https://arxiv.org/abs/2409.02060

Points clés:

- Le nouveau modèle open source OLMOE publié par AI2 est compétitif en termes de performances et de coûts.

- Olmoe adopte une architecture d'experts hybrides clairsemée qui peut réduire efficacement les coûts d'inférence et les exigences de mémoire.

- L'AI2 s'engage à fournir un modèle d'IA entièrement open source qui favorise la recherche et le développement académiques.

En bref, la sortie open source d'Olmoe est une progression majeure dans le domaine des modèles de langage à grande échelle. La décision de l'AI2 reflète son engagement ferme à l'élaboration de l'IA open source et vaut la peine d'être attendue à des contributions plus similaires à l'avenir.