Ces dernières années, le coût de formation des modèles de gros langues est resté élevé, ce qui est devenu un facteur important restreignant le développement de l'IA. Comment réduire les coûts de formation et améliorer l'efficacité est devenu l'attention de l'attention de l'industrie. Des chercheurs de Harvard et de l'Université de Stanford ont adopté une approche différente et ont commencé avec la précision de la formation des modèles pour explorer une méthode de formation rentable. Ils ont constaté qu'en réduisant la précision du modèle, la quantité de calcul peut être efficacement réduite et même améliorée les performances du modèle dans certains cas. Cette étude fournit de nouvelles idées pour optimiser la formation du modèle de langue et souligne également la direction du développement futur de l'IA.

Dans le domaine de l'intelligence artificielle, plus l'échelle est grande, plus la capacité est forte. Afin de poursuivre un modèle linguistique plus puissant, les grandes sociétés technologiques sont des paramètres de modèle et des données de formation, mais ils constatent que le coût a également augmenté. N'y a-t-il pas un moyen rentable et efficace de former des modèles de langue?

Des chercheurs de Harvard et de l'Université de Stanford ont récemment publié un document qu'ils ont constaté que la précision de la formation des modèles est comme une clé cachée qui débloque le "mot de passe coûteux" de la formation du modèle linguistique.

Quelle est la précision du modèle? Les modèles traditionnels d'apprentissage en profondeur sont généralement formés à l'aide de numéros de points flottants 32 bits (FP32), mais ces dernières années, avec le développement du matériel, utilisent des types numériques de précision inférieurs, tels que les numéros de points flottants 16 bits (FP16) ou 8 bits La formation des entiers (INT8) est devenue possible.

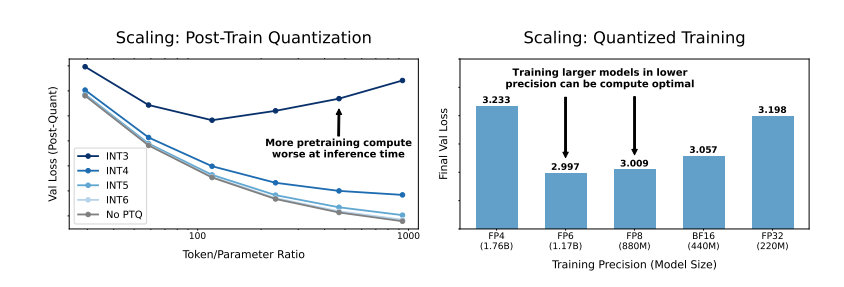

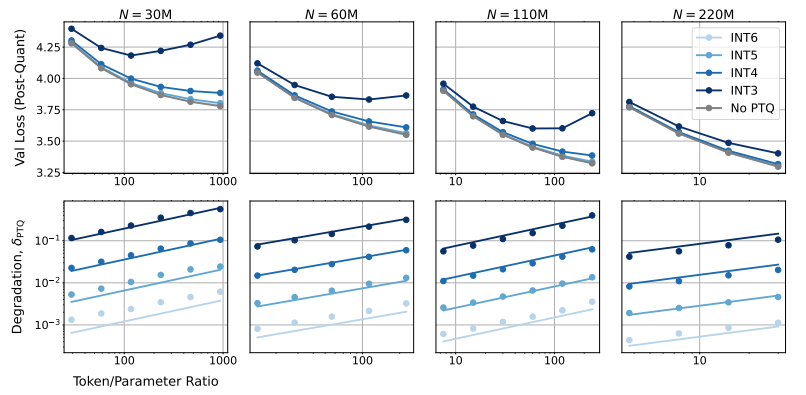

Donc, quel impact réduira la précision du modèle sur les performances du modèle? Grâce à un grand nombre d'expériences, les chercheurs ont analysé les changements de coût et de performance de la formation et de l'inférence des modèles à une précision différente, et ont proposé un nouvel ensemble de règles de mise à l'échelle de la "perception de précision".

Ils ont constaté que l'entraînement avec une précision plus faible peut réduire efficacement le "nombre de paramètres efficaces" du modèle, réduisant ainsi la quantité de calcul requise pour la formation. Cela signifie que dans le même budget de calcul, nous pouvons former des modèles plus importants, ou à la même échelle, l'utilisation d'une précision inférieure peut économiser de nombreuses ressources informatiques.

Encore plus surprenant, les chercheurs ont également constaté que dans certains cas, la formation avec une précision inférieure peut réellement améliorer les performances du modèle! Phase, le modèle sera plus robuste à la réduction de la précision de la quantification, montrant ainsi de meilleures performances dans la phase d'inférence.

Alors, quelle précision devons-nous choisir pour former le modèle?

La formation de précision traditionnelle 16 bits peut ne pas être le meilleur choix. Leurs recherches montrent que la précision 7-8 bits peut être une option plus rentable.

Ce n'est pas une décision sage de suivre une formation de précision ultra-bas (comme 4 bits). Parce qu'à une précision extrêmement faible, le nombre de paramètres efficaces du modèle baissera fortement, afin de maintenir les performances, nous devons augmenter considérablement la taille du modèle, ce qui entraînera des coûts informatiques plus élevés.

La précision de formation optimale peut varier pour des modèles de différentes tailles. Pour les modèles qui nécessitent beaucoup de "surentraînement", comme la série LLAMA-3 et GEMMA-2, la formation avec une précision plus élevée peut être plus rentable.

Cette étude offre une toute nouvelle perspective pour que nous puissions comprendre et optimiser la formation du modèle de langue. Il nous dit que le choix de la précision n'est pas statique, mais doit être échangé en fonction de la taille spécifique du modèle, du volume de données de formation et des scénarios d'application.

Bien sûr, cette étude a également certaines limites. Par exemple, le modèle qu'ils utilisent est de taille relativement petite et les résultats expérimentaux peuvent ne pas être directement généralisés à des modèles plus grands. En outre, ils ne se sont concentrés que sur la fonction de perte du modèle et n'ont pas évalué les performances du modèle sur les tâches en aval.

Néanmoins, cette étude est d'une grande importance. Il révèle la relation complexe entre la précision du modèle et les performances du modèle et les coûts de formation, et fournit des informations précieuses pour nous de concevoir et de former des modèles de langage plus forts et plus économiques à l'avenir.

Papier: https://arxiv.org/pdf/2411.04330

En bref, cette étude fournit de nouvelles idées et méthodes pour réduire les coûts de formation des modèles de langue importants et offre une valeur de référence importante pour le développement futur du domaine de l'intelligence artificielle. Bien qu'il existe certaines limites dans la recherche, la règle de mise à l'échelle de la «perception de précision» qu'elle propose et la discussion approfondie de la relation entre la précision du modèle et le coût et la performance ont une signification directrice théorique et pratique importante.