L'équipe de Shanghai AI Lab a ouvert la source de la version LLAMA du projet O1, qui est un projet de réplique open source pour l'outil de résolution de problèmes Olympiad Openai O1. Le projet utilise des technologies avancées telles que la recherche de Monte Carlo Tree et l'apprentissage du renforcement pour obtenir des résultats remarquables en répondant aux questions d'Olympiade mathématiques, et sa performance dépasse même celle de certaines solutions commerciales de source fermée. L'open source du projet fournit aux développeurs des précieuses ressources d'apprentissage et des Fondations de recherche et promeut également le développement ultérieur de l'application de l'intelligence artificielle dans le domaine des mathématiques. Ce projet comprend des ensembles de données pré-formés, des modèles pré-formés et des codes de formation d'apprentissage par renforcement, etc., et utilise une variété de technologies d'optimisation, notamment LORA et PPO, visant à améliorer la capacité du modèle dans le raisonnement mathématique.

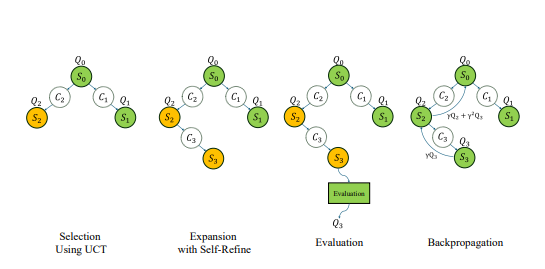

Récemment, l'équipe de Shanghai AI Lab a publié la version LLAMA du projet O1, visant à reproduire l'outil de résolution de problèmes d'Olympiad d'Openai O1. Le projet adopte une variété de technologies avancées, notamment la recherche de Monte Carlo Tree, l'apprentissage par le renforcement de l'auto-play, le paradigme de la double stratégie d'Alphago Zero, qui a attiré une attention généralisée de la communauté des développeurs.

Bien avant la sortie de la série O1 d'Openai, l'équipe de Shanghai AI Lab a commencé à explorer l'utilisation de la recherche de Monte Carlo Tree pour améliorer la capacité mathématique des grands modèles. Après la sortie de O1, l'équipe a encore amélioré l'algorithme, axée sur le problème de l'Olympiade en mathématiques et l'a développée en tant que version open source du projet Openai Strawberry.

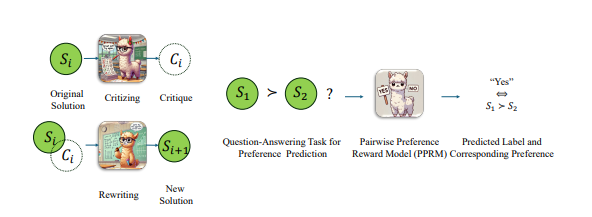

Afin d'améliorer les performances du modèle LLAMA dans les problèmes d'Olympiades mathématiques, l'équipe a adopté une stratégie d'optimisation appariée, qui ne donne pas directement le score absolu de la réponse, mais comparez plutôt les avantages et les inconvénients relatifs des deux réponses. Avec cette approche, ils ont fait des progrès significatifs dans les repères AIME2024 les plus difficiles. Parmi les 30 questions de test, le modèle optimisé a été effectué correctement 8, tandis que le modèle d'origine LLAMA-3.1-8B-Istruct a été effectué correctement 2. Cette réalisation surpasse les autres solutions commerciales de source fermée en plus de O1-Preview et O1-MinI.

Fin octobre, l'équipe a annoncé des progrès significatifs dans la réplication de l'Openai O1 sur la base de l'architecture Alphago Zero, permettant avec succès au modèle d'obtenir une capacité de réflexion avancée par l'interaction avec l'arbre de recherche pendant le processus d'apprentissage sans annotation manuelle. En moins d'une semaine, le projet a été ouvert.

À l'heure actuelle, le contenu open source de la version LLAMA O1 comprend: les ensembles de données pré-formés, les modèles pré-formés et le code de formation d'apprentissage par renforcement. Parmi eux, l'ensemble de données "OpenLongCot-Pretrain" contient plus de 100 000 données de chaîne de réflexion longues, chaque données contient un processus complet de raisonnement de problème mathématique, y compris le contenu de réflexion, les résultats de notation, la description du problème, les coordonnées de graphiques, le processus de calcul, la déduction de conclusion et d'autres Les liens d'inférence complets, ainsi que la critique et la vérification de chaque étape d'inférence, fournissent une évaluation et des conseils pour le processus d'inférence. Après avoir continué de pré-formation sur cet ensemble de données, le modèle peut lire et sortir des processus de chaîne de réflexion longue comme O1.

Bien que le projet s'appelle LLAMA-O1, le modèle pré-formé actuellement fourni par le fonctionnaire est basé sur GEMMA2 de Google. Sur la base du modèle pré-formé, les développeurs peuvent continuer à effectuer une formation d'apprentissage par renforcement. Le processus de formation comprend: l'utilisation de la recherche de monte Carlo pour le jeu pour générer de l'expérience; Certaines technologies clés sont également utilisées dans le code de formation, notamment en utilisant LORA pour un réglage de paramètres efficace, en utilisant l'algorithme PPO comme méthode d'optimisation de stratégie, en mettant en œuvre un algorithme GAE pour calculer les fonctions avantageuses et en utilisant la lecture de l'expérience prioritaire pour améliorer l'efficacité de la formation.

Il convient de noter que le code LLAMA-O1 a été publié sous le compte GitHub appelé Simpleberry. D'après d'autres comptes liés à SimpleBerry et les informations officielles sur le site Web, on ne peut voir que sa nature est un laboratoire de recherche, mais aucune information plus d'informations sur la direction de la recherche n'est divulguée.

En plus de LLAMA-O1, un autre projet de réplique O1 progressé est un Journey O1 de l'équipe de l'Université de Shanghai Jiaotong. L'équipe a publié son premier rapport de progression début octobre, présentant le paradigme innovant du voyage d'apprentissage et le premier modèle à intégrer avec succès la recherche et l'apprentissage dans le raisonnement mathématique. L'équipe de développement de base O1-Journey est principalement composée de étudiants de premier cycle junior et senior à l'Université de Shanghai Jiaotong, ainsi que des doctorants de première année du Gair Laboratory (Laboratoire général de recherche sur l'intelligence artificielle). à l'Université de Shanghai Jiaotong.

Adresse papier: https://arxiv.org/pdf/2410.02884

https://arxiv.org/pdf/2406.07394

L'open source du projet LLAMA Version O1 marque des progrès importants dans le domaine de la résolution de problèmes mathématiques de l'IA et fournit également une base solide pour de nouvelles recherches et applications. Nous attendons avec impatience des réalisations plus innovantes basées sur ce projet à l'avenir.