US Startup Utile Sensors a publié un modèle de reconnaissance vocale open source appelée Moonshine, visant à améliorer l'efficacité du traitement des données audio. Par rapport au chuchotement d'Openai, Moonshine est plus économique dans les ressources informatiques et a augmenté la vitesse de traitement de cinq fois, en particulier pour le matériel limité aux ressources et les applications en temps réel. Son architecture flexible et son ajustement dynamique du temps de traitement en fonction de la longueur audio le rendent en suspens lors du traitement des clips audio courts et réduisent efficacement les frais généraux de traitement. Moonshine fournit deux versions, minuscules et de base, avec des paramètres de 27,1 millions et 61,5 millions, respectivement, tous deux meilleurs que les performances de modèles similaires dans l'utilisation des ressources.

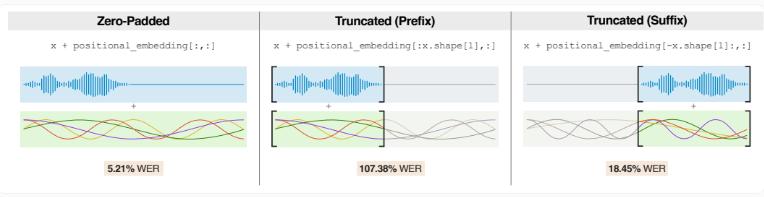

Contrairement à Whisper qui divise l'audio en clips fixes de 30 secondes, Moonshine ajuste le temps de traitement en fonction de la longueur audio réelle. Cela le fait bien fonctionner lors de la gestion des clips audio plus courts, en réduisant la surcharge de traitement en raison d'un rembourrage zéro.

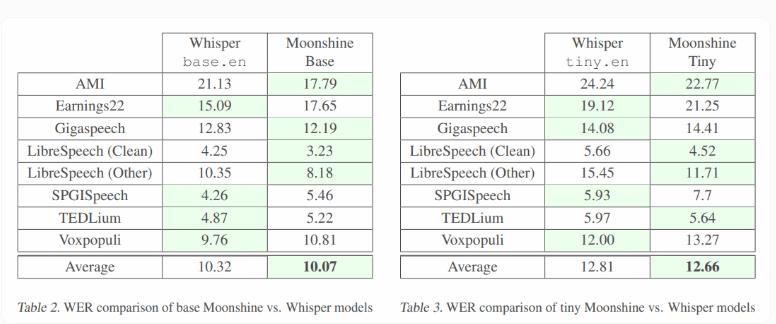

Moonshine a deux versions: la petite version minuscule a un volume de paramètres de 27,1 millions, et la grande version de base a un volume de paramètres de 61,5 millions. En revanche, les paramètres du modèle similaires d'Openai sont plus grands, Whisper Tiny.En étant de 37,8 millions et de la base, étant de 72,6 millions.

Les résultats des tests montrent que le minuscule modèle de Moonshine est comparable au murmure en termes de précision et consomme moins de ressources informatiques. Les deux versions de Moonshine sont inférieures à celles de chuchotement dans le taux d'erreur des mots (WER) pour divers niveaux audio et un bruit de fond, montrant de fortes performances.

L'équipe de recherche a souligné que Moonshine a toujours une place à l'amélioration lors du traitement des puces audio extrêmement courtes (moins d'une seconde). Ces courts audios représentent une petite proportion de données de formation, et l'augmentation de la formation de ces clips audio peut améliorer les performances du modèle.

De plus, les capacités hors ligne de Moonshine ouvrent de nouveaux scénarios d'application, et les applications qui étaient auparavant indisponibles en raison des limitations matérielles sont désormais possibles. Contrairement à Whisper, qui nécessite une consommation d'énergie plus élevée, Moonshine convient pour fonctionner sur les smartphones et les petits appareils tels que Raspberry Pi. Les capteurs utiles utilisent Moonshine pour développer son traducteur espagnole anglais Torre.

Le code de Moonshine a été publié sur GitHub, et les utilisateurs doivent noter que les systèmes de transcription AI comme Whisper peuvent ressentir des erreurs. Certaines études ont montré que Whisper a 1,4% de chances de fausses informations lors de la génération de contenu, en particulier pour les personnes ayant des barrières linguistiques, avec des taux d'erreur plus élevés.

Entrée du projet: https://github.com/usefulsensors/moonshine

Points clés:

Moonshine est un modèle de reconnaissance vocale open source qui traite cinq fois plus vite que le murmure d'Openai.

Ce modèle peut ajuster le temps de traitement en fonction de la longueur audio, particulièrement adapté aux clips audio courts.

Moonshine prend en charge le fonctionnement hors ligne et convient à une utilisation avec des ressources limitées.

En bref, Moonshine apporte de nouvelles possibilités à la technologie de reconnaissance vocale avec sa vitesse de traitement efficace, son architecture flexible et sa faible demande de ressources, en particulier dans les appareils limitées en ressources et les scénarios d'application en temps réel. Ses fonctionnalités open source facilitent également les développeurs pour s'améliorer et s'appliquer, et valent la peine d'être prêts à prêter attention et d'attendre avec impatience.