Hugging Face a lancé un nouveau modèle de langue compacte, SmollM2, qui est une percée passionnante. SMOLLM2 a trois versions de taille de paramètres différentes qui offrent des performances puissantes même sur les appareils liés aux ressources, ce qui est d'une grande importance pour les applications de calcul Edge et de périphériques mobiles. Il excelle dans plusieurs repères, dépassant des modèles similaires, démontrant ses avantages dans le raisonnement scientifique et les tâches de bon sens. La licence Open Source et Apache 2.0 de SMOLLM2 facilite également l'accès et la demande.

Hugging Face aujourd'hui a publié SmollM2, un nouvel ensemble de modèles de langage compacts qui obtiennent des performances impressionnantes tout en nécessitant beaucoup moins de ressources informatiques que les grands modèles. Le nouveau modèle est publié sous la licence Apache 2.0 et se présente en trois tailles - 135m, 360m et 1,7b de paramètres - adapté au déploiement sur les smartphones et autres périphériques de bord avec une puissance de traitement et une mémoire limités.

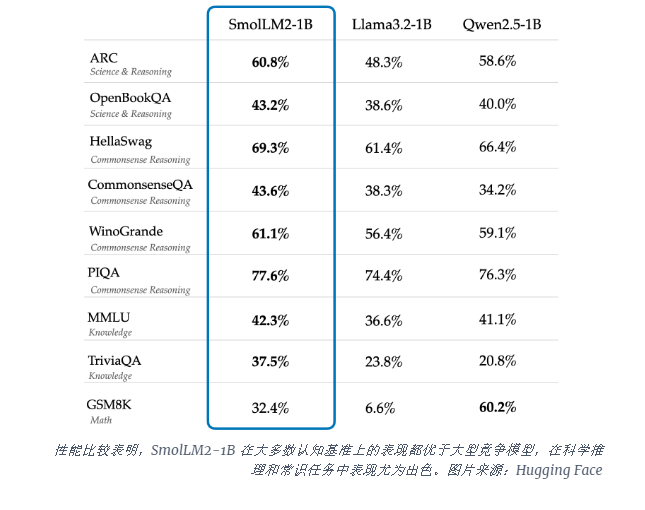

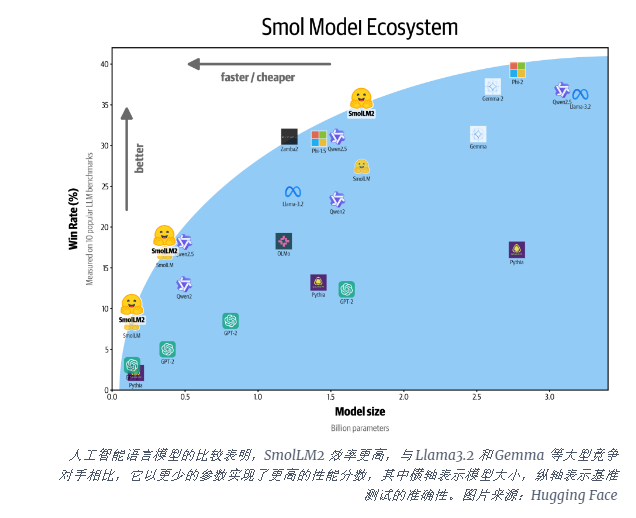

Le modèle SMOLLM2-1B surpasse le modèle Meta Llama1b dans plusieurs repères clés, en particulier dans les tâches de raisonnement scientifique et de bon sens. Ce modèle surpasse les grands modèles concurrents sur la plupart des références cognitives, en utilisant une combinaison diversifiée d'ensembles de données, notamment Fineweb-edu et des ensembles de données mathématiques et codants spécialisés.

Le lancement de SMOLLM2 arrive à un moment critique où l'industrie de l'IA a du mal à faire face aux besoins informatiques pour exécuter de grands modèles de langage (LLM). Alors que des entreprises comme Openai et Anthropic continuent de repousser les limites de la taille du modèle, il y a une reconnaissance croissante du besoin d'une IA efficace et légère qui peut fonctionner localement sur les appareils.

SMOLLM2 offre une approche différente pour apporter des capacités d'IA puissantes directement aux appareils personnels, pointant vers l'avenir où davantage d'utilisateurs et d'entreprises peuvent utiliser des outils d'IA avancés, pas seulement des géants technologiques avec d'énormes centres de données. Ces modèles prennent en charge une gamme d'applications, y compris les réécritures de texte, le résumé et les appels de fonction, adaptés au déploiement dans des scénarios où les restrictions de confidentialité, de latence ou de connexion rendent les solutions d'IA basées sur le cloud impraticables.

Bien que ces modèles plus petits aient encore des limites, ils représentent une partie d'une large tendance dans les modèles d'IA plus efficaces. La sortie de SMOLLM2 montre que l'avenir de l'intelligence artificielle peut non seulement appartenir à des modèles plus grands, mais à des architectures plus efficaces qui peuvent fournir des performances puissantes avec moins de ressources.

L'émergence de SMOLLM2 a ouvert de nouvelles possibilités pour les applications d'IA légères, ce qui indique que la technologie d'IA sera plus largement utilisée dans divers appareils et scénarios, offrant aux utilisateurs une expérience plus pratique et efficace. Ses fonctionnalités open source ont également favorisé le développement et l'innovation de la communauté de l'IA. À l'avenir, nous devons voir des modèles d'IA plus efficaces et compacts émerger, favorisant la vulgarisation et l'avancement des technologies d'IA.