Les équipes de recherche de Meta Fair, UC Berkeley et de l'Université de New York ont collaboré au développement d'une nouvelle technologie appelée Thinking Préférences Optimization (TPO) pour améliorer considérablement la conformité des instructions et la qualité de la réponse dans les modèles de grands langues (LLM). Contrairement aux LLM traditionnelles qui donnent des réponses directement, la technologie TPO permet aux modèles de penser et de réfléchir en interne avant de répondre, générant ainsi des réponses plus précises et cohérentes. Cette innovation guide le modèle pour optimiser son processus de réflexion sans montrer à l'utilisateur les étapes intermédiaires, améliorant finalement la qualité des réponses grâce à une méthode de raisonnement de réflexion en chaîne améliorée (COT).

Le noyau de la technologie TPO est la méthode de raisonnement en chaîne améliorée (COT). Cette approche encourage les modèles à «penser et répondre» pendant la formation, en les aidant à construire un processus de réflexion intérieure plus organisé avant de fournir la réponse finale. Les signaux de lit de lit traditionnels peuvent parfois conduire à une précision réduite et sont assez difficiles à s'entraîner en raison du manque de pas de réflexion claire. Et TPO surmonte avec succès ces défis en permettant aux modèles d'optimiser et de simplifier leur processus de réflexion sans exposer des étapes intermédiaires aux utilisateurs.

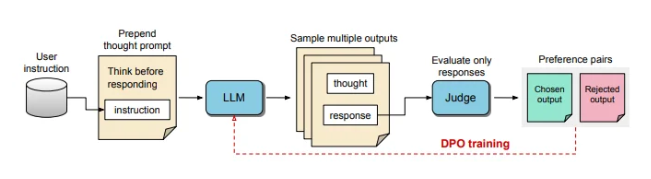

Pendant le processus de formation TPO, invitez d'abord le modèle grand langage à générer plusieurs idées, puis à trier la réponse finale. Ces sorties sont ensuite évaluées par un modèle "Judge" pour choisir les réponses les plus performantes et les plus performantes. Ces résultats d'évaluation sont utilisés comme paires de «choix» et «rejeter» pour l'optimisation directe des préférences (DPO) pour améliorer en continu la qualité de réponse du modèle.

En ajustant les invites de formation, TPO encourage le modèle à penser en interne avant de répondre. Ce processus guide le modèle pour optimiser ses réponses pour le rendre plus clair et plus pertinent. En fin de compte, l'évaluation est effectuée par un modèle de jugement basé sur LLM qui ne marque que la réponse finale, aidant ainsi le modèle à améliorer la qualité des réponses indépendamment des étapes de pensée cachées. TPO utilise également une optimisation directe des préférences pour créer des réponses préférées et de rejet qui contiennent une pensée cachée, et après plusieurs cycles de formation, affinez davantage le processus interne du modèle.

Dans les références pour l'alpacaval et l'arène dure, la méthode TPO a surpassé la ligne de base traditionnelle de réponse et était meilleure que le modèle LLAMA-3-8B-Istruct des "conseils de réflexion". La formation itérative de cette méthode optimise les capacités de génération de réflexion, dépassant finalement plusieurs modèles de référence. Il convient de mentionner que le TPO convient non seulement aux tâches logiques et mathématiques, mais fait également de grands efforts dans des domaines créatifs tels que les instructions de marketing et de santé pour suivre les tâches.

L'IA et l'expert en robotique Karan Verma ont partagé son point de vue sur le concept de "Thinking LLM" sur la plate-forme sociale X, disant qu'il était très excité à ce sujet et attendait avec impatience le potentiel de cette innovation dans les applications médicales qui peuvent amener plus de patients. .

Ce processus de réflexion interne structuré permet au modèle de traiter plus efficacement les instructions complexes, élargissant davantage son application dans des domaines qui nécessitent un raisonnement à plusieurs niveaux et une compréhension méticuleuse sans avoir besoin pour les humains de fournir des données de réflexion spécifiques. Cette étude montre que le TPO a le potentiel de rendre les modèles de langue importants plus flexibles et efficaces dans divers contextes, adaptés aux zones où il existe des exigences élevées pour la flexibilité et la profondeur de la génération de réponse.

Les progrès révolutionnaires de la technologie TPO ont apporté des capacités plus fortes d'inférence et de compréhension aux modèles de langue importants, ouvrant de nouvelles possibilités pour leur application dans divers domaines, en particulier dans les tâches qui nécessitent des processus de réflexion complexes.