Meta AI, en collaboration avec des chercheurs de l'Université de Californie, de Berkeley et de l'Université de New York, a développé une nouvelle approche appelée Thinking Préférence Optimization (TPO) qui vise à améliorer considérablement la qualité de réponse des modèles de grande langue (LLM). Contrairement aux méthodes traditionnelles qui se concentrent uniquement sur la réponse finale, TPO permet au modèle de penser en interne avant de générer la réponse, ce qui entraîne une réponse plus précise et cohérente. Cette méthode de raisonnement de la chaîne de réflexion (COT) améliorée sur la technologie surmonte les lacunes de la faible précision de la méthode de COT et la difficulté de formation de la méthode précédente par l'optimisation et la rationalisation du processus de réflexion interne du modèle, et génére finalement des réponses de meilleure qualité et à bien des égards. Chaque test de référence.

Contrairement aux modèles traditionnels qui se concentrent uniquement sur la réponse finale, la méthode TPO permet au modèle de penser en interne avant de générer une réponse, entraînant des réponses plus précises et cohérentes.

Cette nouvelle technologie combine une méthode de raisonnement à la chaîne de réflexion (COT) améliorée. Pendant le processus de formation, la méthode encourage le modèle à «penser» avant de répondre, l'aidant à créer un processus de réflexion interne plus systématique. Les invites à COT direct précédentes réduisent parfois la précision, et le processus de formation est difficile en raison du manque d'étapes claires de réflexion. TPO surmonte ces limites en permettant au modèle d'optimiser et de rationaliser son processus de réflexion, et ne montre pas d'étapes de réflexion intermédiaires devant l'utilisateur.

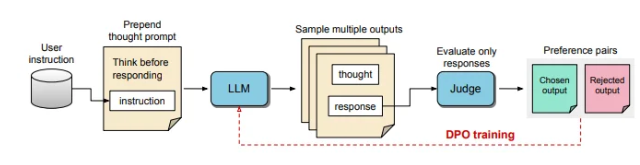

Dans le processus de TPO, les modèles de grandes langues sont d'abord invités à générer plusieurs processus de réflexion, puis ces sorties sont échantillonnées et évaluées avant de former la réponse finale. Un modèle d'évaluation marquera ensuite la sortie pour déterminer les réponses optimales et les pires. En utilisant ces sorties comme choix et rejet pour l'optimisation directe des préférences (DPO), cette méthode de formation itérative améliore la capacité du modèle à générer des réponses plus pertinentes et de haute qualité, améliorant ainsi les résultats globaux.

Dans cette méthode, les invites de formation sont ajustées, encourageant le modèle à penser en interne avant de répondre. La réponse finale évaluée est notée par un modèle d'évaluation basé sur LLM, qui permet au modèle d'améliorer la qualité en fonction de l'efficacité de la réponse sans considérer les étapes de réflexion implicites. De plus, TPO utilise une optimisation directe des préférences pour créer des réponses de préférence et de rejet qui contiennent une réflexion implicite, et affine davantage le processus interne du modèle à travers plusieurs cycles d'entraînement.

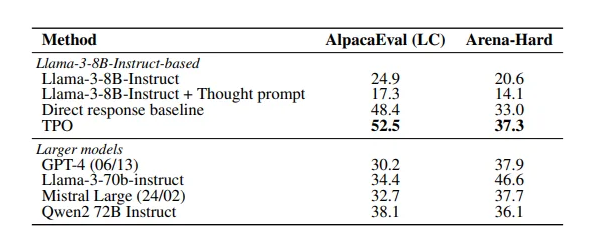

Les résultats de l'étude montrent que la méthode TPO a bien fonctionné dans plusieurs repères, dépassant une variété de modèles existants. Cette approche s'applique non seulement aux tâches logiques et mathématiques, mais montre également un potentiel dans des domaines créatifs tels que les tâches de suivi des commandes de marketing et de santé.

Papier: https://arxiv.org/pdf/2410.10630

Points clés:

La technologie TPO améliore la capacité de réflexion des grands modèles de langage avant de générer des réponses, garantissant que les réponses sont plus précises.

Grâce au raisonnement de la chaîne de réflexion amélioré, le modèle peut optimiser et rationaliser son processus de pensée interne et améliorer la qualité de la réponse.

TPO convient à une variété de domaines, non seulement pour les tâches logiques et mathématiques, mais aussi pour la création et la santé.

En bref, la méthode TPO fournit une nouvelle idée pour l'amélioration des performances des modèles de gros langues. Les liens papier sont pratiques pour les lecteurs afin de mieux comprendre ses détails techniques et ses résultats expérimentaux.