La formation et l'optimisation des modèles de grands langues (LLM) sont des défis clés dans le domaine de l'intelligence artificielle. Des méthodes de formation efficaces et un modèle de modèle conforme aux valeurs humaines sont cruciaux. L'apprentissage du renforcement et la rétroaction humaine (RLHF) est une méthode de formation LLM traditionnelle. À cette fin, l'équipe ByTedance Doubao Big Model a ouvert le cadre RLHF appelé HybridFlow, visant à résoudre ces problèmes et à apporter de nouvelles possibilités à la formation LLM. Grâce à une conception innovante, ce cadre améliore l'efficacité et la flexibilité de la formation LLM.

Les grands modèles (LLM) tels que GPT et LLAMA ont déclenché une révolution dans le domaine de l'intelligence artificielle, mais comment former efficacement ces énormes modèles et les rendre conformes aux valeurs humaines reste un problème difficile.

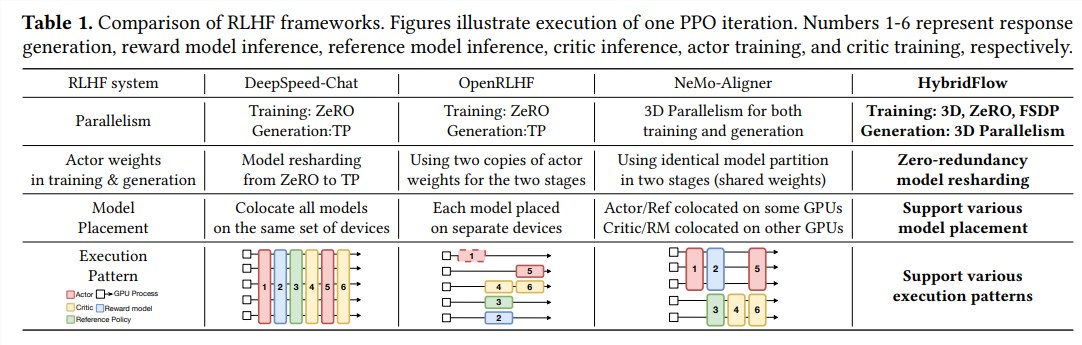

L'apprentissage du renforcement et la rétroaction humaine (RLHF) ont été largement utilisés ces dernières années comme une méthode de formation LLM importante, mais le cadre traditionnel du RLHF a des limites de flexibilité, d'efficacité et d'évolutivité.

Pour résoudre ces problèmes, ByTedance Doubao Big Model Team Open Source Le cadre RLHF appelé HybridFlow, apportant de nouvelles possibilités à la formation LLM.

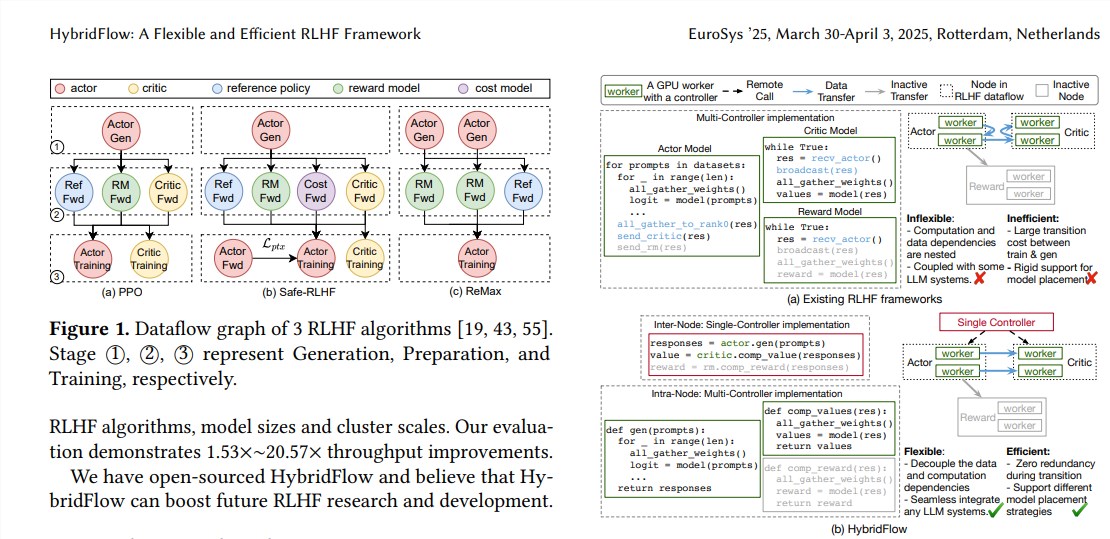

RLHF se compose généralement de trois étapes:

Tout d'abord, le modèle d'acteur génère du texte basé sur les invites d'entrée; Ensuite, le modèle critique, le modèle de référence et le modèle de récompense évaluent le texte généré et calcule la valeur correspondante, la probabilité de référence et la valeur de récompense;

Enfin, ces résultats d'évaluation sont utilisés pour former le modèle d'acteur pour générer du texte plus conforme aux préférences humaines. Les cadres RLHF traditionnels utilisent généralement un seul contrôleur pour gérer l'ensemble du flux de données, mais cela est inefficace pour les LLM qui nécessitent un calcul distribué.

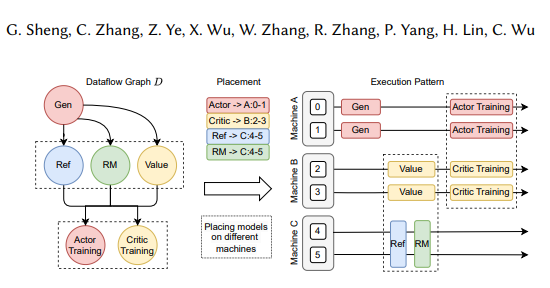

Le cadre HybridFlow combine de manière innovante les modes uniques et multi-contrôles et les découpages complexes complexes et dépendances des données grâce à la conception hiérarchique des API, permettant une représentation flexible et une exécution efficace des flux de données RLHF.

Les avantages de Hybridflow se reflètent principalement dans les trois aspects suivants:

Prise en charge flexible pour une variété d'algorithmes et de modèles RLHF: HybridFlow fournit une API modulaire, où les utilisateurs peuvent facilement implémenter et étendre divers algorithmes RLHF, tels que PPO, Remax et Safe-RLHF.

Réorganisation efficace du poids du modèle: la composante 3D-hybridengine prend en charge les modèles d'acteurs pour réorganiser efficacement les poids des modèles pendant les étapes de formation et de génération, minimisant la redondance de la mémoire et les frais généraux de communication.

Déploiement automatisé du modèle et sélection de stratégies parallèles: les composants de cartographie automatique peuvent cartographier automatiquement les modèles vers différents appareils en fonction de la charge du modèle et des dépendances des données et sélectionner la meilleure politique parallèle, simplifiant ainsi le processus de déploiement du modèle et améliorant l'efficacité de la formation.

Les résultats expérimentaux montrent que le débit d'Hybridflow augmente considérablement lors de l'exécution de divers algorithmes RLHF, jusqu'à 20,57 fois. L'open source d'Hybridflow fournira des outils puissants à la recherche et au développement du RLHF afin de promouvoir le développement de la technologie LLM à l'avenir.

Adresse papier: https://arxiv.org/pdf/2409.19256

L'open source du cadre Hybridflow offre un moyen efficace d'améliorer le processus de formation LLM. Nous attendons avec impatience que Hybridflow joue un plus grand rôle dans la recherche LLM future.