Rakuten Group a publié son premier modèle de grande langue japonais (LLM) Rakuten Ai2.0 et son modèle de petit langage (SLM) Rakuten Ai2.0mini, visant à promouvoir le développement de l'intelligence artificielle au Japon. Rakuten AI2 Rakuten AI2.0mini est un modèle compact avec 1,5 milliard de paramètres, conçu pour le déploiement des périphériques Edge, en prenant en compte la rentabilité et la facilité des applications. Les deux modèles sont open source et fournissent des versions optimisées et optimisées pour prendre en charge diverses tâches de génération de texte.

Rakuten Group a annoncé le lancement de son premier modèle japonais de grande langue (LLM) et de son modèle de langue petite (SLM), nommé Rakuten Ai2.0 et Rakuten Ai2.0 Mini.

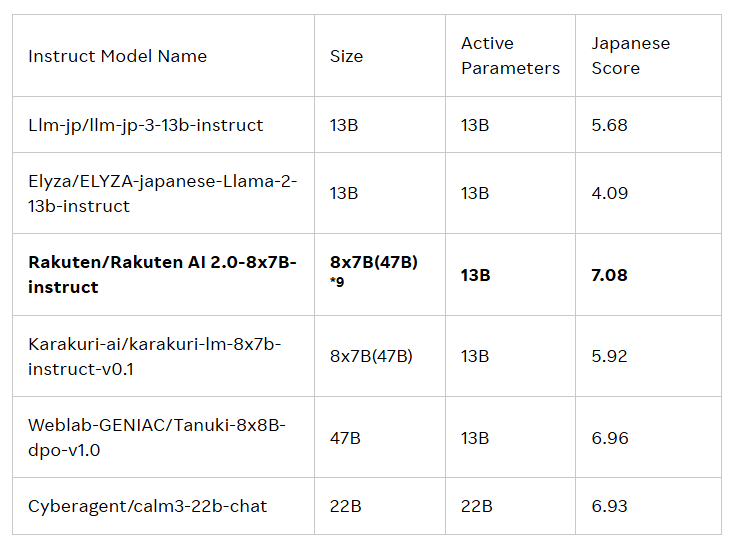

La sortie de ces deux modèles est destinée à stimuler le développement de l'intelligence artificielle (IA) au Japon. Rakuten AI2.0 est basé sur l'architecture d'experts hybrides (MOE) et est un modèle 8x7b composé de huit modèles avec 7 milliards de paramètres, chacun en tant qu'expert. Chaque fois que le jeton d'entrée est traité, le système l'enverra aux deux experts les plus pertinents et le routeur est responsable de la sélection. Ces experts et routeurs s'entraînent constamment ensemble grâce à une grande quantité de données bilingues japonaises et anglaises de haute qualité.

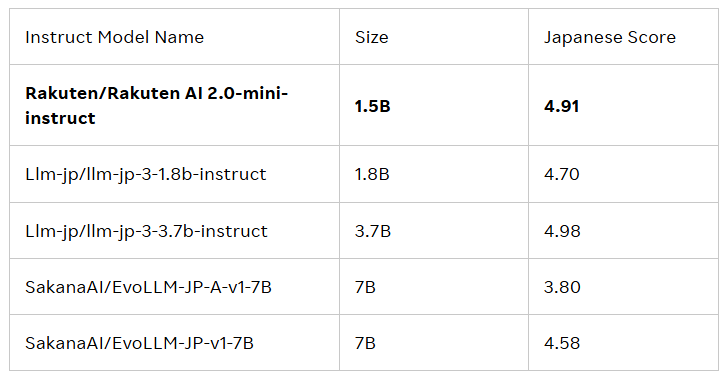

Rakuten AI2.0mini est un nouveau modèle dense avec un volume de paramètres de 1,5 milliard, conçu pour un déploiement de périphériques de bord rentable et adapté à des scénarios d'application spécifiques. Il est également formé sur des données mixtes au Japon et au Royaume-Uni, dans le but de fournir une solution pratique. Les deux modèles ont été affinés et préférés, et ont publié des modèles de base et des modèles d'instructions pour soutenir les entreprises et les professionnels dans le développement d'applications d'IA.

Tous les modèles sont sous le contrat de licence Apache2.0, que les utilisateurs peuvent obtenir dans la bibliothèque officielle de l'étreinte du groupe Rakuten. De plus, ces modèles peuvent également servir de base à d'autres modèles, qui facilitent le développement et l'application.

Cai Ting, chef d'IA et d'agent de données chez Rakuten Group, a déclaré: «Je suis extrêmement fier de la façon dont notre équipe combine les données, l'ingénierie et la science pour lancer Rakuten AI2.0. Les entreprises prennent des décisions intelligentes, accélèrent la réalisation de la valeur et ouvrent de nouvelles possibilités. . "

Blog officiel: https://global.rakuten.com/corp/news/press/2025/0212_02.html

Points clés:

Rakuten Group lance son premier modèle japonais de grande langue (LLM) et son modèle de langue petite (SLM), appelé Rakuten Ai2.0 et Rakuten Ai2.0 Mini.

Rakuten AI2.0 est basé sur une architecture d'experts hybrides et possède huit modèles d'experts avec 7 milliards de paramètres, déterminé à traiter efficacement les données bilingues japonaises et anglaises.

Tous les modèles sont disponibles dans la bibliothèque officielle de Face Rakuten Huging Face, adapté à une variété de tâches de génération de texte et servent de base à d'autres modèles.

En bref, le lancement de Rakuten Ai2.0 et Rakuten AI2 à sa future application et à son impact.