Google a récemment lancé trois nouveaux modèles d'IA de la série Gemini 2.0: la version de base de Gemini 2.0 Flash, la version économique de Gemini 2.0 Flash-Lite et la version expérimentale de Gemini 2.0 Pro, visant à répondre aux différents besoins des différents utilisateurs et développeurs pour les performances et le coût. Ces trois modèles mettent l'accent sur les fonctionnalités et les prix, marquant une autre étape dans le progrès continu de Google dans le domaine des modèles de grande langue. L'article expliquera en détail les caractéristiques, les performances et les prix de ces trois modèles, et fera des prédictions préliminaires sur la direction future de développement de Google dans le domaine de l'IA.

Google a élargi sa famille de modèles AI et a lancé trois nouvelles versions de modèles Gemini2.0, à savoir la version de base de Gemini2.0Flash, la version économique de Gemini2.0flash-Lite et la version expérimentale de Gemini2.0pro. Ces nouveaux modèles sont conçus pour répondre à différents besoins d'utilisation et fournir un équilibre diversifié entre les performances et les coûts.

La version de base de Gemini2.0flash a été lancée pour la première fois en décembre de l'année dernière et est maintenant entièrement lancée, avec des limites de fréquence d'utilisation plus élevées et des performances améliorées. GEMINI2.0FLASH-LITE est une variante à faible coût pour les développeurs et est actuellement prévisualisée publiquement via l'API.

Gemini2.0pro est un modèle expérimental conçu pour des tâches invites et codantes complexes, avec une fenêtre de contexte qui s'étend à 2 millions de marqueurs, deux fois plus que la version flash.

Actuellement, ces modèles ne prennent en charge que la sortie du texte, et Google prévoit d'ajouter des capacités vidéo, audio et en direct aux modèles Flash et Pro dans les prochains mois. De plus, les trois modèles sont capables de traiter les images et l'audio en entrées.

En termes de tests, Google a compliqué les performances de Gemini2.0pro, et les résultats ont montré qu'il a surpassé les modèles précédents dans presque tous les domaines. Dans la tâche mathématique, GEMINI2.0PRO a marqué 91,8% sur la référence mathématique, tandis que Hiddenmath a marqué 65,2%, dépassant de loin les performances de la version flash.

Gemini2.0Flash a marqué 29,9% au test SimpleQA d'OpenAI, tandis que le modèle Pro a obtenu un score de 44,3%. Cela montre que Gemini2.0pro a une précision plus élevée pour répondre à des questions complexes.

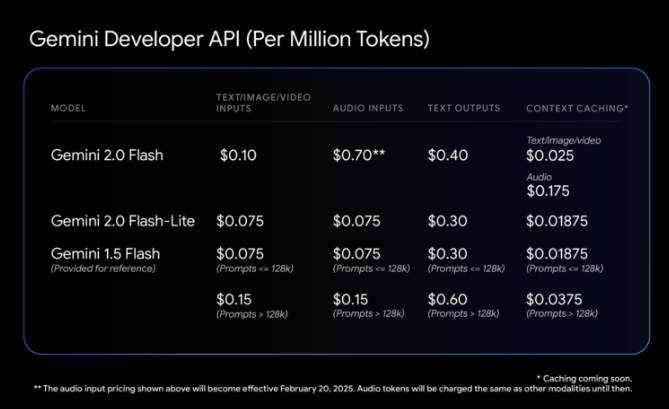

Il convient de noter que Google a ajusté sa tarification de l'API, éliminant les différences précédentes entre les requêtes texte courtes et longues. Cela signifie que les charges de travail hybrides (texte et images) peuvent coûter moins cher que la version Gemini1.5Flash, bien que les améliorations des performances. En termes de prix spécifique, les frais pour Gemini2.0flash sont fixés à 0,075 $ US par million de contributions et de production est de 0,4 US. Le Gemini2.0flash-lite relativement bon marché coûte 0,075 $ pour les entrées de texte, d'image et de vidéo et de 0,30 $ pour la sortie du texte.

Alors que Gemini2.0Flash est plus élevé que les générations précédentes, le nouveau modèle Flash-Lite offre de meilleures performances au même prix, visant à combler l'écart entre le prix et les performances.

De plus, Google a mis à jour l'application Gemini et a complètement ouvert les fonctions de la série Gemini, visant à offrir aux utilisateurs une expérience utilisateur plus riche.

Tous les modèles sont disponibles sur les appareils de bureau et mobiles via Google AI Studio et Vertex AI et le chatbot avancé avancé avancé de Google.

Blog officiel: https://blog.google/technology/google-deepmind/gemini-model-updates-february-2025/

Points clés:

Google a lancé trois nouveaux modèles Gemini2.0, notamment Flash, Flash-Lite et Pro pour répondre à différents besoins.

Gemini2.0pro a bien fonctionné dans les tests de mathématiques et de précision, avec des scores significativement plus élevés que les générations précédentes.

Les ajustements de tarification de l'API rendent le coût des charges de travail hybrides plus compétitives, tandis que Flash-Lite comble les lacunes du marché avec de meilleures performances.

En bref, la sortie de la série Gemini 2.0 de Google démontre son innovation continue dans le domaine des modèles de langage à grande échelle et sa compréhension précise de la demande de marché diversifiée. À l'avenir, avec l'amélioration des fonctions multimodales et l'optimisation des stratégies de prix, la série Gemini devrait occuper une position plus importante dans le domaine de l'IA.