Selon le récit officiel officiel de l'équipe de Doubao Big Model, dans le cadre des recherches conjointes de l'Université de Jiaotong de Pékin et de l'Université des sciences et de la technologie de Chine, le modèle expérimental de génération de vidéos "Videoworld" proposé par l'équipe de Doubao Big Model a été officiellement ouvert récemment.

Le plus grand moment fort de ce modèle est qu'il ne s'appuie plus sur des modèles de langage traditionnels, mais peut reconnaître et comprendre le monde en fonction des informations visuelles. Cette recherche révolutionnaire a été inspirée par le concept du professeur Li Feifei selon lequel «les jeunes enfants peuvent comprendre le monde réel sans compter sur la langue» mentionnée dans son discours TED.

"Videoworld" réalise les capacités complexes d'inférence, de planification et de prise de décision en analysant et en traitant de grandes quantités de données vidéo. Les expériences de l'équipe de recherche ont montré que le modèle a obtenu des résultats significatifs avec seulement 300 m de paramètres. Contrairement aux modèles existants qui reposent sur des données de langue ou de balise, Videoworld peut apprendre indépendamment les connaissances, en particulier dans des tâches complexes telles que les naissances en origami et en arc, qui peuvent fournir une méthode d'apprentissage plus intuitive.

Afin de vérifier l'efficacité de ce modèle, l'équipe de recherche a établi deux environnements expérimentaux: GO Battle et Contrôle de la simulation des robots. En tant que jeu hautement stratégique, GO peut évaluer efficacement la capacité d'apprentissage et de raisonnement des règles du modèle, tandis que les tâches de robot examinent les performances du modèle en matière de contrôle et de planification. Pendant la phase de formation, le modèle établit progressivement la capacité de prédire les images futures en regardant une grande quantité de données de démonstration vidéo.

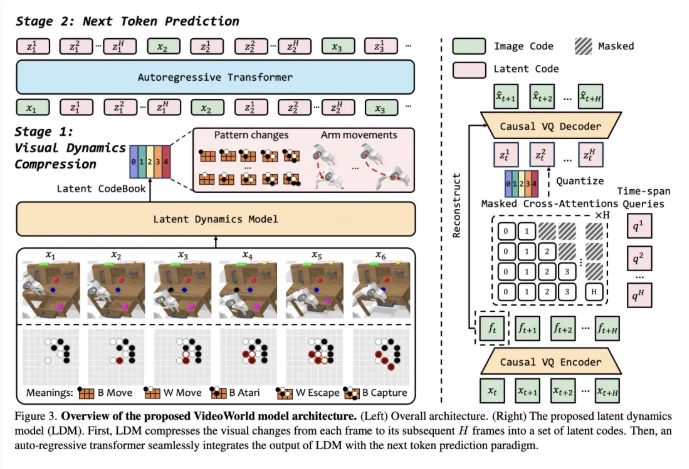

Pour améliorer l'efficacité de l'apprentissage vidéo, l'équipe a introduit un modèle dynamique potentiel (LDM) conçu pour compresser les changements visuels entre les trames vidéo pour extraire des informations critiques. Cette méthode réduit non seulement les informations redondantes, mais améliore également l'efficacité d'apprentissage du modèle des connaissances complexes. Grâce à cette innovation, Videoworld démontre des capacités exceptionnelles dans les tâches robotiques et atteint même le niveau de GO professionnel en cinq étapes.

Lien papier: https://arxiv.org/abs/2501.09781

Lien de code: https://github.com/bytedance/videoworld

Page d'accueil du projet: https://maverickren.github.io/videoworld.github.io

Points clés:

Le modèle "Videoworld" peut réaliser l'apprentissage des connaissances basé uniquement sur des informations visuelles et ne s'appuie pas sur des modèles de langue.

Le modèle démontre d'excellentes capacités de raisonnement et de planification dans les tâches de simulation de robot et de robot.

Le code du projet et le modèle ont été ouverts, et les gens de tous horizons sont invités à participer à l'expérience et à l'échange.