Les chercheurs de Meta AI et les partenaires universitaires ont développé un système innovant, MILS (Solver itératif itératif multimodal), qui enseigne aux modèles de grands langues pour traiter les images, les vidéos et l'audio sans formation spécialisée. MILS s'appuie sur la capacité naturelle de résolution de problèmes des modèles de langue plutôt que sur de grandes quantités de formation des données, montrant ses avantages uniques.

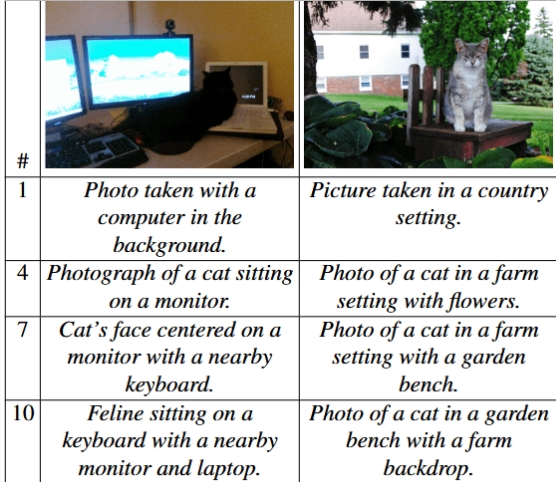

MILS fonctionne en jumelant deux modèles d'IA pour effectuer des solutions de tâche: l'une est un "générateur", responsable de la proposition de solutions de tâche, et l'autre est une "évaluation", utilisée pour évaluer l'efficacité de la solution générée. Les commentaires fournis par le marqueur peuvent aider le générateur à optimiser en continu la réponse jusqu'à ce qu'elle atteigne un résultat satisfaisant. Par exemple, dans la tâche de description de l'image, MILS peut progressivement affiner les descriptions d'images, décrivant ainsi avec précision les détails de l'image à différents niveaux.

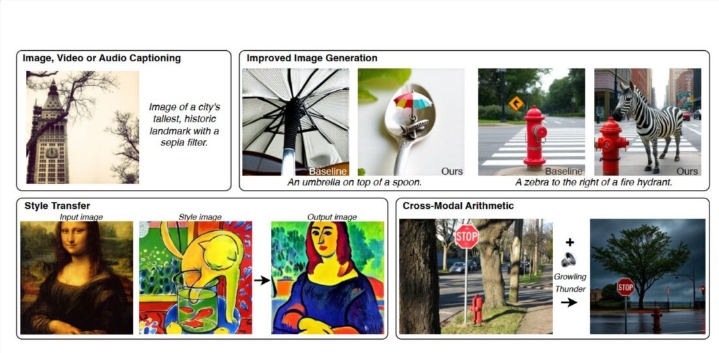

MILS fonctionne particulièrement bien dans la description de l'image. En utilisant le modèle LLAMA-3.1-8B en tant que générateur et le modèle CLIP en tant que marqueur, MILS est capable de créer des descriptions d'images comparables à celles des méthodes de pointe actuelles, bien que le clip ne soit pas spécifiquement formé pour les tâches de description d'image. De plus, MILS améliore également les capacités de génération de texte à l'image par des invites de texte affinées et peut combiner des invites générées par l'IA avec des outils de traitement d'image pour gérer les tâches d'édition d'image telles que la conversion de style.

La précision de la description de l'image augmente avec le nombre d'étapes entre le générateur et le marqueur. | Photo: Ashutosh, etc.

Les capacités de MILS ne se limitent pas aux images, elles s'étendent également aux champs vidéo et audio. Lorsqu'il est testé à l'aide de l'ensemble de données vidéo MSR-VTT, MILS surpasse les modèles existants dans la description du contenu vidéo. Étant donné que MILS ne modifie pas les paramètres du modèle pendant le fonctionnement, il peut convertir différents types de données en texte lisible, prenant en charge la fusion et la conversion d'informations à partir de plusieurs sources telles que les images et l'audio dans le format souhaité, faisant ainsi que des applications convergentes d'informations multimodales ouvrent de nouvelles possibilités.

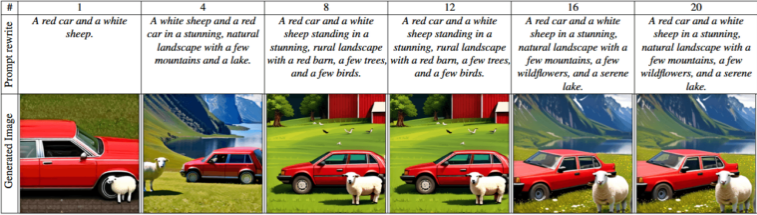

Les tests montrent que l'utilisation de générateurs plus grands et de modèles de notation peut produire des résultats plus précis, et l'augmentation du nombre de solutions potentielles peut améliorer considérablement les performances. Les chercheurs ont également constaté que l'extension à un modèle de langue plus large améliore non seulement la qualité des résultats, mais améliore également considérablement les performances.

Les paysages évoluent de simples descriptions de base aux représentations complexes de paysage avec des détails plus précis et des éléments plus naturels. | Photo: Ashutosh, etc.

Cette stratégie innovante adoptée par MILS est conforme à la tendance actuelle du domaine de l'intelligence artificielle envers les capacités de raisonnement plus intelligentes. L'équipe Meta a également déclaré que MILS pourrait montrer un grand potentiel à l'avenir dans des domaines tels que le traitement des données 3D, favorisant davantage le développement d'une IA multimodale.

Avec le développement rapide du GPT-4 d'OpenAI et d'autres alternatives open source, telles que Meta's Llama 3.2, Mistral's Pixtral et Janus Pro de Deepseek, ces systèmes d'IA multimodaux émergents accélèrent leur application à la vie quotidienne. Développement de l'intelligence artificielle.