OpenAI a récemment démontré le processus de raisonnement détaillé de son dernier modèle d'inférence O3-MinI, une décision considérée comme une réponse à une pression croissante sur le concurrent Deepseek-R1. Cette décision marque un changement important dans la stratégie de transparence du modèle d'OpenAI.

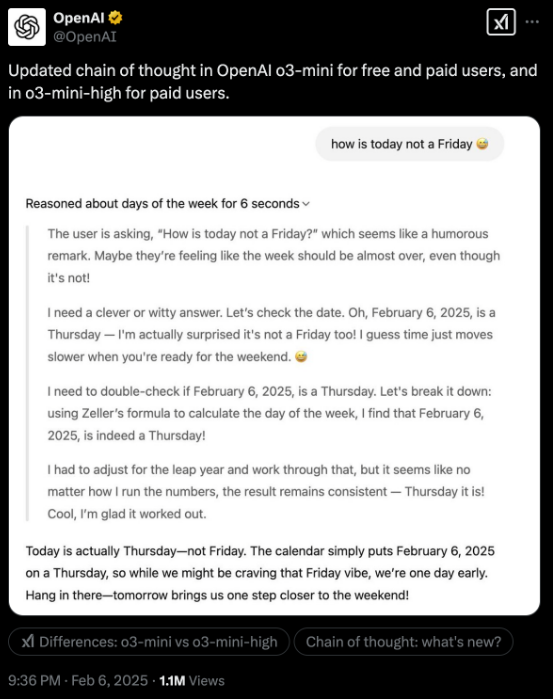

Auparavant, OpenAI a toujours considéré la «chaîne de pensée» (COT) comme son avantage concurrentiel principal et a choisi de le cacher. Cependant, comme les modèles ouverts tels que Deepseek-R1 démontrent pleinement leur trajectoire d'inférence, cette stratégie fermée est devenue la lacune d'Openai. Bien que la nouvelle version de l'O3-MinI n'ouvre toujours pas complètement la marque d'origine, il fournit un affichage plus clair du processus de raisonnement.

OpenAI rattrape également activement en termes de performances et de coûts. Le prix de l'O3-Mini est tombé à 4,40 $ par million de jetons de production, bien en dessous de 60 $ pour le modèle O1 précédent et proche du prix de 7-8 $ pour le Deepseek-R1 sur les fournisseurs américains. Pendant ce temps, O3-Mini surpasse ses prédécesseurs dans plusieurs repères d'inférence.

Les tests réels montrent que la démonstration détaillée du processus de raisonnement d'O3-MINI améliore la praticité du modèle. Lors du traitement des données non structurées, les utilisateurs peuvent mieux comprendre la logique d'inférence du modèle, optimisant ainsi les mots rapides pour des résultats plus précis.

Le PDG d'Openai, Sam Altman, a récemment admis "debout du mauvais côté de l'histoire" sur le débat open source. Comme Deepseek-R1 est adopté et amélioré par de nombreuses institutions, les ajustements futurs d'Openai aux stratégies open source méritent d'être prêts à prêter attention.

La stratégie transparente d'OpenAI et l'optimisation des coûts indiquent leur innovation et sa concurrence continue dans le domaine de l'IA.