Ces dernières années, avec le développement rapide de modèles de grandes langues, les modèles d'amélioration des inférences ont également déclenché des discussions approfondies sur leurs taux d'hallucination tout en améliorant les capacités de traitement des tâches complexes. L'équipe d'apprentissage automatique de Vectara a récemment mené une étude approfondie des modèles de la série Deepseek, révélant des différences significatives dans le modèle d'amélioration des inférences en termes de taux d'hallucination.

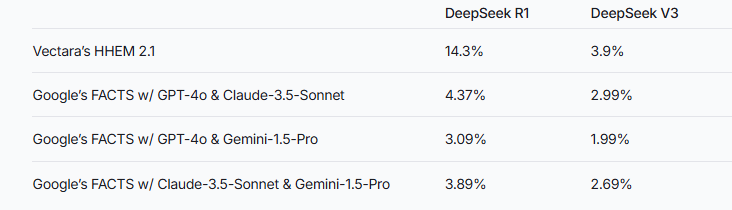

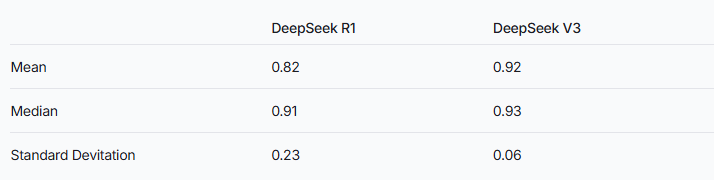

Récemment, l'équipe d'apprentissage automatique de Vectara a effectué des tests d'hallucination approfondis sur deux modèles de la série Deepseek. V3. Cela suggère que Deepseek-R1 produit plus inexact ou incompatible avec les informations originales pendant le processus d'augmentation du raisonnement. Ce résultat déclenche une discussion approfondie sur le taux d'hallucination du modèle de grande langue amélioré par l'inférence (LLM).

Remarques de la source d'image: L'image est générée par l'IA, et le fournisseur de services autorisé l'image MidJourney

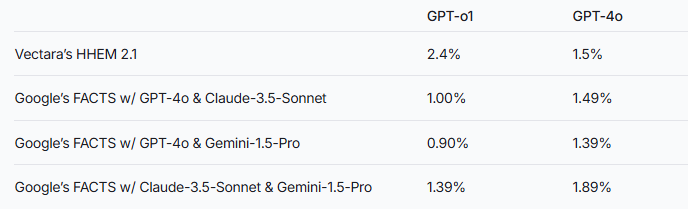

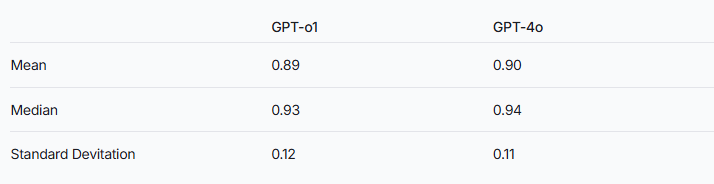

L'équipe de recherche a souligné que les modèles d'augmentation d'inférence peuvent être plus sujets aux hallucinations que les modèles ordinaires de grande langue. Ce phénomène est particulièrement évident dans la comparaison de la série Deepseek avec d'autres modèles d'amélioration d'inférence. Prenant la série GPT comme exemple, la différence de taux d'hallucination entre le GPT-O1 amélioré du raisonnement et la version normale de GPT-4O vérifient également cette spéculation.

Pour évaluer les performances de ces deux modèles, les chercheurs ont utilisé le modèle HHEM de Vectara et la méthode des faits de Google pour porter des jugements. En tant qu'outil de détection d'hallucination spécialisée, HHEM présente une sensibilité plus élevée lors de la capture de l'augmentation du taux d'hallucination de Deepseek-R1, tandis que le modèle des faits fonctionne relativement mal à cet égard. Cela nous rappelle que HHEM peut être plus efficace que LLM en tant que norme.

Il convient de noter que Deepseek-R1, malgré ses excellentes performances dans le raisonnement, s'accompagne d'un taux d'hallucination plus élevé. Cela peut être lié à la logique complexe requise pour traiter les modèles d'amélioration de l'inférence. À mesure que la complexité du raisonnement du modèle augmente, la précision du contenu généré peut être affectée à la place. L'équipe de recherche a également souligné que si Deepseek peut se concentrer davantage sur la réduction des hallucinations pendant la phase de formation, il peut être possible de parvenir à un bon équilibre entre la capacité de raisonnement et la précision.

Bien que les modèles améliorés par l'inférence présentent généralement des hallucinations plus élevées, cela ne signifie pas qu'ils n'ont pas d'avantage à d'autres égards. Pour la série Deepseek, il est toujours nécessaire de résoudre les hallucinations dans les recherches et l'optimisation ultérieures pour améliorer les performances globales du modèle.

Référence: https://www.vectara.com/blog/deepseek-r1-hallucinats-more-than-deepseek-v3

Avec l'évolution continue des modèles de grandes langues, comment réduire les taux d'hallucination tout en améliorant les capacités de raisonnement deviendra une direction importante pour les recherches futures. Les résultats des tests de la série Deepseek nous fournissent une référence précieuse pour promouvoir l'industrie pour optimiser davantage les performances du modèle.