Avec le développement rapide de la technologie de l'intelligence artificielle, les modèles linguistiques deviennent de plus en plus largement utilisés dans plusieurs domaines. Cependant, une nouvelle étude OpenAI a révélé que ces modèles se sont bien comportés des attentes lorsqu'ils répondent aux questions factuelles, déclenchant une repensation de la capacité de l'IA à acquérir des connaissances.

Une étude récente d'OpenAI montre qu'en dépit du développement rapide de la technologie de l'intelligence artificielle, les modèles linguistiques les plus avancés actuels ont des taux de réussite beaucoup plus faibles pour répondre aux questions factuelles.

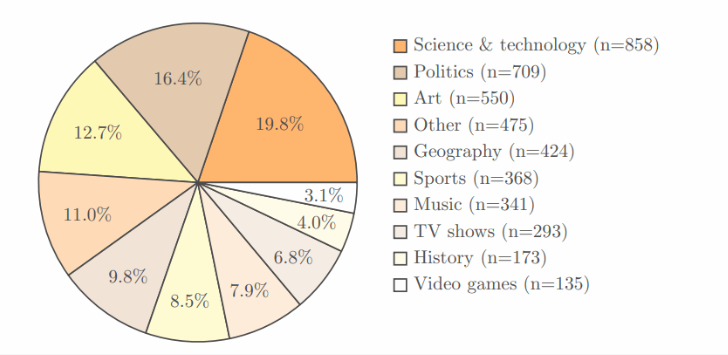

L'étude a adopté le test de référence SimpleQA d'Openai, qui contient 4 326 domaines, couvrant plusieurs domaines tels que la science, la politique et l'art, et chaque question a une réponse claire et correcte.

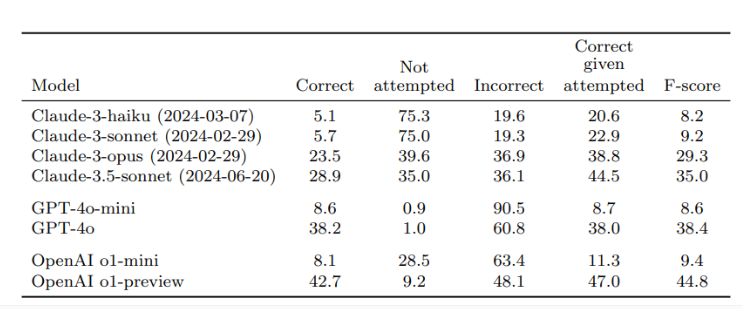

Après vérification de deux examinateurs indépendants, les résultats ont montré que le taux de précision de l'O1-Preview, le meilleur modèle d'OpenAI, n'était que de 42,7%, tandis que le GPT-4O était légèrement inférieur, seulement 38,2%. Quant au plus petit GPT-4O-MINI, le taux de précision n'est même que 8,6%. En revanche, le modèle de Claude d'Anthropic a permis de faire moins de performances, le taux de précision de Claude-3.5-Sonnet n'étant que de 28,9%.

La clé de cette étude est la conception du test, non seulement pour tester les performances de l'IA, mais aussi pour faire en sorte que chacun réalise les limites des modèles d'IA en termes d'acquisition de connaissances. Les chercheurs soulignent que lors de l'utilisation de ces modèles, les utilisateurs devraient les considérer comme des outils de traitement de l'information plutôt que de compter entièrement sur des sources de connaissances. Pour obtenir des réponses plus précises, il est préférable de fournir des données fiables pour l'IA plutôt que de s'appuyer uniquement sur ses connaissances intégrées.

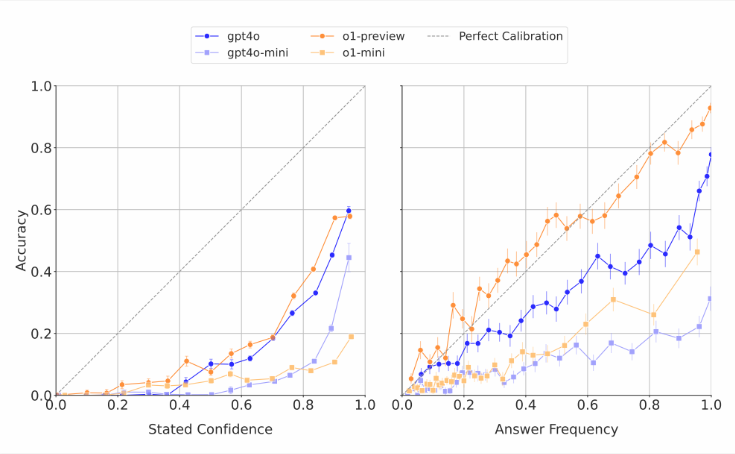

Il convient de noter que les modèles d'IA estiment souvent leurs propres capacités. Les chercheurs ont découvert que lorsque ces modèles étaient invités à marquer la confiance dans leurs réponses, ils ont généralement donné un score de précision exagéré. Dans les tests qui répondent à plusieurs reprises à la même question, même si le modèle donne la même réponse plusieurs fois, leur taux de réussite réel est toujours inférieur à la précision de leur auto-évaluation. Cela est conforme aux critiques du monde extérieur qui produit souvent des réponses absurdes aux modèles de langue mais semble confiante.

Les chercheurs pensent qu'il y a un écart clair dans la précision factuelle des systèmes d'IA actuels et a besoin d'une amélioration urgente. Dans le même temps, ils ont également posé une question ouverte: si les performances de l'IA pour répondre à de courtes questions factuelles peuvent prédire comment cela fonctionne lorsqu'il s'agit de réponses plus longues et plus complexes. Pour soutenir le développement de modèles linguistiques plus fiables, OpenAI a publié des données sur les références SimpleQA publiquement sur GitHub.

Points clés:

La recherche OpenAI montre que les modèles linguistiques les plus avancés ont de faibles taux de réussite lorsqu'ils répondent aux questions factuelles, avec un taux de réussite maximal de seulement 42,7%.

Ces modèles d'IA surestiment souvent leurs capacités et leurs scores de confiance sont généralement exagérés.

OpenAI a rendu le public SimpleQA Benchmark pour aider à rechercher des modèles de langage plus fiables.

Cette étude nous rappelle que malgré les progrès significatifs de la technologie de l'IA, ses limites doivent être traitées avec prudence dans les applications pratiques et continuer à promouvoir des améliorations technologiques.