Les dernières recherches dans le domaine de l'intelligence artificielle révèlent une similitude surprenante entre les modèles de grande langue (LLM) et les structures cérébrales humaines. Grâce à une analyse approfondie de l'espace d'activation de la LLM, les scientifiques du MIT ont découvert que sa structure interne a une correspondance significative avec les niveaux de micro, méso et macro du cerveau humain. Cette découverte fournit non seulement une nouvelle perspective pour que nous compreniez le fonctionnement de l'IA, mais jette également les bases du développement futur des systèmes d'IA plus intelligents.

L'IA a en fait commencé à «développer votre cerveau» ?! Les dernières recherches du MIT montrent que la structure interne des modèles de grands langues (LLMS) a en fait des similitudes incroyables avec le cerveau humain!

Cette étude a utilisé la technologie de l'autoencoder clairsemé pour effectuer une analyse approfondie de l'espace d'activation de LLM et a découvert trois niveaux de caractéristiques structurelles, ce qui était incroyable:

Premièrement, au niveau microscopique, les chercheurs ont découvert l'existence d'une structure "cristal". Les visages de ces «cristaux» sont composés de parallélogrammes ou de trapézoïdes, similaires aux analogies de vocabulaire familières telles que «Man: Women: King: Queen».

Ce qui est encore plus surprenant, c'est que ces structures "cristallines" deviennent plus claires après avoir supprimé certains facteurs d'interférence non pertinents (tels que la longueur des mots) grâce à des techniques d'analyse discriminante linéaires.

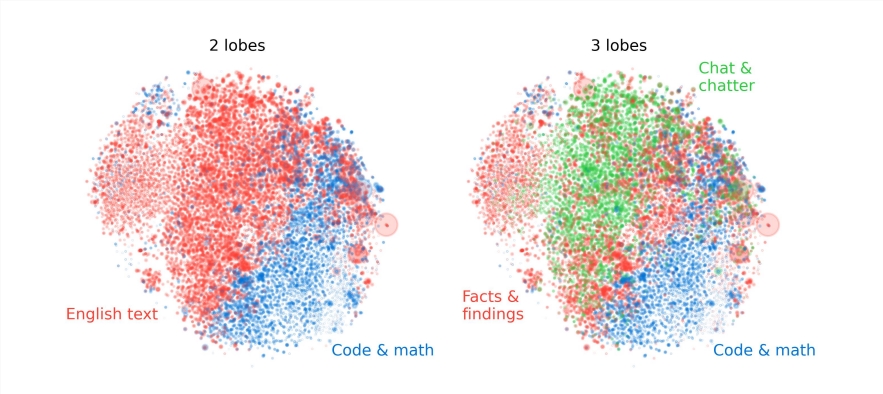

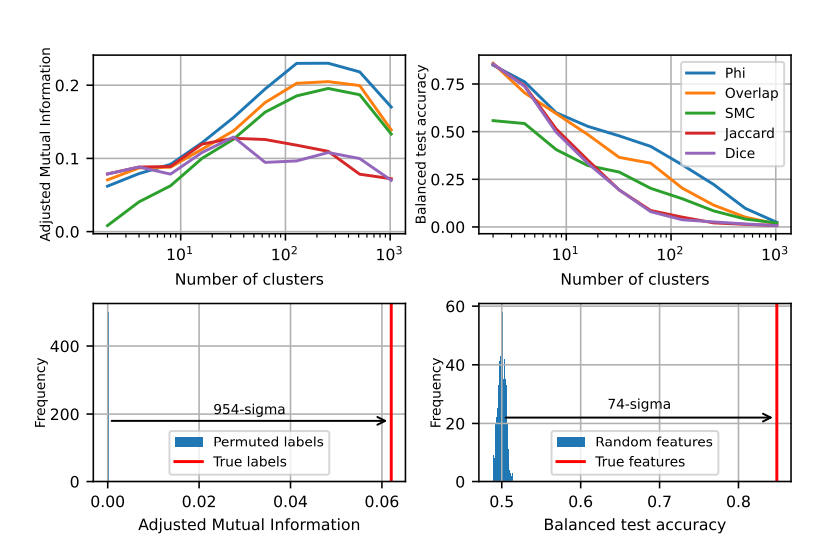

Deuxièmement, au niveau méso, les chercheurs ont constaté que l'espace d'activation de LLM a une structure modulaire similaire à la partition fonctionnelle du cerveau humain.

Par exemple, les caractéristiques liées aux mathématiques et au code se réuniront pour former un «lobe cérébral» similaire au lobe fonctionnel du cerveau humain. Grâce à l'analyse quantitative par plusieurs indicateurs, les chercheurs ont confirmé la localité spatiale de ces "lobes cérébraux", indiquant que les caractéristiques concomitantes sont également plus concentrées spatialement, dépassant de loin les attentes d'une distribution aléatoire.

Au niveau macro, les chercheurs ont constaté que la structure globale du nuage de points de fonctionnalité LLM n'est pas isotrope, mais montre une distribution de valeurs propres de la loi de puissance, et cette distribution est plus évidente dans la couche intermédiaire.

Les chercheurs ont également quantifié l'entropie de regroupement à différents niveaux et ont constaté que l'entropie de clustering de la couche intermédiaire était plus faible, indiquant que la représentation des caractéristiques était plus concentrée, tandis que l'entropie de regroupement des couches précoces et tardives était plus élevée, indiquant que la représentation des caractéristiques était plus dispersé.

Cette étude nous offre une nouvelle perspective pour comprendre les mécanismes internes des modèles de grands langues et jette les bases du développement futur de systèmes d'IA plus puissants et plus intelligents.

Cette étude révèle non seulement la similitude entre l'IA et le cerveau humain, mais fournit également une nouvelle direction pour le développement futur de la technologie de l'IA, ce qui indique que l'IA deviendra plus intelligente et plus efficace.