Avec le développement rapide de la technologie de l'intelligence artificielle, le modèle de grande langue (LLM) joue un rôle de plus en plus important dans les applications modernes. Qu'il s'agisse d'un chatbot, d'un générateur de code ou d'autres tâches basées sur le traitement du langage naturel, les capacités de LLM sont devenues le moteur principal. Cependant, avec l'expansion continue de l'échelle du modèle et l'augmentation de la complexité, les problèmes d'efficacité du processus d'inférence sont progressivement devenus proéminents, en particulier lors du traitement des données à grande échelle et des calculs complexes, le retard et la consommation de ressources sont devenus des goulots d'étranglement qui doivent être résolus instamment.

En tant que composant central de LLM, le mécanisme d'attention affecte directement l'efficacité d'inférence du modèle. Cependant, les mécanismes d'attention traditionnels tels que Flashattention et SparsEttention fonctionnent souvent mal face à des charges de travail diverses, des modes d'entrée dynamiques et des contraintes de ressources GPU. La latence élevée, les goulots d'étranglement de la mémoire et la faible utilisation des ressources ont sérieusement limité l'évolutivité et la vitesse de réponse de l'inférence LLM. Par conséquent, le développement d'une solution efficace et flexible est devenu au centre de la recherche actuelle.

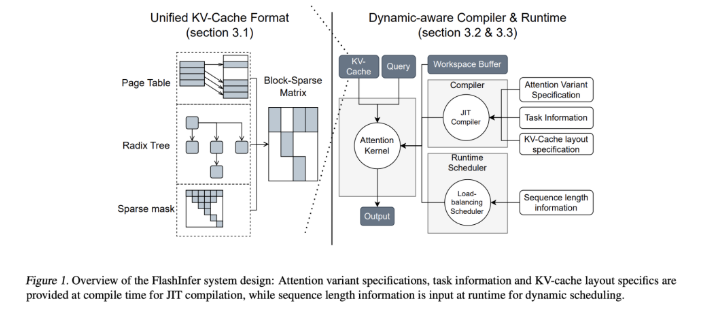

Pour relever ce défi, les équipes de recherche de l'Université de Washington, Nvidia, Perplexity AI et Carnegie Mellon University ont développé conjointement Flashinfer. Il s'agit d'une bibliothèque d'intelligence artificielle et d'un générateur de noyau conçu spécifiquement pour le raisonnement LLM, conçu pour optimiser plusieurs mécanismes d'attention, notamment FlashAntiser, SparsEttension, PageAttention et échantillonnage via des cœurs de GPU haute performance. La philosophie de conception de FlashInfer met l'accent sur la flexibilité et l'efficacité, peut répondre efficacement aux principaux défis des services d'inférence LLM et fournit des solutions pratiques pour l'inférence dans les modèles linguistiques à grande échelle.

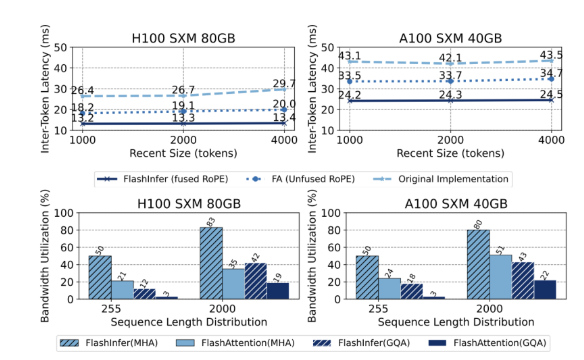

Les caractéristiques techniques de base de FlashInfer comprennent les aspects suivants: Premièrement, il fournit un support complet du noyau, couvrant divers mécanismes tels que le pré-remplissage, le décodage et l'attention supplémentaire. Performances des scénarios de demande et de service par lots. Deuxièmement, grâce à l'attention de la requête groupée (GQA) et à l'attention de la position rotationnelle fusionnée (Rope), Flashinfer atteint des améliorations de performances significatives dans le décodage prompt long, 31 fois plus rapide que l'attention de la page de VLLM. De plus, le planificateur d'équilibrage de charge dynamique de FlashInfer peut s'ajuster dynamiquement en fonction des modifications d'entrée, réduire le temps d'inactivité du GPU et assurer une utilisation efficace des ressources. Sa compatibilité avec les graphiques CUDA améliore encore son applicabilité dans les environnements de production.

En termes de performances, FlashInfer fonctionne bien dans plusieurs repères, en particulier lorsqu'il s'agit d'une longue inférence de contexte et de tâches de génération parallèle, réduisant considérablement la latence. Sur le GPU NVIDIA H100, FlashInfer atteint une augmentation de la vitesse de 13-17% dans les tâches de génération parallèle. Son planificateur dynamique et son noyau optimisé améliorent considérablement la bande passante et l'utilisation du flop, permettant une utilisation efficace des ressources GPU, que ce soit en longueur de séquence inégale ou uniforme. Ces avantages font de FlashInfer un outil important pour promouvoir le développement du Framework de service LLM.

En tant que projet open source, FlashInfer fournit non seulement des solutions efficaces aux défis du raisonnement LLM, mais encourage également une collaboration et une innovation supplémentaires dans la communauté de la recherche. Ses capacités de conception et d'intégration flexibles lui permettent de s'adapter à la modification des besoins d'infrastructure d'IA et de s'assurer qu'elle reste en avance sur son leadership dans la relevée des défis émergents. Grâce aux efforts conjoints de la communauté open source, FlashInfer devrait jouer un rôle plus important dans le développement futur de la technologie de l'IA.

Entrée du projet: https://github.com/flashinfer-ai/flashinfer

Points clés:

FlashInfer est une bibliothèque d'intelligence artificielle nouvellement publiée conçue pour un raisonnement de modèle de grande langue et peut améliorer considérablement l'efficacité.

Cette bibliothèque prend en charge plusieurs mécanismes d'attention, optimise l'utilisation des ressources du GPU et réduit la latence d'inférence.

En tant que projet open source, FlashInfer accueille des chercheurs à participer pour promouvoir l'innovation et le développement de l'infrastructure d'IA.