Situs web | KompasHub | Peringkat Kompas | Dokumentasi | Instalasi | Masalah Pelaporan

Bahasa Inggris | 简体中文

bergabunglah dengan kami di Discord dan WeChat

Penting

Bintangi Kami , Anda akan menerima semua pemberitahuan rilis dari GitHub tanpa penundaan ~ ️

ke OpenCompass !

Sama seperti kompas yang memandu kita dalam perjalanan, OpenCompass akan memandu Anda melalui lanskap kompleks dalam mengevaluasi model bahasa besar. Dengan algoritma yang kuat dan antarmuka yang intuitif, OpenCompass memudahkan penilaian kualitas dan efektivitas model NLP Anda.

Jelajahi peluang di OpenCompass! Saat ini kami sedang merekrut peneliti/insinyur penuh waktu dan pekerja magang . Jika Anda tertarik dengan LLM dan OpenCompass, jangan ragu untuk menghubungi kami melalui email. Kami ingin mendengar pendapat Anda!

Kami dengan senang hati mengumumkan bahwa OpenCompass telah direkomendasikan oleh Meta AI , klik Memulai Llama untuk informasi lebih lanjut.

Perhatian

Pemberitahuan Perubahan yang Dapat Melanggar: Di versi 0.4.0, kami menggabungkan semua file konfigurasi AMOTIC (sebelumnya terletak di ./configs/datasets, ./configs/models, dan ./configs/summarizers) ke dalam paket opencompass. Pengguna disarankan untuk memperbarui referensi konfigurasi mereka untuk mencerminkan perubahan struktural ini.

[10.10.2024] Kami sekarang mendukung kumpulan data QA multibahasa OpenAI MMMLU. Jangan ragu untuk mencobanya!

[2024.09.19] Kami sekarang mendukung Qwen2.5 (0,5B hingga 72B) dengan beberapa backend (huggingface/vllm/lmdeploy). Jangan ragu untuk mencobanya!

[2024.09.17] Kami sekarang mendukung OpenAI o1( o1-mini-2024-09-12 dan o1-preview-2024-09-12 ). Jangan ragu untuk mencobanya!

[2024.09.05] Kami kini mendukung ekstraksi jawaban melalui pasca-pemrosesan model untuk memberikan representasi kemampuan model yang lebih akurat. Sebagai bagian dari pembaruan ini, kami telah mengintegrasikan XFinder sebagai model pasca-pemrosesan pertama kami. Untuk informasi lebih detail, silakan merujuk ke dokumentasi, dan cobalah!

[2024.08.20] OpenCompass kini mendukung SciCode: Tolok Ukur Pengodean Penelitian yang Dikurasi oleh Ilmuwan.

[2024.08.16] OpenCompass kini mendukung tolok ukur evaluasi model bahasa konteks panjang yang baru — RULER. RULER memberikan evaluasi konteks panjang termasuk pengambilan, penelusuran multi-hop, agregasi, dan menjawab pertanyaan melalui konfigurasi yang fleksibel. Lihat konfigurasi evaluasi RULER sekarang!

[2024.08.09] Kami telah merilis contoh data dan konfigurasi untuk CompassBench-202408, selamat datang di CompassBench untuk detail lebih lanjut.

[2024.08.01] Kami mendukung model Gemma2. Selamat mencoba!

[23.07.2024] Kami mendukung kumpulan data ModelScope, Anda dapat memuatnya sesuai permintaan tanpa mengunduh semua data ke disk lokal Anda. Selamat mencoba!

[2024.07.17] Kami sangat gembira mengumumkan rilis laporan teknis NeedleBench. Kami mengundang Anda untuk mengunjungi dokumentasi dukungan kami untuk pedoman evaluasi terperinci.

[2024.07.04] OpenCompass sekarang mendukung InternLM2.5, yang memiliki kemampuan penalaran yang luar biasa , jendela Konteks 1M dan penggunaan alat yang lebih kuat , Anda dapat mencoba model di OpenCompass Config dan InternLM ..

[2024.06.20] OpenCompass kini mendukung peralihan satu klik antar backend akselerasi inferensi, sehingga meningkatkan efisiensi proses evaluasi. Selain backend inferensi HuggingFace default, sekarang juga mendukung backend populer LMDeploy dan vLLM. Fitur ini tersedia melalui peralihan baris perintah sederhana dan melalui API penerapan. Untuk penggunaan detail, lihat dokumentasi..

Lagi

Kami menyediakan Papan Peringkat OpenCompass bagi komunitas untuk menentukan peringkat semua model publik dan model API. Jika Anda ingin mengikuti evaluasi, berikan URL repositori model atau antarmuka API standar ke alamat email [email protected] .

Kembali ke atas

Berikut adalah langkah-langkah untuk instalasi cepat dan persiapan kumpulan data.

Kami sangat merekomendasikan penggunaan conda untuk mengelola lingkungan python Anda.

conda buat --nama kompas terbuka python=3.10 -y conda mengaktifkan opencompass

pip install -U opencompass ## Instalasi penuh (dengan dukungan untuk lebih banyak kumpulan data) # pip install "opencompass[full]" ## Lingkungan dengan kerangka akselerasi model ## Kelola kerangka akselerasi yang berbeda menggunakan lingkungan virtual ## karena biasanya terdapat konflik ketergantungan dengan satu sama lain. # pip install "opencompass[lmdeploy]" # pip install "opencompass[vllm]" ## Evaluasi API (yaitu Openai, Qwen) # pip install "opencompass[api]"

Jika Anda ingin menggunakan fitur terbaru opencompass, atau mengembangkan fitur baru, Anda juga dapat membangunnya dari sumber

git clone https://github.com/open-compass/opencompass opencompass cd opencompass instalasi pip -e . # pip install -e ".[penuh]" # pip install -e ".[vllm]"

Anda dapat memilih salah satu untuk metode berikut dalam menyiapkan kumpulan data.

Anda dapat mengunduh dan mengekstrak kumpulan data dengan perintah berikut:

# Unduh kumpulan data ke data/folderwget https://github.com/open-compass/opencompass/releases/download/0.2.2.rc1/OpenCompassData-core-20240207.zip buka zip OpenCompassData-core-20240207.zip

Kami telah mendukung pengunduhan kumpulan data secara otomatis dari server penyimpanan OpenCompass. Anda dapat menjalankan evaluasi dengan tambahan --dry-run untuk mengunduh kumpulan data ini. Saat ini, kumpulan data yang didukung tercantum di sini. Kumpulan data lainnya akan diunggah baru-baru ini.

Anda juga dapat menggunakan ModelScope untuk memuat kumpulan data sesuai permintaan.

Instalasi:

pip instal modelscope[framework]ekspor DATASET_SOURCE=ModelScope

Kemudian kirimkan tugas evaluasi tanpa mengunduh semua data ke disk lokal Anda. Kumpulan data yang tersedia meliputi:

humaneval, triviaqa, commonsenseqa, tydiqa, strategyqa, cmmlu, lambada, piqa, ceval, matematika, LCSTS, Xsum, winogrande, openbookqa, AGIEval, gsm8k, nq, ras, siqa, mbpp, mmlu, hellaswag, ARC, BBH, xstory_cloze, ringkasan, GAOKAO-BENCH, OCNLI, cmnli

Beberapa fitur pihak ketiga, seperti Humaneval dan Llama, mungkin memerlukan langkah tambahan agar berfungsi dengan baik, untuk langkah detailnya silakan lihat Panduan Instalasi.

Kembali ke atas

Setelah memastikan OpenCompass terinstal dengan benar sesuai langkah di atas dan dataset sudah disiapkan. Sekarang Anda dapat memulai evaluasi pertama Anda menggunakan OpenCompass!

Evaluasi pertama Anda dengan OpenCompass!

OpenCompass mendukung pengaturan konfigurasi Anda melalui CLI atau skrip python. Untuk setting evaluasi yang sederhana sebaiknya menggunakan CLI, untuk evaluasi yang lebih kompleks disarankan menggunakan cara script. Anda dapat menemukan lebih banyak contoh skrip di bawah folder konfigurasi.

# CLIopencompass --models hf_internlm2_5_1_8b_chat --dataset demo_gsm8k_chat_gen# Skrip Pythonopencompass ./configs/eval_chat_demo.py

Anda dapat menemukan lebih banyak contoh skrip di bawah folder konfigurasi.

Evaluasi API

OpenCompass, berdasarkan desainnya, tidak terlalu membedakan antara model sumber terbuka dan model API. Anda dapat mengevaluasi kedua tipe model dengan cara yang sama atau bahkan dalam satu pengaturan.

ekspor OPENAI_API_KEY="YOUR_OPEN_API_KEY"# CLIopencompass --models gpt_4o_2024_05_13 --datasets demo_gsm8k_chat_gen# Skrip Pythonopencompass ./configs/eval_api_demo.py# Anda dapat menggunakan o1_mini_2024_09_12/o1_preview_2024_09_12 untuk model o1, kami menetapkan max_completion_tokens=8192 sebagai default.

Evaluasi yang Dipercepat

Selain itu, jika Anda ingin menggunakan backend inferensi selain HuggingFace untuk evaluasi yang dipercepat, seperti LMDeploy atau vLLM, Anda dapat melakukannya dengan perintah di bawah ini. Harap pastikan bahwa Anda telah menginstal paket yang diperlukan untuk backend yang dipilih dan model Anda mendukung inferensi yang dipercepat dengannya. Untuk informasi selengkapnya, lihat dokumentasi tentang backend akselerasi inferensi di sini. Di bawah ini adalah contoh penggunaan LMDeploy:

# CLIopencompass --models hf_internlm2_5_1_8b_chat --datasets demo_gsm8k_chat_gen -a lmdeploy# Skrip Pythonopencompass ./configs/eval_lmdeploy_demo.py

Model yang Didukung

OpenCompass memiliki konfigurasi yang telah ditentukan sebelumnya untuk banyak model dan kumpulan data. Anda dapat membuat daftar semua konfigurasi model dan kumpulan data yang tersedia menggunakan alat ini.

# Daftar semua konfigurasi alat python/list_configs.py# Daftar semua konfigurasi yang terkait dengan alat llama dan mmlupython/list_configs.py llama mmlu

Jika model tidak ada dalam daftar tetapi didukung oleh kelas Huggingface AutoModel, Anda juga dapat mengevaluasinya dengan OpenCompass. Anda dipersilakan untuk berkontribusi pada pemeliharaan model dan daftar kumpulan data yang didukung OpenCompass.

opencompass --datasets demo_gsm8k_chat_gen --hf-type chat --hf-path internlm/internlm2_5-1_8b-chat

Jika Anda ingin menggunakan beberapa GPU untuk mengevaluasi model secara paralel data, Anda dapat menggunakan --max-num-worker .

CUDA_VISIBLE_DEVICES=0,1 opencompass --datasets demo_gsm8k_chat_gen --hf-type chat --hf-path internlm/internlm2_5-1_8b-chat --max-num-worker 2

Tip

--hf-num-gpus digunakan untuk model paralel (format wajah berpelukan), --max-num-worker digunakan untuk paralel data.

Tip

konfigurasi dengan _ppl biasanya dirancang untuk model dasar. konfigurasi dengan _gen dapat digunakan untuk model dasar dan model obrolan.

Melalui baris perintah atau file konfigurasi, OpenCompass juga mendukung evaluasi API atau model khusus, serta strategi evaluasi yang lebih beragam. Silakan baca Mulai Cepat untuk mempelajari cara menjalankan tugas evaluasi.

Kembali ke atas

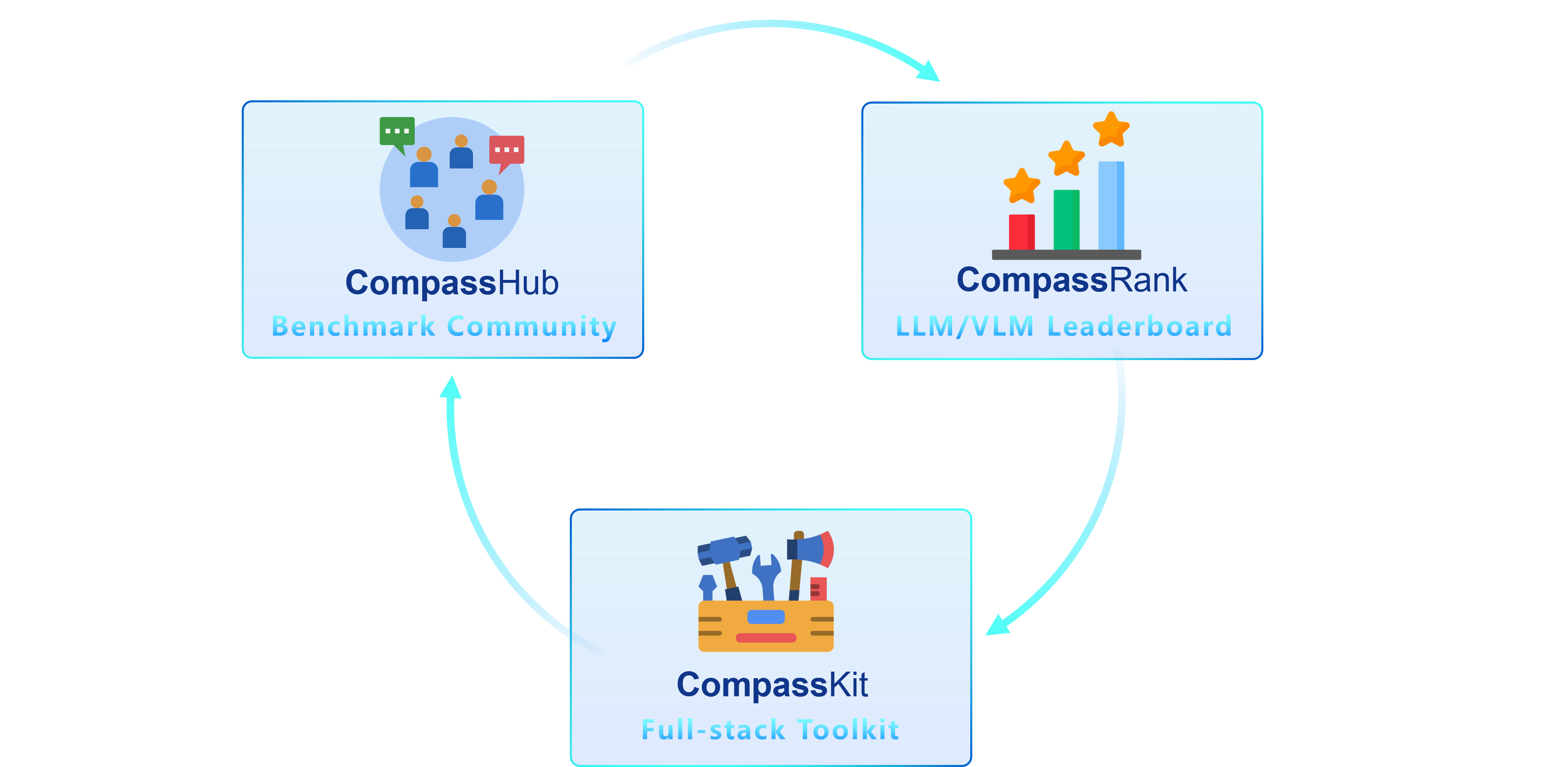

Kami sangat senang memperkenalkan OpenCompass 2.0, rangkaian lanjutan yang menampilkan tiga komponen utama: CompassKit, CompassHub, dan CompassRank.

CompassRank telah ditingkatkan secara signifikan ke dalam papan peringkat yang kini menggabungkan tolok ukur sumber terbuka dan tolok ukur kepemilikan. Peningkatan ini memungkinkan evaluasi model yang lebih komprehensif di seluruh industri.

CompassHub menghadirkan antarmuka browser benchmark perintis, yang dirancang untuk menyederhanakan dan mempercepat eksplorasi dan pemanfaatan beragam benchmark bagi para peneliti dan praktisi. Untuk meningkatkan visibilitas tolok ukur Anda dalam komunitas, kami dengan hangat mengundang Anda untuk menyumbangkannya ke CompassHub. Anda dapat memulai proses pengiriman dengan mengklik di sini.

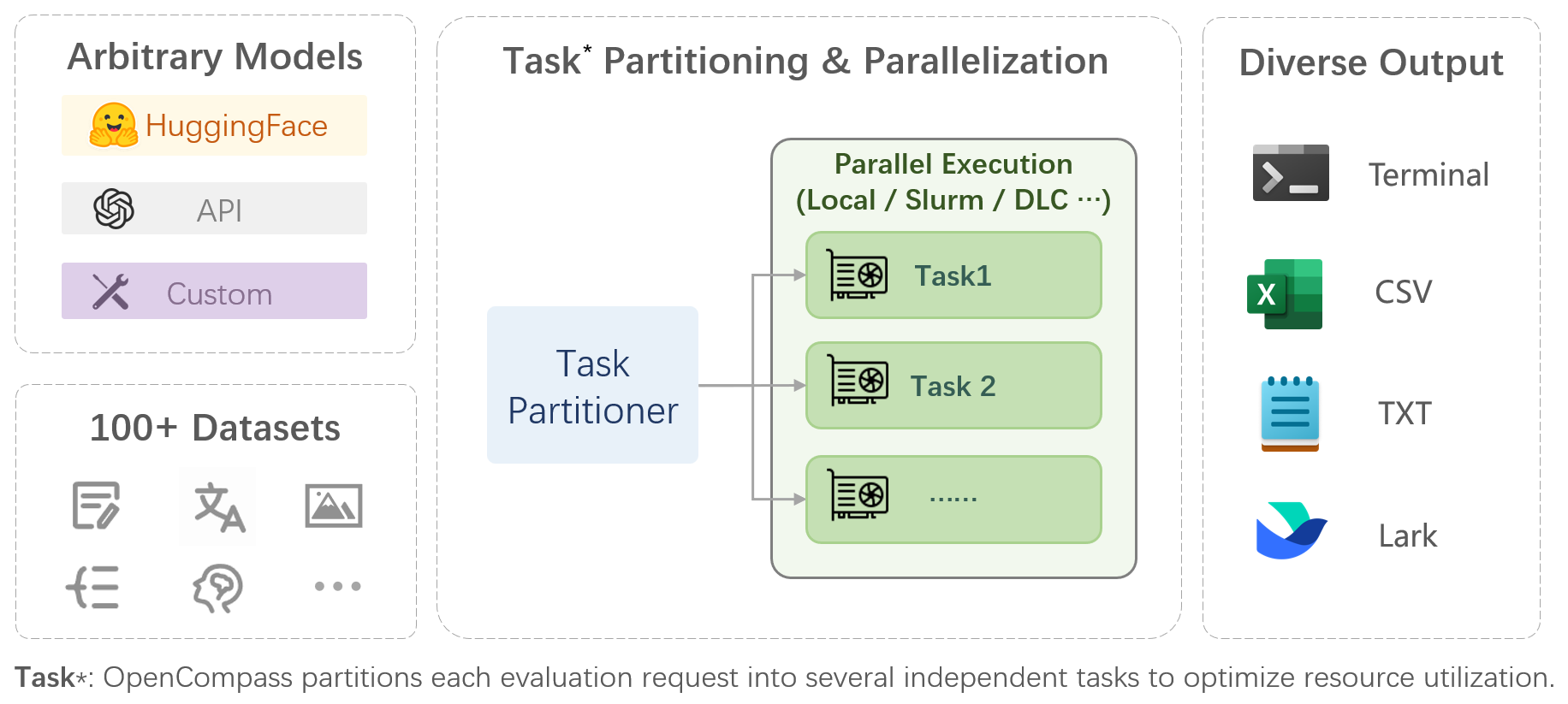

CompassKit adalah kumpulan perangkat evaluasi canggih yang dirancang khusus untuk Model Bahasa Besar dan Model Bahasa Visi Besar. Ini menyediakan seperangkat alat yang luas untuk menilai dan mengukur kinerja model kompleks ini secara efektif. Selamat mencoba perangkat kami untuk penelitian dan produk Anda.

OpenCompass adalah platform terpadu untuk evaluasi model besar, yang bertujuan untuk memberikan tolok ukur yang adil, terbuka, dan dapat direproduksi untuk evaluasi model besar. Fitur utamanya meliputi:

Dukungan komprehensif untuk model dan kumpulan data : Pra-dukungan untuk 20+ model HuggingFace dan API, skema evaluasi model dari 70+ kumpulan data dengan sekitar 400.000 pertanyaan, mengevaluasi kemampuan model secara komprehensif dalam lima dimensi.

Evaluasi terdistribusi yang efisien : Perintah satu baris untuk menerapkan pembagian tugas dan evaluasi terdistribusi, menyelesaikan evaluasi penuh model berskala miliar hanya dalam beberapa jam.

Paradigma evaluasi yang terdiversifikasi : Dukungan untuk evaluasi zero-shot, some-shot, dan chain-of-thinking, dikombinasikan dengan templat cepat standar atau tipe dialog, untuk dengan mudah menstimulasi kinerja maksimum berbagai model.

Desain modular dengan ekstensibilitas tinggi : Ingin menambahkan model atau kumpulan data baru, menyesuaikan strategi pembagian tugas tingkat lanjut, atau bahkan mendukung sistem manajemen cluster baru? Segala sesuatu tentang OpenCompass dapat diperluas dengan mudah!

Manajemen eksperimen dan mekanisme pelaporan : Gunakan file konfigurasi untuk mencatat setiap eksperimen secara lengkap, dan mendukung pelaporan hasil secara real-time.

| Bahasa | Pengetahuan | Pemikiran | Penyelidikan |

Definisi Kata

Pembelajaran Idiom

Kesamaan Semantik

Resolusi Intireferensi

Terjemahan

Menjawab Pertanyaan Multi-bahasa

Ringkasan Multi-bahasa

| Menjawab Pertanyaan Pengetahuan

| Keterikatan Tekstual

Penalaran Akal Sehat

Penalaran Matematis

Penerapan Teorema

Penalaran Komprehensif

| SMP, SMA, Universitas, Ujian Profesi

Pemeriksaan Kesehatan

|

| Memahami | Konteks Panjang | Keamanan | Kode |

Pemahaman Membaca

Ringkasan Konten

Analisis Konten

| Pemahaman Konteks Panjang

| Keamanan

Kekokohan

| Kode

|

| Model Sumber Terbuka | Model API |

|

|

Kembali ke atas

Evaluasi Subjektif

Rilis CompassAreana.

Evaluasi subyektif.

Konteks panjang

Evaluasi konteks panjang dengan kumpulan data yang luas.

Papan peringkat konteks panjang.

Pengkodean

Papan peringkat evaluasi pengkodean.

Layanan evaluasi bahasa non-python.

Agen

Mendukung berbagai kerangka agen.

Evaluasi penggunaan alat LLM.

Kekokohan

Mendukung berbagai metode serangan.

Kami menghargai semua kontribusi untuk meningkatkan OpenCompass. Silakan merujuk ke pedoman kontribusi untuk praktik terbaik.

Beberapa kode dalam proyek ini dikutip dan dimodifikasi dari OpenICL.

Beberapa kumpulan data dan implementasi cepat dimodifikasi dari pusat rantai pemikiran dan evaluasi instruksi.

@misc{2023opencompass, title={OpenCompass: Platform Evaluasi Universal untuk Model Fondasi}, author={Kontributor OpenCompass}, howpublished = {url{https://github.com/open-compass/opencompass}}, year={ 2023}}Kembali ke atas