5/8/2024 : Perbarui kode inferensi GPT-3.5 dan LLama2 serta hasil untuk Gambar 6, yang menunjukkan munculnya sifat sinergi kognitif.3/15/2024 : Makalah ini telah diterima sebagai makalah konferensi utama di NAACL2024! pip install -r requirements.txt

config_template.sh dan jalankan source config_template.sh untuk menyiapkan variabel env (Perhatikan bahwa kami menggunakan Azure API dalam eksperimen kami) Kami menyediakan skrip yang berjalan untuk masing-masing dari tiga tugas, silakan periksa komentar di skrip ".sh" untuk informasi lebih lanjut:

bash scripts/trivia_creative_writing.shbash scripts/codenames_collaborative.shbash scripts/logic_grid_puzzle.sh Semua petunjuk dapat ditemukan di folder prompts/ .

Semua kumpulan data dapat ditemukan di folder data/ .

Hasil eksperimen dalam makalah untuk setiap tugas dapat ditemukan di folder logs/ . gpt4_w_sys_mes dan gpt4_wo_sys_mes berisi hasil yang sesuai dengan Tabel 2 di makalah kami. Kami juga menyertakan hasil gpt-3.5 dan llama2-13b yang sesuai dengan hasil pada Gambar 6, dengan hyperparameter, seperti menambahkan pesan sistem atau tidak, mengikuti pilihan berkinerja terbaik dalam eksperimen gpt4.

"test_output_infos" : berisi metrik evaluasi untuk setiap contoh, misalnya, # jawaban yang benar disebutkan."*raw_responses" : respons mentah dari setiap panggilan API."*parsing_flag" : apakah respons mentah berhasil diurai. (untuk tugas Nama Kode, bidang ini dipisahkan menjadi "parsing_success_flag_spymaster" dan "parsing_success_flag_guesser")"unwrapped_output" : keluaran yang diuraikan yang akan digunakan untuk menghitung metrik evaluasi. (untuk tugas Nama Kode, bidang ini dipisahkan menjadi "spymaster_output" dan "guesser_output"; ada bidang tambahan bernama "hint_word" yang diuraikan dari keluaran spymaster dan dimasukkan ke dalam masukan Penebak; metrik evaluasi dihitung berdasarkan " penebak_output")"task data" : data untuk contoh tugas saat ini, misalnya pertanyaan, jawaban, kata target, dll."usage" : mencatat jumlah token dan biaya yang dikeluarkan sejauh ini.Silakan kutip makalahnya dan beri bintang pada repo ini jika menurut Anda karya ini menarik/bermanfaat.

@article{wang2023unleashing,

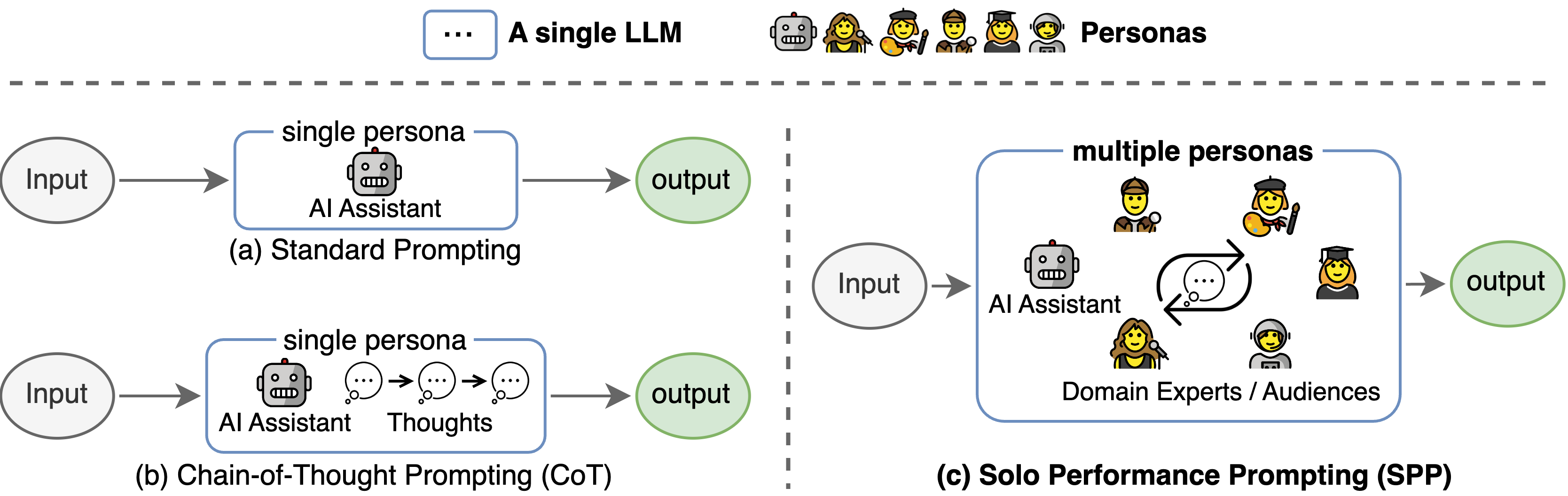

title={Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration},

author={Wang, Zhenhailong and Mao, Shaoguang and Wu, Wenshan and Ge, Tao and Wei, Furu and Ji, Heng},

journal={arXiv preprint arXiv:2307.05300},

year={2023}

}

Basis kode ini mereferensikan struktur repo resmi Pohon Pemikiran. Kami berterima kasih kepada penulis atas upaya open source mereka.