Ngobrol dengan dokumen Anda secara offline menggunakan AI. Tidak ada data yang keluar dari sistem Anda. Koneksi internet hanya diperlukan untuk menginstal alat dan mengunduh model AI. Ini didasarkan pada PrivateGPT tetapi memiliki lebih banyak fitur.

Isi

chatdocs.yml| Perpanjangan | Format |

|---|---|

.csv | CSV |

.docx , .doc | Dokumen Kata |

.enex | EverNote |

.eml | |

.epub | EPub |

.html | HTML |

.md | Penurunan harga |

.msg | Pesan Outlook |

.odt | Buka Teks Dokumen |

.pdf | Format Dokumen Portabel (PDF) |

.pptx , .ppt | Dokumen PowerPoint |

.txt | File teks (UTF-8) |

Instal alat menggunakan:

pip install chatdocsUnduh model AI menggunakan:

chatdocs downloadSekarang bisa dijalankan secara offline tanpa koneksi internet.

Tambahkan direktori yang berisi dokumen untuk diajak ngobrol menggunakan:

chatdocs add /path/to/documentsDokumen yang diproses akan disimpan di direktori

dbsecara default.

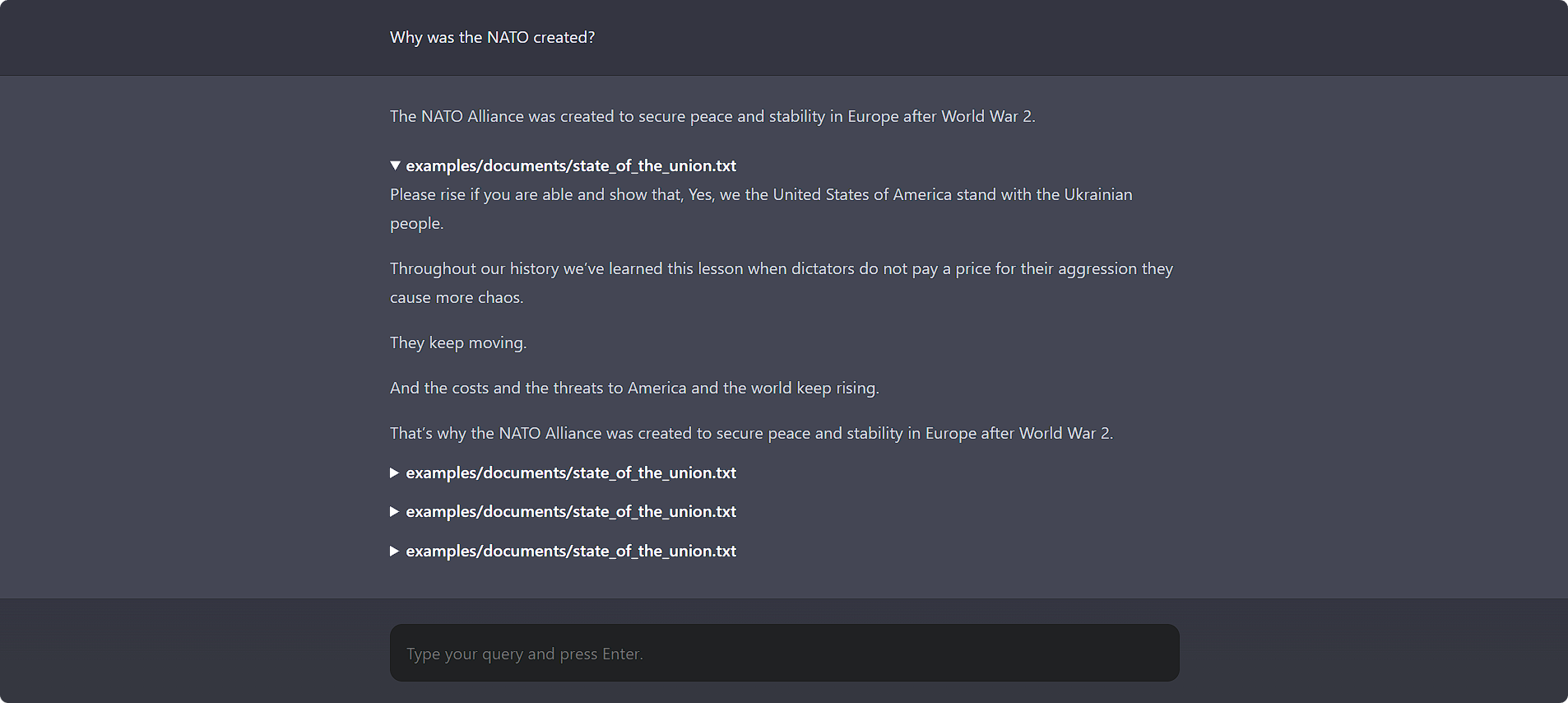

Ngobrol dengan dokumen Anda menggunakan:

chatdocs uiBuka http://localhost:5000 di browser Anda untuk mengakses UI web.

Ini juga memiliki antarmuka baris perintah yang bagus:

chatdocs chat

Semua opsi konfigurasi dapat diubah menggunakan file konfigurasi chatdocs.yml . Buat file chatdocs.yml di beberapa direktori dan jalankan semua perintah dari direktori itu. Untuk referensi, lihat file chatdocs.yml default.

Anda tidak perlu menyalin seluruh file, cukup tambahkan opsi konfigurasi yang ingin Anda ubah karena akan digabungkan dengan konfigurasi default. Misalnya, lihat tests/fixtures/chatdocs.yml yang hanya mengubah beberapa opsi konfigurasi.

Untuk mengubah model penyematan, tambahkan dan ubah yang berikut ini di chatdocs.yml Anda :

embeddings :

model : hkunlp/instructor-largeCatatan: Saat Anda mengubah model penyematan, hapus direktori

dbdan tambahkan dokumen lagi.

Untuk mengubah model CTransformers (GGML/GGUF), tambahkan dan ubah yang berikut ini di chatdocs.yml Anda :

ctransformers :

model : TheBloke/Wizard-Vicuna-7B-Uncensored-GGML

model_file : Wizard-Vicuna-7B-Uncensored.ggmlv3.q4_0.bin

model_type : llamaCatatan: Saat Anda menambahkan model baru untuk pertama kalinya, jalankan

chatdocs downloaduntuk mengunduh model sebelum menggunakannya.

Anda juga dapat menggunakan file model lokal yang ada:

ctransformers :

model : /path/to/ggml-model.bin

model_type : llama Untuk menggunakan? Model Transformers, tambahkan yang berikut ke chatdocs.yml Anda :

llm : huggingface Untuk mengubah? Model Transformers, tambahkan dan ubah yang berikut ini di chatdocs.yml Anda :

huggingface :

model : TheBloke/Wizard-Vicuna-7B-Uncensored-HFCatatan: Saat Anda menambahkan model baru untuk pertama kalinya, jalankan

chatdocs downloaduntuk mengunduh model sebelum menggunakannya.

Untuk menggunakan model GPTQ dengan ? Transformers, instal paket yang diperlukan menggunakan:

pip install chatdocs[gptq] Untuk mengaktifkan dukungan GPU (CUDA) pada model penyematan, tambahkan kode berikut ke chatdocs.yml Anda :

embeddings :

model_kwargs :

device : cudaAnda mungkin harus menginstal ulang PyTorch dengan CUDA diaktifkan dengan mengikuti petunjuk di sini.

Untuk mengaktifkan dukungan GPU (CUDA) untuk model CTransformers (GGML/GGUF), tambahkan yang berikut ke chatdocs.yml Anda :

ctransformers :

config :

gpu_layers : 50Anda mungkin harus menginstal perpustakaan CUDA menggunakan:

pip install ctransformers[cuda] Untuk mengaktifkan dukungan GPU (CUDA) untuk ? Model Transformers, tambahkan yang berikut ke chatdocs.yml Anda :

huggingface :

device : 0Anda mungkin harus menginstal ulang PyTorch dengan CUDA diaktifkan dengan mengikuti petunjuk di sini.

MIT