Melihat kembali proses pembelajaran di masa lalu, video guru Ng Enda dan Li Hongyi telah sangat membantu saya dalam perjalanan pembelajaran mendalam saya. Metode penjelasan mereka yang lucu dan penjelasan yang sederhana dan intuitif membuat pembelajaran teori yang membosankan menjadi hidup dan menarik.

Namun dalam praktiknya, banyak siswa yang pada awalnya khawatir tentang cara mendapatkan API model asing yang besar. Meskipun pada akhirnya mereka dapat menemukan solusi, ketakutan akan kesulitan untuk pertama kalinya akan selalu menunda kemajuan pembelajaran dan secara bertahap berubah dari "hanya menonton video". Saya sering melihat diskusi serupa di area komentar, jadi saya memutuskan untuk menggunakan waktu luang saya untuk membantu siswa melewati ambang batas ini. Ini juga merupakan tujuan awal dari proyek ini.

Proyek ini tidak akan memberikan tutorial tentang akses Internet ilmiah, juga tidak akan bergantung pada antarmuka yang disesuaikan dengan platform. Sebaliknya, proyek ini akan menggunakan OpenAI SDK yang lebih kompatibel untuk membantu semua orang mempelajari lebih banyak pengetahuan umum.

Proyek ini akan dimulai dengan panggilan API sederhana dan secara bertahap membawa Anda ke dunia model besar. Dalam prosesnya, Anda akan menguasai keterampilan seperti peringkasan video AI , penyesuaian LLM , dan pembuatan gambar AI .

Sangat disarankan untuk menonton kursus "Pengantar Kecerdasan Buatan Generatif" Guru Li Hongyi untuk pembelajaran simultan: akses cepat ke tautan terkait kursus

Sekarang, proyek ini juga menawarkan CodePlayground. Anda dapat mengonfigurasi lingkungan sesuai dengan dokumentasi, menjalankan skrip dengan satu baris kode, dan merasakan pesona AI.

?Esai tesis ditempatkan di PaperNotes, dan makalah dasar terkait model besar akan diunggah secara bertahap.

Gambar dasar sudah siap. Jika Anda belum mengonfigurasi lingkungan pembelajaran mendalam Anda sendiri, Anda sebaiknya mencoba Docker.

Semoga perjalanan anda menyenangkan!

--- : Pengetahuan dasar, tonton seperlunya, atau lewati sementara. Hasil file kode akan ditampilkan pada artikel, namun tetap disarankan untuk menjalankan kode secara manual. Mungkin ada persyaratan memori video.API : Artikel hanya menggunakan API model besar, tidak tunduk pada batasan perangkat, dan dapat dijalankan tanpa GPU.LLM : Latihan yang berkaitan dengan model bahasa besar, file kode mungkin memiliki persyaratan memori video.SD : Difusi Stabil, praktik yang berkaitan dengan diagram Vinsensian, dan file kode memiliki persyaratan memori video.File dan efek pembelajarannya akan sama.Setting -> Accelerator ->选择GPU .代码执行程序->更改运行时类型->选择GPU .| Memandu | Menandai | Menggambarkan | Mengajukan | On line |

|---|---|---|---|---|

| 00. Langkah-Langkah Mendapatkan API Model Besar Alibaba | API | Kami akan memandu Anda langkah demi langkah untuk mendapatkan API. Jika baru pertama kali mendaftar, Anda perlu melakukan verifikasi identitas (pengenalan wajah). | ||

| 01. Pengenalan pertama ke LLM API: konfigurasi lingkungan dan demonstrasi dialog multi-putaran | API | Ini adalah konfigurasi pengantar dan demonstrasi. Kode percakapan dimodifikasi dari dokumen pengembangan Alibaba. | Kode | Kaggle Kolaborasi |

| 02. Mudah untuk memulai: Bangun aplikasi AI melalui API dan Gradio | API | Panduan cara menggunakan Gradio untuk membangun aplikasi AI sederhana. | Kode | Kolaborasi |

| 03. Panduan lanjutan: Sesuaikan Prompt untuk meningkatkan kemampuan pemecahan masalah model besar | API | Anda akan belajar menyesuaikan Prompt untuk meningkatkan kemampuan model besar dalam memecahkan masalah matematika. Versi Gradio dan non-Gradio juga akan disediakan, dan detail kode akan ditampilkan. | Kode | Kaggle Kolaborasi |

| 04. Memahami LoRA: dari lapisan linier hingga mekanisme perhatian | --- | Sebelum resmi memasuki praktik, Anda perlu mengetahui konsep dasar LoRA. Artikel ini akan membawa Anda mulai dari implementasi LoRA lapisan linier hingga mekanisme perhatian. | ||

05. Memahami seri AutoModel Hugging Face: kelas pemuatan model otomatis untuk berbagai tugas | --- | Modul yang akan kita gunakan adalah AutoModel dalam Memeluk Wajah. Artikel ini juga merupakan pengetahuan prasyarat (tentu saja Anda dapat melewatinya dan membacanya nanti jika Anda ragu). | Kode | Kaggle Kolaborasi |

| 06. Memulai: terapkan model bahasa pertama Anda | LLM | Menerapkan penerapan model bahasa yang sangat dasar, proyek ini tidak memiliki persyaratan keras untuk GPU sejauh ini, Anda dapat terus mempelajarinya. | Kode app_fastapi.py app_flask.py | |

| 07. Jelajahi hubungan antara parameter model dan memori video serta dampak akurasi yang berbeda | --- | Memahami korespondensi antara parameter model dan memori video serta menguasai metode impor dengan presisi berbeda akan membuat pemilihan model Anda lebih terampil. | ||

| 08. Cobalah untuk menyempurnakan LLM: biarkan ia menulis puisi Tang | LLM | Artikel ini sama dengan 03. Panduan Lanjutan: Menyesuaikan Prompt untuk Meningkatkan Kemampuan Pemecahan Masalah Model Besar. Ini pada dasarnya berfokus pada "menggunakan" daripada "menulis". bagian hyperparameter untuk melihat dampaknya pada penyesuaian. | Kode | Kaggle Kolaborasi |

| 09. Pemahaman mendalam tentang Beam Search: prinsip, contoh dan implementasi kode | --- | Mulai dari contoh hingga demonstrasi kode, menjelaskan matematika Beam Search, ini akan menghilangkan beberapa kebingungan dari bacaan sebelumnya, dan akhirnya memberikan contoh sederhana penggunaan perpustakaan Hugging Face Transformers (Anda dapat mencobanya jika Anda melewatkan artikel sebelumnya) . | Kode | Kaggle Kolaborasi |

| 10. Top-K vs Top-P: Strategi pengambilan sampel dan pengaruh Suhu dalam model generatif | --- | Selanjutnya untuk menunjukkan kepada Anda strategi generasi lainnya. | Kode | Kaggle Kolaborasi |

| 11. Contoh penyempurnaan DPO: Mengoptimalkan model bahasa besar LLM sesuai dengan preferensi manusia | LLM | Contoh fine tuning menggunakan DPO. | Kode | Kaggle Kolaborasi |

| 12. Atribusi fitur Inseq: menafsirkan secara visual keluaran LLM | LLM | Contoh visual tugas penerjemahan dan pembuatan teks (mengisi bagian yang kosong). | Kode | Kaggle Kolaborasi |

| 13. Memahami kemungkinan bias dalam AI | LLM | Tidak diperlukan pemahaman tentang kode, dan ini dapat digunakan sebagai eksplorasi yang menyenangkan di waktu senggang. | Kode | Kaggle Kolaborasi |

| 14. PEFT: Menerapkan LoRA dengan cepat ke model besar | --- | Pelajari cara menambahkan lapisan LoRA setelah mengimpor model. | Kode | Kaggle Kolaborasi |

| 15. Gunakan API untuk menerapkan ringkasan video AI: Buat asisten video AI Anda sendiri | API & LLM | Anda akan mempelajari prinsip-prinsip di balik asisten ringkasan video AI yang umum dan mulai menerapkan ringkasan video AI. | Kode - versi lengkap Kode - versi Lite ?naskah | Kaggle Kolaborasi |

| 16. Gunakan LoRA untuk menyempurnakan Difusi Stabil: bongkar tungku alkimia dan terapkan lukisan AI pertama Anda | SD | Gunakan LoRA untuk menyempurnakan model diagram Vincent, dan sekarang Anda juga dapat memberikan file LoRA Anda kepada orang lain. | Kode Kode - versi Lite | Kaggle Kolaborasi |

| 17. Pembahasan singkat tentang kuantisasi model RTN: asimetris vs simetris.md | --- | Untuk lebih memahami perilaku kuantifikasi model RTN, artikel ini menggunakan INT8 sebagai contoh untuk menjelaskannya. | Kode | Kaggle Kolaborasi |

| 18. Ikhtisar teknologi kuantifikasi model dan analisis format file GGUF/GGML | --- | Ini adalah artikel ikhtisar yang mungkin dapat mengatasi beberapa keraguan Anda saat menggunakan GGUF/GGML. | ||

| 19a. Dari pemuatan hingga percakapan: menjalankan model besar LLM terkuantisasi (GPTQ & AWQ) secara lokal menggunakan Transformers 19b. Dari pemuatan hingga percakapan: menjalankan model besar LLM terkuantisasi (GGUF) secara lokal menggunakan Llama-cpp-python | LLM | Anda akan menerapkan model kuantitatif dengan 7 miliar (7B) parameter di komputer Anda. 19 a Menggunakan Transformers, melibatkan pemuatan model dalam format GPTQ dan AWQ. 19 b Menggunakan Llama-cpp-python, melibatkan pemuatan model dalam format GGUF. Selain itu, Anda juga akan menyelesaikan fungsi interaksi dialog model besar lokal. | Kode-Transformator Kode-Llama-cpp-python ?naskah | |

| 20. Praktek pengenalan RAG: dari pemisahan dokumen hingga database vektor dan konstruksi tanya jawab | LLM | praktik terkait RAG. Pelajari cara kerja pengelompokan teks rekursif. | Kode | |

| 21. BPE vs WordPiece: Memahami prinsip kerja Tokenizer dan metode segmentasi sub-kata | --- | Operasi dasar Tokenizer. Pelajari tentang metode segmentasi subkata yang umum: BPE dan WordPiece. Memahami masker perhatian (Attention Mask) dan ID tipe token (Token Type IDs). | Kode | Kaggle Kolaborasi |

| 22. Tugas - Bert menyempurnakan jawaban pertanyaan ekstraktif | Ini adalah tugas yang menggunakan BERT untuk menyempurnakan tugas tanya jawab hilir. Anda dapat mencobanya dan mencoba mengikuti "kompetisi" Kaggle. Artikel panduan dengan semua tips akan diberikan setelah seminggu atau tinggalkan untuk nanti. Artikel pengantar tidak akan membahas deskripsi tugas, dan dua versi kode akan diunggah untuk pembelajaran, jadi jangan khawatir. Tidak akan ada tenggat waktu di sini. | Kode - Tugas | Kaggle Kolaborasi |

Tip

Jika Anda lebih suka menarik gudang untuk membaca .md secara lokal, maka ketika terjadi kesalahan rumus, silakan gunakan Ctrl+F atau Command+F , cari \_ dan ganti semua dengan _ .

Bacaan lebih lanjut:

| Memandu | Menggambarkan |

|---|---|

| a. Gunakan HFD untuk mempercepat pengunduhan model dan kumpulan data Hugging Face | Jika Anda merasa pengunduhan model terlalu lambat, Anda dapat merujuk ke artikel ini untuk konfigurasi. Jika Anda mengalami kesalahan 443 terkait proxy, Anda juga dapat mencoba membaca artikel ini. |

| b. Pemeriksaan cepat perintah baris perintah dasar (berlaku untuk Linux/Mac) | Pemeriksaan cepat perintah baris perintah pada dasarnya berisi semua perintah yang terlibat di gudang saat ini. |

| c. Solusi untuk beberapa masalah | Di sini kami akan memecahkan beberapa masalah yang mungkin dihadapi selama pengoperasian proyek. - Bagaimana cara menarik gudang jarak jauh untuk menimpa semua modifikasi lokal? - Bagaimana cara melihat dan menghapus file yang diunduh oleh Hugging Face, dan bagaimana cara mengubah jalur penyimpanan? |

| d.Cara memuat model GGUF (solusi untuk Shared/Shared/Split/00001-of-0000...) | - Pelajari fitur baru Transformers tentang GGUF. - Gunakan Transformers/Llama-cpp-python/Ollama untuk memuat file model dalam format GGUF. - Belajar menggabungkan file GGUF yang terfragmentasi. - Selesaikan masalah LLama-cpp-python yang tidak dapat diturunkan. |

| e.Peningkatan data: analisis metode umum torchvision.transforms | - Memahami metode peningkatan data gambar yang umum digunakan. Kode |.Kaggle | |

| f. Fungsi kerugian lintas-entropi nn.CrossEntropyLoss() penjelasan rinci dan pengingat poin-poin penting (PyTorch) | - Memahami prinsip matematika kerugian lintas entropi dan implementasi PyTorch. - Pelajari apa yang harus diperhatikan saat menggunakannya untuk pertama kali. |

| g. Lapisan penyematan nn.Embedding() penjelasan rinci dan pengingat poin-poin penting (PyTorch) | - Memahami konsep penyematan lapisan dan penyematan kata. - Visualisasikan Penyematan menggunakan model terlatih. Kode |.Kaggle | |

| h. Gunakan Docker untuk mengonfigurasi lingkungan pembelajaran mendalam (Linux) dengan cepat h. Pengenalan perintah dasar Docker dan resolusi kesalahan umum | - Gunakan dua baris perintah untuk mengonfigurasi lingkungan pembelajaran mendalam - Pengenalan perintah dasar Docker - Selesaikan tiga kesalahan umum saat digunakan |

Penjelasan map:

Demo

Semua file kode akan disimpan di sana.

data

Folder ini tidak perlu diperhatikan untuk menyimpan data kecil yang mungkin digunakan dalam kode.

GenAI_PDF

Berikut adalah file PDF tugas mata kuliah [Pengantar Kecerdasan Buatan Generatif] yang saya upload karena aslinya disimpan di Google Drive.

Memandu

Semua dokumen panduan akan disimpan di sana.

aktiva

Berikut adalah gambar yang digunakan dalam file .md. Tidak perlu memperhatikan folder ini.

Catatan Kertas

Esai Tesis.

Taman Bermain Kode

Beberapa contoh skrip kode yang menarik (versi Mainan).

README.md

ringkasan.py ?skrip

Rangkuman video/audio/subtitel AI.

chat.py ?skrip

Percakapan AI.

Pengantar Sumber Belajar Kecerdasan Buatan Generatif

Halaman beranda kursus

Resmi |. Video resmi: YouTube |

Produksi dan pembagian versi cermin Tiongkok telah disetujui oleh guru Li Hongyi. Terima kasih kepada guru atas berbagi pengetahuan tanpa pamrih Anda!

Gambar PS berbahasa Mandarin akan sepenuhnya mewujudkan semua fungsi kode pekerjaan (operasi lokal). Kaggle adalah platform online yang dapat terhubung langsung di Tiongkok. Konten Colab Tiongkok dan Kaggle konsisten. Tautan Colab berbahasa Inggris sesuai dengan pekerjaan aslinya. Pilih saja salah satunya untuk menyelesaikan studi.

Sesuai dengan kebutuhan sebenarnya, pilih metode dari bawah untuk mempersiapkan lingkungan belajar, klik ► atau teks untuk memperluas .

Kaggle (koneksi langsung domestik, disarankan): Baca artikel "Kaggle: Panduan Penggunaan GPU Gratis, Alternatif Ideal untuk Colab" untuk mempelajari lebih lanjut.

Colab (membutuhkan akses Internet ilmiah)

File kode dalam proyek disinkronkan pada kedua platform.

Linux (Ubuntu) :

sudo apt-get update

sudo apt-get install gitmacOS :

Instal Homebrew terlebih dahulu:

/bin/bash -c " $( curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh ) "Kemudian jalankan:

brew install gitjendela :

Unduh dan instal dari Git untuk Windows.

Linux (Ubuntu) :

sudo apt-get update

sudo apt-get install wget curlmacOS :

brew install wget curljendela :

Unduh dan instal dari situs web resmi Wget untuk Windows dan Curl.

Kunjungi situs resmi Anaconda, masukkan alamat email Anda dan periksa email Anda.

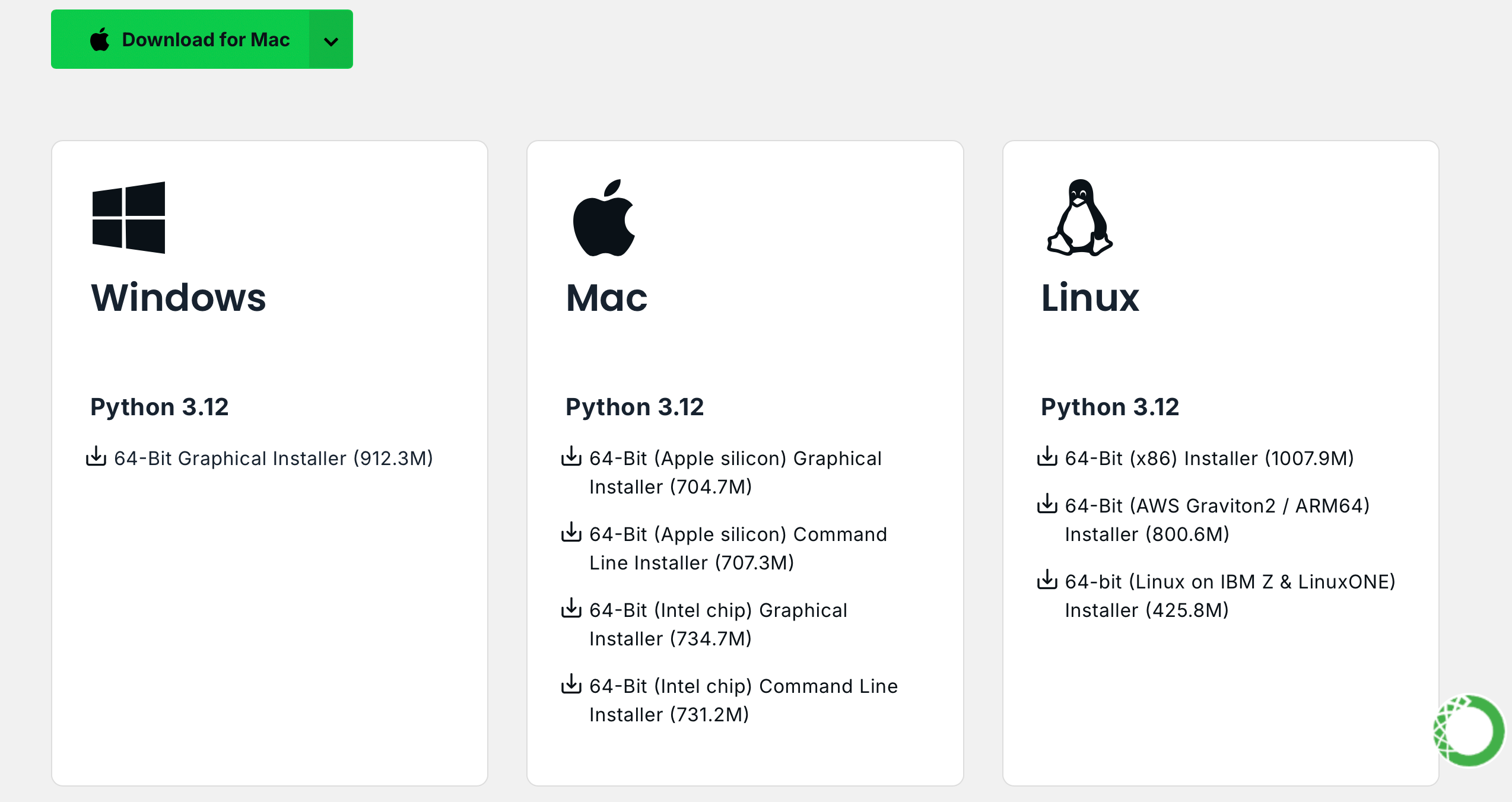

Klik Download Now , pilih versi yang sesuai dan unduh (tersedia Anaconda dan Miniconda):

Linux (Ubuntu) :

Instal Anaconda

Kunjungi repo.anaconda.com untuk pemilihan versi.

# 下载 Anaconda 安装脚本(以最新版本为例)

wget https://repo.anaconda.com/archive/Anaconda3-2024.10-1-Linux-x86_64.sh

# 运行安装脚本

bash Anaconda3-2024.10-1-Linux-x86_64.sh

# 按照提示完成安装(先回车,空格一直翻页,翻到最后输入 yes,回车)

# 安装完成后,刷新环境变量或者重新打开终端

source ~ /.bashrcInstal Miniconda (disarankan)

Kunjungi repo.anaconda.com/miniconda untuk pemilihan versi. Miniconda adalah versi sederhana dari Anaconda, hanya berisi Conda dan Python.

# 下载 Miniconda 安装脚本

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

# 运行安装脚本

bash Miniconda3-latest-Linux-x86_64.sh

# 按照提示完成安装(先回车,空格一直翻页,翻到最后输入 yes,回车)

# 安装完成后,刷新环境变量或者重新打开终端

source ~ /.bashrcmacOS :

Sejalan dengan itu, ganti URL di perintah Linux.

Instal Anaconda

Kunjungi repo.anaconda.com untuk pemilihan versi.

Instal Miniconda (disarankan)

Kunjungi repo.anaconda.com/miniconda untuk pemilihan versi.

Masukkan perintah berikut di terminal. Jika informasi versi ditampilkan, instalasi berhasil.

conda --versioncat << ' EOF ' > ~/.condarc

channels:

- defaults

show_channel_urls: true

default_channels:

- https://mirror.nju.edu.cn/anaconda/pkgs/main

- https://mirror.nju.edu.cn/anaconda/pkgs/r

- https://mirror.nju.edu.cn/anaconda/pkgs/msys2

custom_channels:

conda-forge: https://mirror.nju.edu.cn/anaconda/cloud

pytorch: https://mirror.nju.edu.cn/anaconda/cloud

EOF[!catatan]

Banyak sumber mirror yang tersedia tahun lalu tidak lagi tersedia. Untuk konfigurasi situs mirror lainnya saat ini, Anda dapat merujuk ke dokumen yang sangat bagus ini dari NTU: Mirror Usage Help.

Catatan : Jika Anaconda atau Miniconda sudah terinstal, pip akan disertakan dalam sistem dan tidak diperlukan instalasi tambahan.

Linux (Ubuntu) :

sudo apt-get update

sudo apt-get install python3-pipmacOS :

brew install python3jendela :

Unduh dan instal Python, pastikan opsi "Tambahkan Python ke PATH" dicentang.

Buka prompt perintah dan masukkan:

python -m ensurepip --upgradeMasukkan perintah berikut di terminal. Jika informasi versi ditampilkan, instalasi berhasil.

pip --versionpip config set global.index-url https://mirrors.aliyun.com/pypi/simpleTarik proyek dengan perintah berikut:

git clone https://github.com/Hoper-J/AI-Guide-and-Demos-zh_CN.git

cd AI-Guide-and-Demos-zh_CNTidak ada batasan untuk versinya, bisa lebih tinggi:

conda create -n aigc python=3.9 Tekan y dan enter untuk melanjutkan. Setelah pembuatan selesai, aktifkan lingkungan virtual:

conda activate aigcSelanjutnya, Anda perlu menginstal dependensi dasar. Lihat situs web resmi PyTorch, dengan mengambil CUDA 11.8 sebagai contoh (jika kartu grafis tidak mendukung 11.8, Anda perlu mengubah perintah), pilih salah satu dari dua untuk menginstal:

# pip

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

# conda

conda install pytorch torchvision torchaudio pytorch-cuda=11.8 -c pytorch -c nvidiaSekarang kita telah berhasil mengkonfigurasi semua lingkungan yang diperlukan dan siap untuk mulai belajar :) Dependensi yang tersisa akan dicantumkan secara terpisah di setiap artikel.

[!catatan]

Gambar Docker memiliki dependensi yang sudah diinstal sebelumnya, jadi tidak perlu menginstalnya kembali.

Instal pertama jupyter-lab , yang lebih mudah digunakan daripada jupyter notebook .

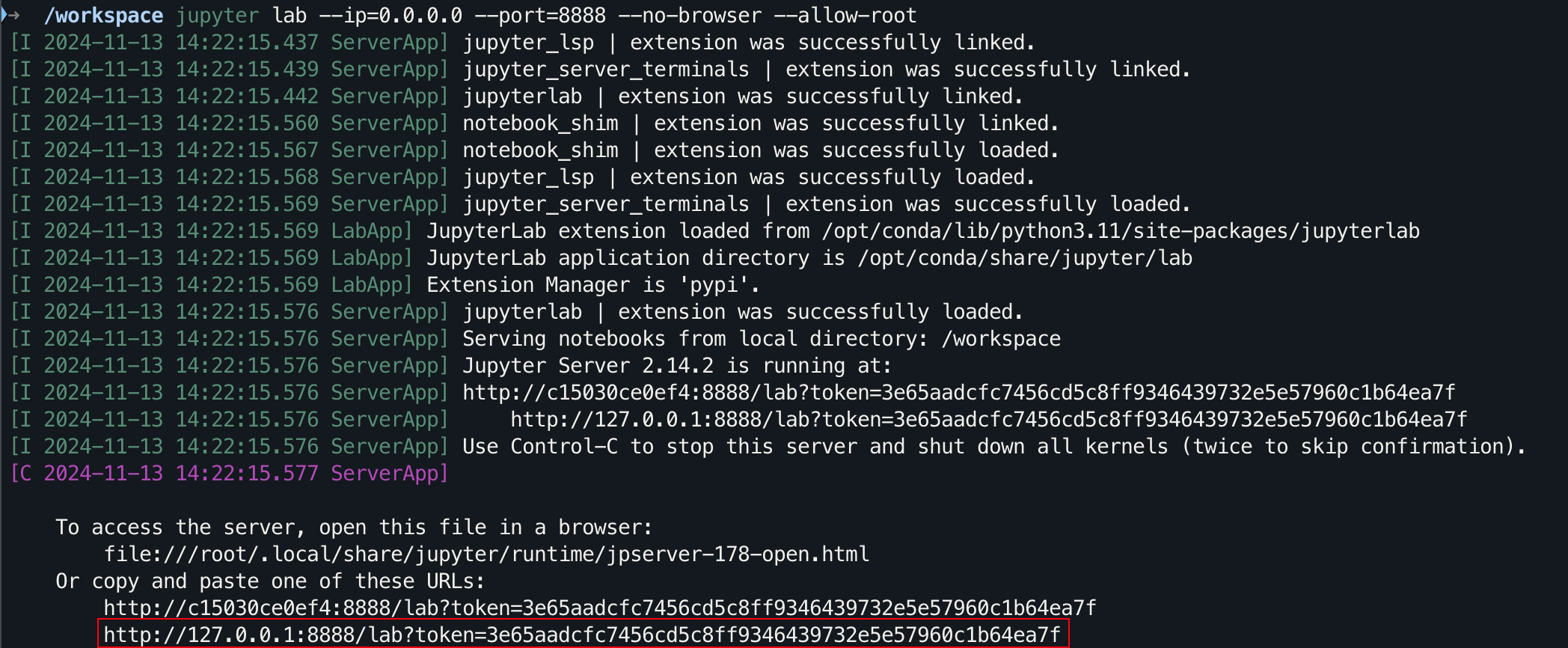

pip install jupyterlabSetelah instalasi selesai, jalankan perintah berikut:

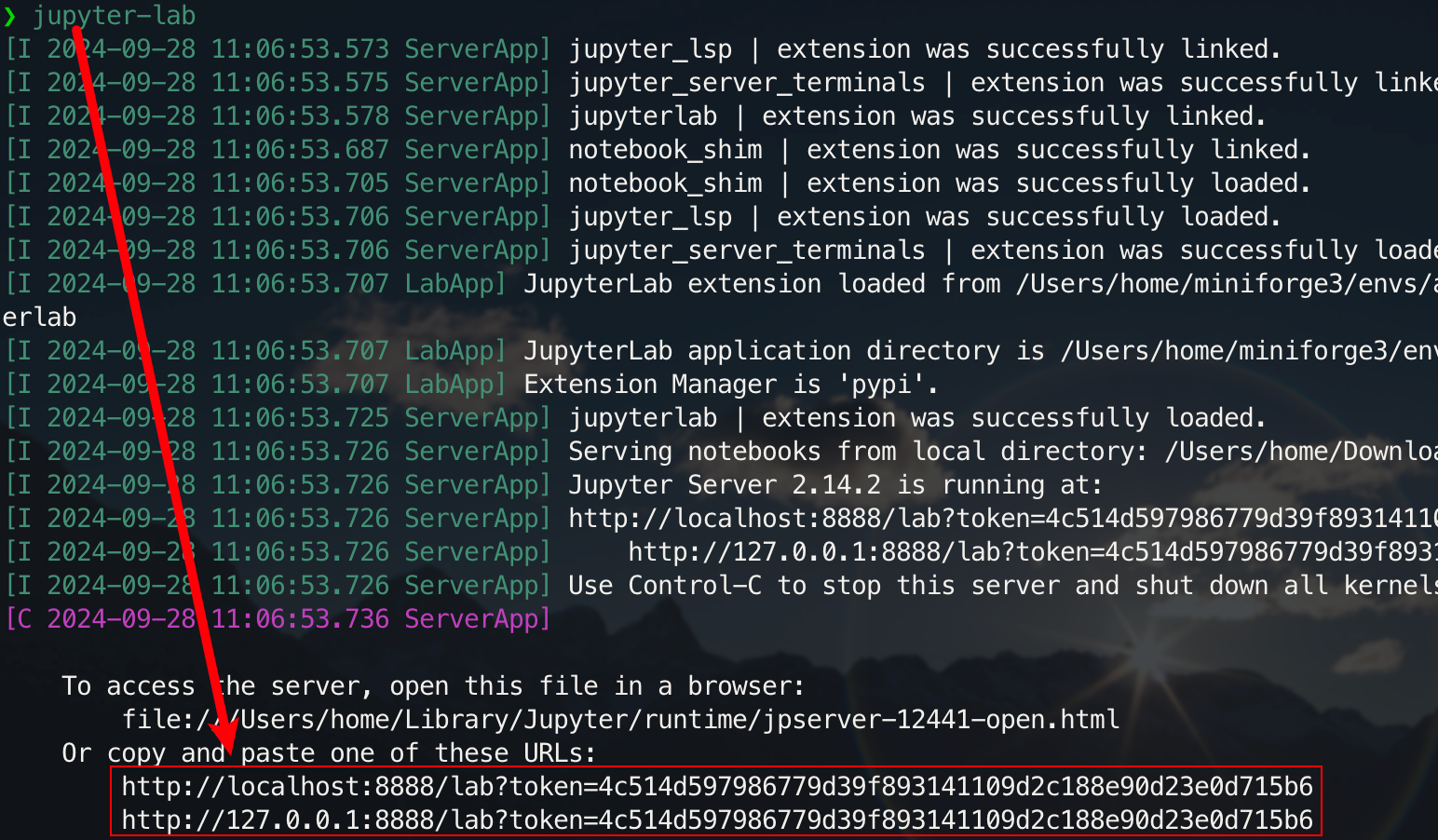

jupyter-lab

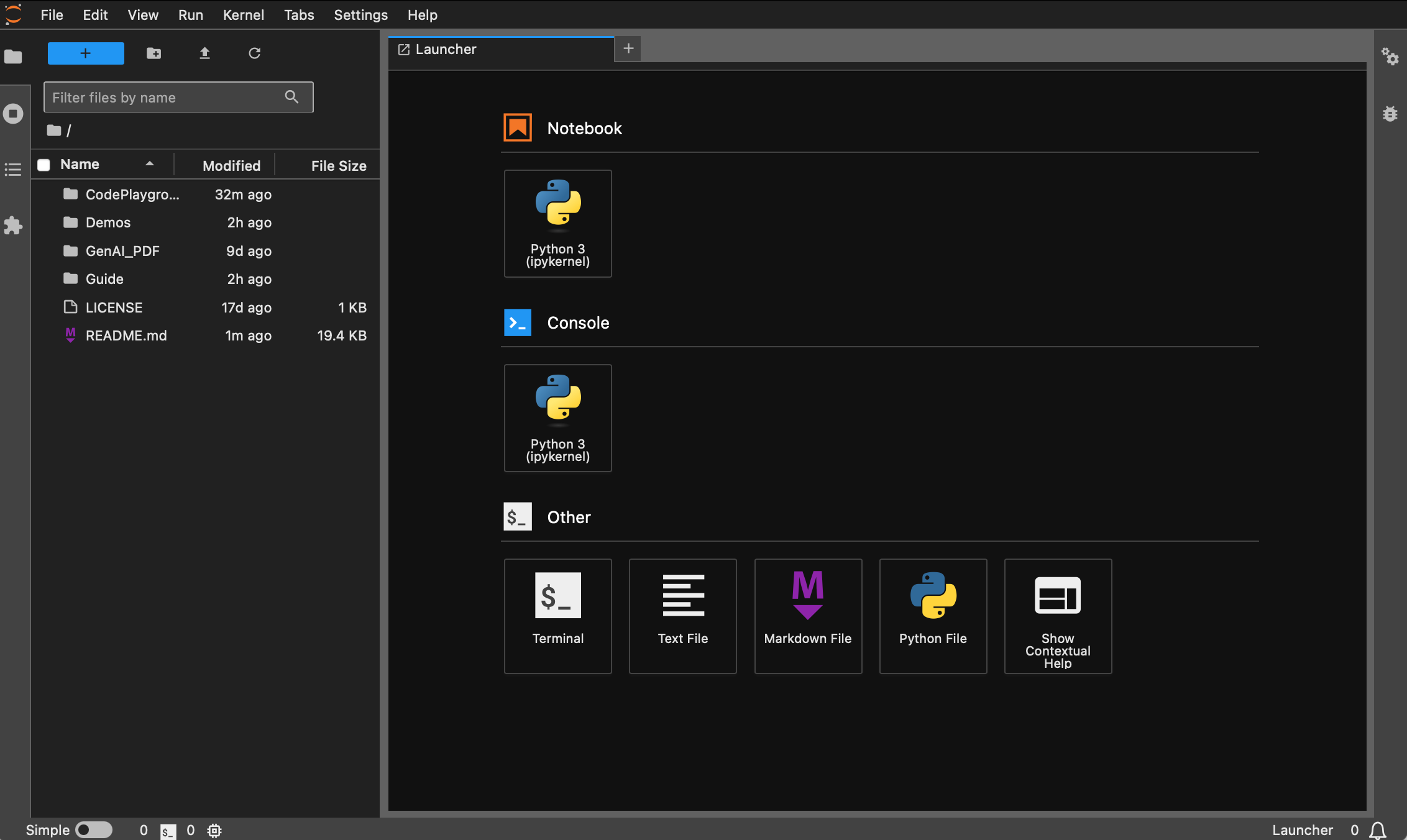

Sekarang Anda dapat mengaksesnya melalui tautan pop-up, biasanya terletak di port 8888. Untuk antarmuka grafis, tahan Ctrl di Windows/Linux, tahan Command di Mac, lalu klik tautan untuk langsung melompat. Pada titik ini, Anda akan mendapatkan gambaran lengkap tentang proyek tersebut:

Siswa yang belum menginstal Docker dapat membaca artikel "Gunakan Docker untuk mengkonfigurasi lingkungan pembelajaran mendalam (Linux) dengan cepat". Pemula disarankan untuk membaca "Pengantar perintah dasar Docker dan resolusi kesalahan umum".

Semua versi sudah diinstal sebelumnya dengan alat umum seperti sudo , pip , conda , wget , curl dan vim , dan sumber gambar domestik pip dan conda telah dikonfigurasi. Pada saat yang sama, ia mengintegrasikan zsh dan beberapa plug-in baris perintah praktis (pelengkapan otomatis perintah, penyorotan sintaksis, dan alat lompat direktori z ). Selain itu, jupyter notebook dan jupyter lab telah diinstal sebelumnya, dan terminal default disetel ke zsh untuk memfasilitasi pengembangan pembelajaran mendalam. Tampilan berbahasa Mandarin di penampung telah dioptimalkan untuk menghindari karakter yang kacau. Alamat cermin domestik Hugging Face juga telah dikonfigurasi sebelumnya.

pytorch/pytorch:2.5.1-cuda11.8-cudnn9-devel . Versi python default adalah 3.11.10. Versi ini dapat dimodifikasi secara langsung melalui conda install python==版本号.Instalasi yang tepat :

wget , curl : alat pengunduhan baris perintahvim , nano : editor teksgit : alat kontrol versigit-lfs : Git LFS (Penyimpanan File Besar)zip , unzip : alat kompresi dan dekompresi filehtop : alat pemantauan sistemtmux , screen : alat manajemen sesibuild-essential : alat kompilasi (seperti gcc , g++ )iputils-ping , iproute2 , net-tools : alat jaringan (menyediakan perintah seperti ping , ip , ifconfig , netstat , dll.)ssh : alat koneksi jarak jauhrsync : alat sinkronisasi filetree : Menampilkan pohon file dan direktorilsof : Melihat file yang sedang terbuka di sistemaria2 : alat pengunduhan multi-utaslibssl-dev : perpustakaan pengembangan OpenSSLinstalasi pip :

jupyter notebook , jupyter lab : lingkungan pengembangan interaktifvirtualenv : Alat manajemen lingkungan virtual Python, Anda dapat menggunakan conda secara langsungtensorboard : alat visualisasi pelatihan pembelajaran mendalamipywidgets : Pustaka widget Jupyter untuk menampilkan bilah kemajuan dengan benarPlugin :

zsh-autosuggestions : perintah pelengkapan otomatiszsh-syntax-highlighting : penyorotan sintaksisz : Lompat ke direktori dengan cepatVersi dl (Pembelajaran Mendalam) didasarkan pada basis dan juga menginstal alat dan pustaka dasar yang dapat digunakan dalam pembelajaran mendalam:

Instalasi yang tepat :

ffmpeg : alat pemrosesan audio dan videolibgl1-mesa-glx : Ketergantungan pustaka grafis (menyelesaikan beberapa masalah terkait grafis kerangka pembelajaran mendalam)instalasi pip :

numpy , scipy : perhitungan numerik dan perhitungan ilmiahpandas : analisis datamatplotlib , seaborn : visualisasi datascikit-learn : Alat pembelajaran mesintensorflow , tensorflow-addons : kerangka pembelajaran mendalam populer lainnyatf-keras : Implementasi TensorFlow pada antarmuka Kerastransformers , datasets : Alat NLP yang disediakan oleh Hugging Facenltk , spacy : alat pemrosesan bahasa alamiJika diperlukan perpustakaan tambahan, perpustakaan tersebut dapat diinstal secara manual dengan perintah berikut:

pip install --timeout 120 <替换成库名> Di sini --timeout 120 menetapkan batas waktu 120 detik untuk memastikan bahwa masih ada cukup waktu untuk instalasi meskipun jaringan buruk. Jika Anda tidak mengaturnya, Anda mungkin mengalami situasi di mana paket instalasi gagal karena waktu pengunduhan habis di lingkungan domestik.

Perhatikan bahwa semua gambar tidak akan ditarik ke gudang terlebih dahulu.

Dengan asumsi Anda telah menginstal dan mengkonfigurasi Docker, Anda hanya memerlukan dua baris perintah image_name:tag menyelesaikan konfigurasi lingkungan pembelajaran mendalam. Untuk proyek saat ini, Anda dapat membuat pilihan setelah melihat deskripsi versi berikut:

hoperj/quickstart:base-torch2.5.1-cuda11.8-cudnn9-develhoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-develPerintah tariknya adalah:

docker pull < image_name:tag >Berikut ini menggunakan versi dl sebagai contoh untuk mendemonstrasikan perintah.

docker pull dockerpull.org/hoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-develdocker pull hoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-develFile dapat diunduh melalui Baidu Cloud Disk (Alibaba Cloud Disk tidak mendukung berbagi file terkompresi berukuran besar).

File dengan nama yang sama memiliki konten yang sama.

.tar.gzadalah versi terkompresi. Setelah diunduh, dekompresi dengan perintah berikut:gzip -d dl.tar.gz

Dengan asumsi dl.tar diunduh ke ~/Downloads , lalu beralih ke direktori yang sesuai:

cd ~ /DownloadsKemudian memuat gambar:

docker load -i dl.tarDalam mode ini, container akan langsung menggunakan konfigurasi jaringan host, dan semua port sama dengan port host tanpa pemetaan terpisah. Jika Anda hanya perlu memetakan port tertentu, ganti

--network hostdengan-p port:port.

docker run --gpus all -it --name ai --network host hoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-devel /bin/zsh Untuk siswa yang perlu menggunakan proxy, tambahkan -e untuk mengatur variabel lingkungan Anda juga dapat merujuk ke artikel tambahan a:

Asumsikan nomor port HTTP/HTTPS proksi adalah 7890 dan SOCKS5 adalah 7891:

-e http_proxy=http://127.0.0.1:7890-e https_proxy=http://127.0.0.1:7890-e all_proxy=socks5://127.0.0.1:7891Terintegrasi ke dalam perintah sebelumnya:

docker run --gpus all -it

--name ai

--network host

-e http_proxy=http://127.0.0.1:7890

-e https_proxy=http://127.0.0.1:7890

-e all_proxy=socks5://127.0.0.1:7891

hoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-devel

/bin/zsh[!tip]

Lihat operasi umum sebelumnya :

- Mulai wadah :

docker start <容器名>- Jalankan wadah :

docker exec -it <容器名> /bin/zsh

- Keluar dari dalam wadah :

Ctrl + Datauexit.- Hentikan kontainer :

docker stop <容器名>- Hapus wadah :

docker rm <容器名>

git clone https://github.com/Hoper-J/AI-Guide-and-Demos-zh_CN.git

cd AI-Guide-and-Demos-zh_CNjupyter lab --ip=0.0.0.0 --port=8888 --no-browser --allow-root

Untuk antarmuka grafis, tahan Ctrl di Windows/Linux, tahan Command di Mac, lalu klik tautan untuk langsung melompat.

Terima kasih atas BINTANG Anda?, saya harap ini membantu.