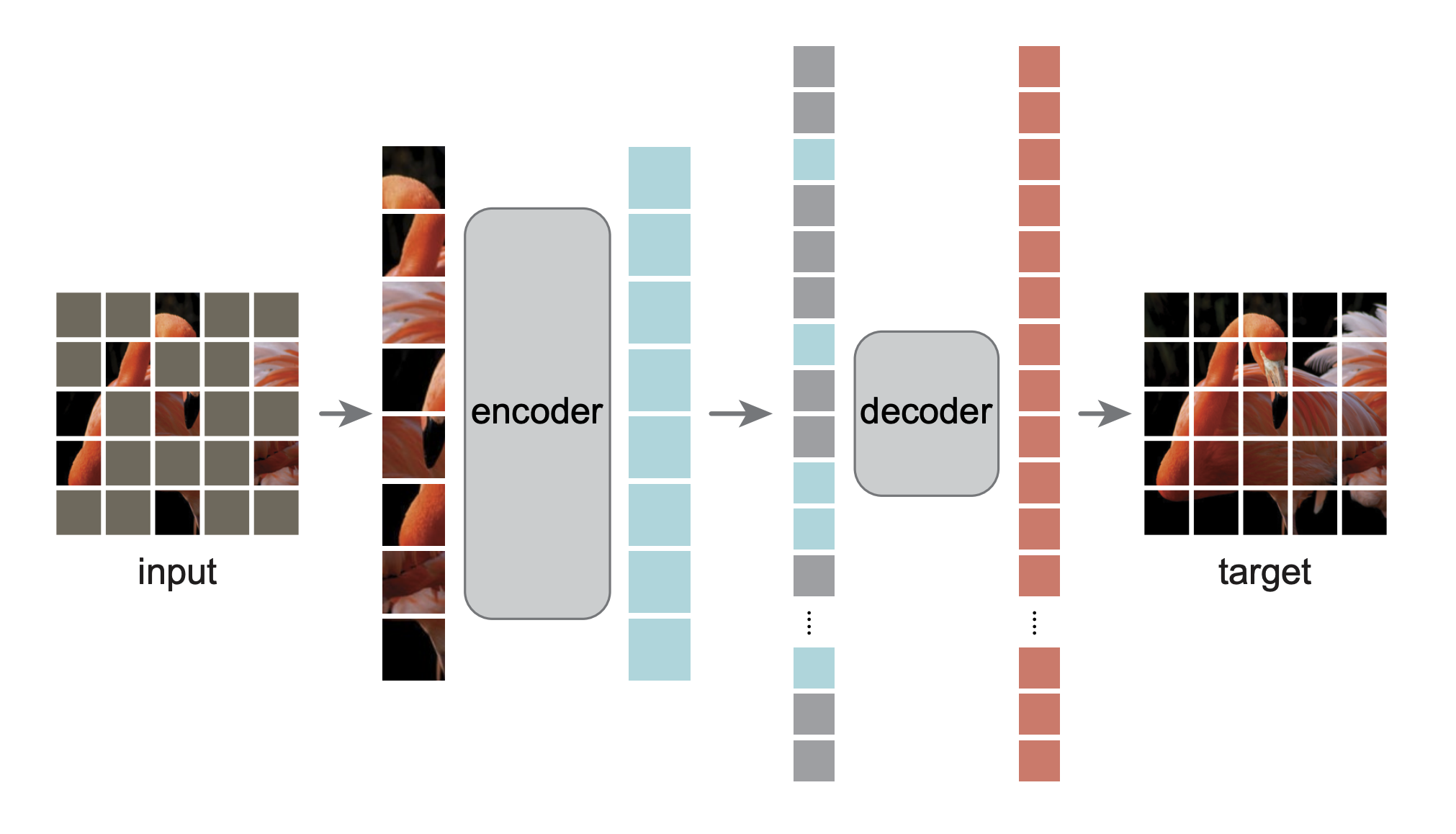

Ini adalah implementasi ulang PyTorch/GPU dari makalah Masked Autoencoders Are Scalable Vision Learners:

@Article{MaskedAutoencoders2021,

author = {Kaiming He and Xinlei Chen and Saining Xie and Yanghao Li and Piotr Doll{'a}r and Ross Girshick},

journal = {arXiv:2111.06377},

title = {Masked Autoencoders Are Scalable Vision Learners},

year = {2021},

}

Implementasi aslinya ada di TensorFlow+TPU. Implementasi ulang ini ada di PyTorch+GPU.

Repo ini merupakan modifikasi dari repo DeiT. Instalasi dan persiapan mengikuti repo itu.

Repo ini didasarkan pada timm==0.3.2 , yang memerlukan perbaikan agar dapat berfungsi dengan PyTorch 1.8.1+.

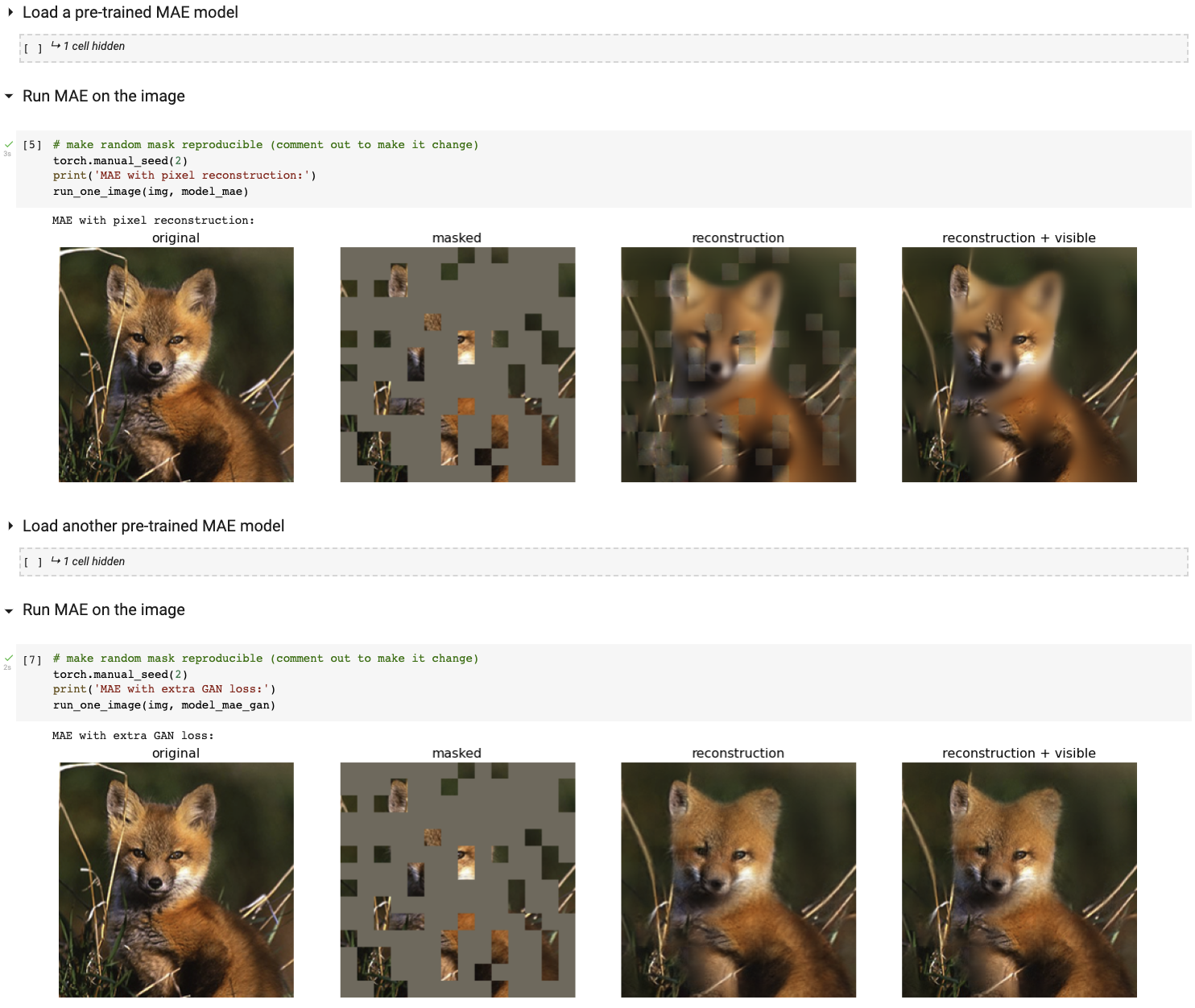

Jalankan demo visualisasi interaktif kami menggunakan notebook Colab (tidak memerlukan GPU):

Tabel berikut menyediakan pos pemeriksaan terlatih yang digunakan dalam makalah, dikonversi dari TF/TPU ke PT/GPU:

| Basis ViT | ViT-Besar | ViT-Besar | |

|---|---|---|---|

| pos pemeriksaan terlatih | unduh | unduh | unduh |

| md5 | 8cad7c | b8b06e | 9bdbb0 |

Petunjuk penyetelan halus ada di FINETUNE.md.

Dengan menyempurnakan model terlatih ini, kami memberi peringkat #1 dalam tugas klasifikasi berikut (dirinci dalam makalah):

| ViT-B | ViT-L | ViT-H | ViT-H 448 | sebelumnya yang terbaik | |

|---|---|---|---|---|---|

| ImageNet-1K (tidak ada data eksternal) | 83.6 | 85.9 | 86.9 | 87.8 | 87.1 |

| berikut adalah evaluasi bobot model yang sama (disesuaikan dengan ImageNet-1K asli): | |||||

| ImageNet-Korupsi (tingkat kesalahan) | 51.7 | 41.8 | 33.8 | 36.8 | 42.5 |

| ImageNet-Permusuhan | 35.9 | 57.1 | 68.2 | 76.7 | 35.8 |

| Rendisi ImageNet | 48.3 | 59.9 | 64.4 | 66.5 | 48.7 |

| Sketsa ImageNet | 34.5 | 45.3 | 49.6 | 50.9 | 36.0 |

| berikut adalah pembelajaran transfer dengan menyempurnakan MAE yang telah dilatih sebelumnya pada kumpulan data target: | |||||

| iNaturalis 2017 | 70.5 | 75.7 | 79.3 | 83.4 | 75.4 |

| iNaturalis 2018 | 75.4 | 80.1 | 83.0 | 86.8 | 81.2 |

| iNaturalis 2019 | 80,5 | 83.4 | 85.7 | 88.3 | 84.1 |

| Tempat205 | 63.9 | 65.8 | 65.9 | 66.8 | 66.0 |

| Tempat365 | 57.9 | 59.4 | 59.8 | 60.3 | 58.0 |

Instruksi pra-pelatihan ada di PRETRAIN.md.

Proyek ini berada di bawah lisensi CC-BY-NC 4.0. Lihat LISENSI untuk detailnya.