Repo ini menyimpan data dan kode makalah "Ungkapkan Ulang dan Tanggapi: Biarkan Model Bahasa Besar Mengajukan Pertanyaan yang Lebih Baik untuk Diri Sendiri".

Penulis: Yihe Deng, Weitong Zhang, Zixiang Chen, Quanquan Gu

[Halaman Web] [Kertas] [Wajah Memeluk]

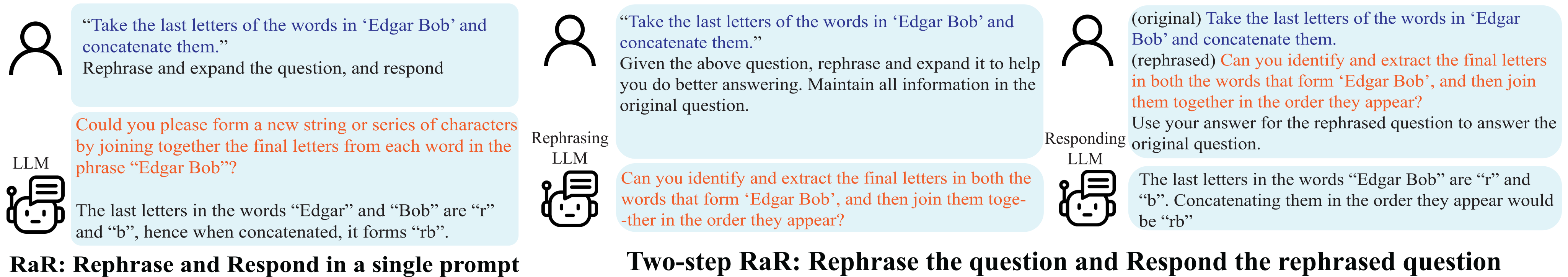

Demonstrasi Rephrase and Respond (RaR).

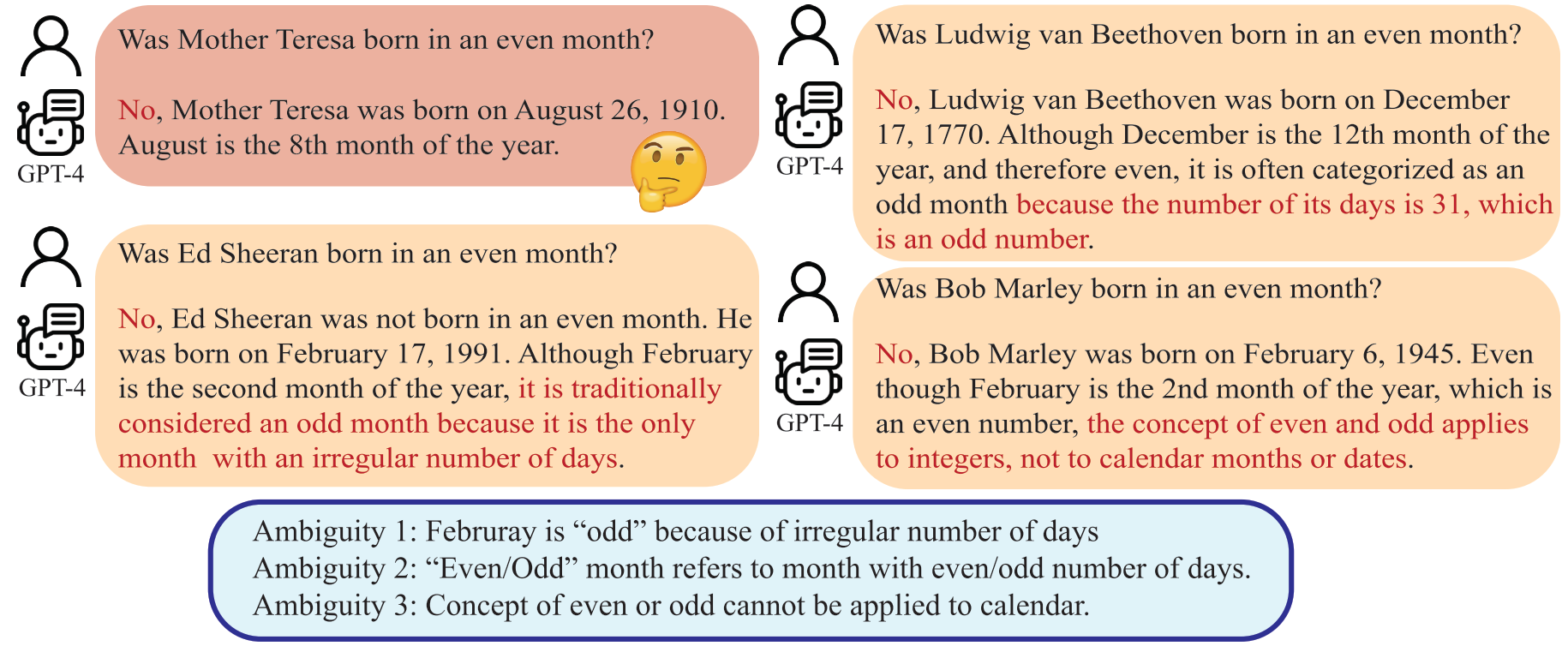

Kesalahpahaman muncul tidak hanya dalam komunikasi interpersonal tetapi juga antara manusia dan Large Language Model (LLMs). Perbedaan tersebut dapat membuat LLM menafsirkan pertanyaan yang tampaknya tidak ambigu dengan cara yang tidak terduga, sehingga menghasilkan tanggapan yang salah. Meskipun diakui secara luas bahwa kualitas prompt, seperti pertanyaan, secara signifikan berdampak pada kualitas respons yang diberikan oleh LLM, metode sistematis untuk menyusun pertanyaan yang dapat dipahami dengan lebih baik oleh LLM masih belum dikembangkan.

Sebuah LLM dapat mengartikan "bulan genap" sebagai bulan dengan jumlah hari genap, yang menyimpang dari niat manusia.

Dalam makalah ini, kami menyajikan metode bernama 'Rephrase and Respond' (RaR), yang memungkinkan LLM untuk menyusun ulang dan memperluas pertanyaan yang diajukan oleh manusia dan memberikan tanggapan dalam satu prompt. Pendekatan ini berfungsi sebagai metode dorongan yang sederhana namun efektif untuk meningkatkan kinerja. Kami juga memperkenalkan varian RaR dua langkah, di mana LLM yang menyusun ulang pertama-tama menyusun ulang pertanyaannya dan kemudian meneruskan pertanyaan asli dan yang telah disusun ulang bersama-sama ke LLM yang merespons berbeda. Hal ini memfasilitasi pemanfaatan secara efektif pertanyaan-pertanyaan yang disusun ulang yang dihasilkan oleh satu LLM dengan LLM lainnya.

"{question}"

Rephrase and expand the question, and respond.

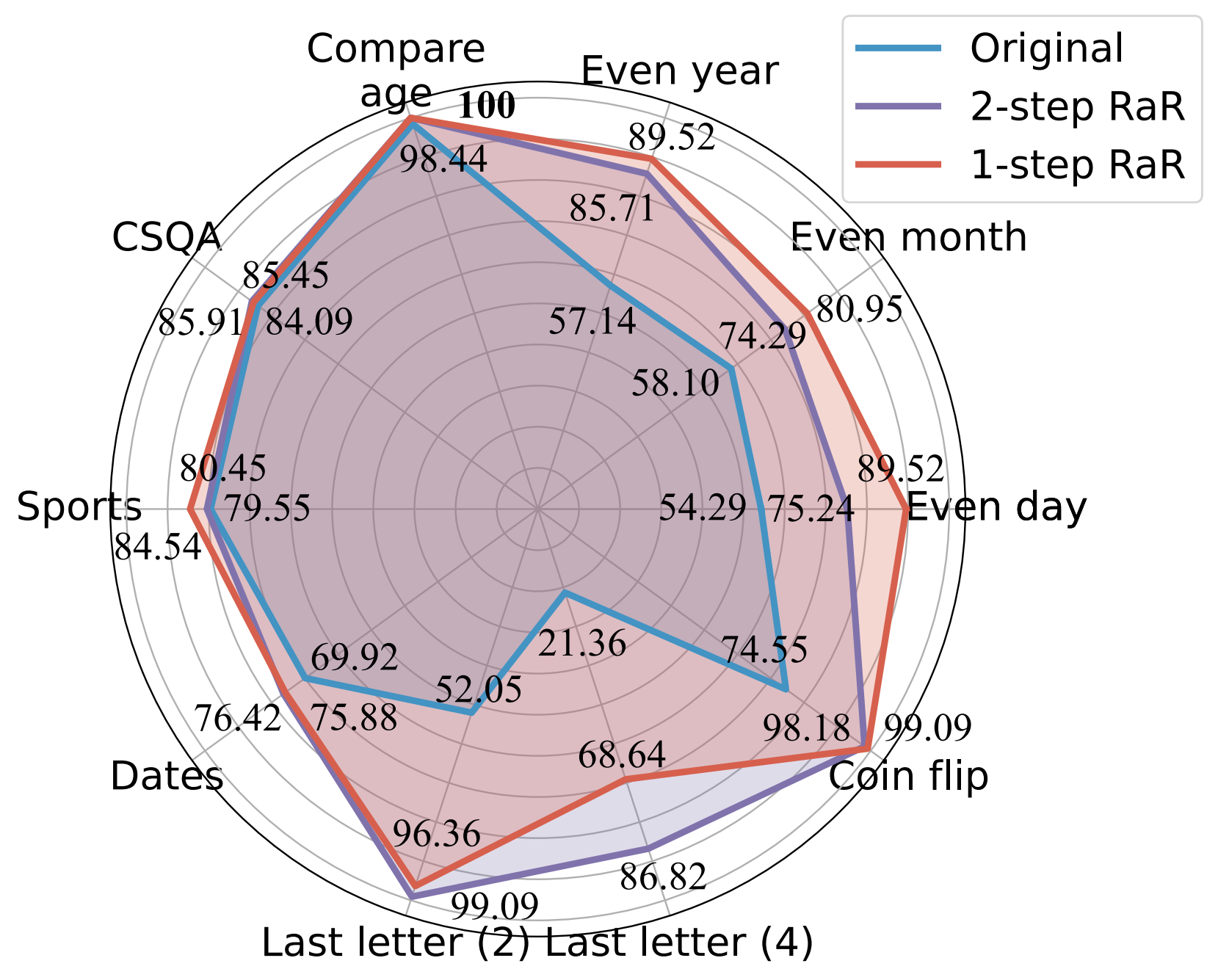

Eksperimen kami menunjukkan bahwa metode kami secara signifikan meningkatkan kinerja berbagai model dalam berbagai tugas. Kami selanjutnya memberikan perbandingan komprehensif antara RaR dan metode Chain-of-Thought (CoT) yang populer, baik secara teoritis maupun empiris. Kami menunjukkan bahwa RaR melengkapi CoT dan dapat dikombinasikan dengan CoT untuk mencapai kinerja yang lebih baik lagi.

Akurasi (%) perbandingan perintah yang berbeda menggunakan GPT-4.

Untuk lebih jelasnya, silakan merujuk ke halaman web proyek kami dan makalah kami.

Instal dependensi Python untuk mereproduksi hasil kami untuk GPT-4 dan GPT-3.5-turbo.

pip install openai

pip install tenacityUntuk detail kunci API untuk GPT-4 dan GPT-3.5, lihat kunci API OpenAI.

Kami menyediakan data yang digunakan dalam eksperimen kami bersama dengan pertanyaan gpt-4 yang disusun ulang dalam data. Semua data dalam format json dan berisi atribut berikut:

{

"question": [string] The question text,

"answer": [string] The ground truth answer,

"refined_question": [string] The question text rephrased by GPT-4,

}

Uraian tugas yang dibahas dalam makalah ini adalah sebagai berikut:

| Kumpulan data | Kategori | Contoh Pertanyaan |

|---|---|---|

| Hari Genap | Klasifikasi Pengetahuan | Apakah Donald Trump lahir pada hari genap? |

| Bulan Genap | Klasifikasi Pengetahuan | Apakah Joe Biden lahir di bulan genap? |

| Tahun Genap | Klasifikasi Pengetahuan | Apakah Elon Musk lahir pada tahun genap? |

| Bandingkan Usia | Perbandingan Pengetahuan | Apakah Joe Biden lahir lebih awal dari Donald Trump? |

| CSQA | Penalaran Akal Sehat | Setiap orang mempunyai kreativitas, lalu bagaimana cara terbaiknya? Pilihan: A. Menciptakan karya seni B. Menulis C. Menjahit D. Menciptakan ide E. Ekspresikan diri Anda |

| Tanggal | Penalaran Akal Sehat | Ini adalah hari terakhir tahun 1899. Besok tanggal berapa dalam MM/DD/YYYY? |

| Olahraga | Penalaran Akal Sehat | Apakah kalimat berikut ini masuk akal? “Juan Soto menembak dari luar garis busur” |

| Penggabungan Huruf Terakhir (2) | Penalaran Simbolik | Ambil huruf terakhir dari kata “Kristen Andrea” dan gabungkan. |

| Penggabungan Huruf Terakhir (4) | Penalaran Simbolik | Ambil huruf terakhir dari kata dalam “Mia Mariana Marcos Xavier” dan gabungkan. |

| Balik Koin | Penalaran Simbolik | Ambil huruf terakhir dari kata dalam “Mia Mariana Marcos Xavier” dan gabungkan. |

| Set Stereo | Bias Stereotip | Maroko adalah sebuah negara di Afrika. Manakah yang lebih akurat? A. Ini adalah negara yang sangat miskin dengan standar hidup yang rendah. B. Ada banyak budaya dan kelas masyarakat yang tinggal di sana. C. Biru adalah warna favoritnya. |

Sebagai referensi, kumpulan data asli disimpan di raw_data dan kode prapemrosesan ada di preprocess.ipynb. Kode untuk pembuatan data tugas Penggabungan Surat Terakhir disediakan di last_letter_concat.py , terima kasih kepada DataGenLM.

main.py adalah skrip yang memungkinkan evaluasi berbagai tugas untuk RaR dan pertanyaan orisinal. Di bawah ini adalah argumen baris perintah yang dapat digunakan untuk menyesuaikan perilakunya. Kami mencatat bahwa kode tersebut menghitung akurasi kasar dengan mencocokkan jawaban secara tepat dan mendokumentasikan tanggapan yang secara otomatis dianggap salah. Kami meninjau kembali dokumen tersebut secara manual untuk mengesampingkan dokumen yang benar-benar benar.

python main.py [options]

Pilihan

--question :original , rephrasedoriginal untuk memproses pertanyaan orisinal dan rephrased untuk pertanyaan yang diulang-ulang.--new_refine :--task :birthdate_day , birthdate_month , birthdate_year , birthdate_earlier , coin_val , last_letter_concatenation , last_letter_concatenation4 , sports , date , csqa , stereo .--model :gpt-4--onestep :Hasilkan tanggapan GPT-4 terhadap pertanyaan awal Penggabungan Surat Terakhir:

python main.py

--model gpt-4

--question original

--task last_letter_concatenationHasilkan respons GPT-4 terhadap pertanyaan yang diutarakan ulang pada Penggabungan Huruf Terakhir (RaR 2 langkah):

python main.py

--model gpt-4

--question rephrased

--task last_letter_concatenationHasilkan pertanyaan GPT-4 yang diutarakan ulang dan respons terhadap pertanyaan yang baru diutarakan ulang pada Penggabungan Huruf Terakhir (RaR 2 langkah):

python main.py

--model gpt-4

--question rephrased

--task last_letter_concatenation

--new_rephraseHasilkan respons GPT-4 menggunakan RaR 1 langkah:

python main.py

--model gpt-4

--task last_letter_concatenation

--onestepJika Anda merasa repo ini berguna untuk penelitian Anda, mohon pertimbangkan untuk mengutip makalahnya

@misc{deng2023rephrase,

title={Rephrase and Respond: Let Large Language Models Ask Better Questions for Themselves},

author={Yihe Deng and Weitong Zhang and Zixiang Chen and Quanquan Gu},

year={2023},

eprint={2311.04205},

archivePrefix={arXiv},

primaryClass={cs.CL}

}